SwarmSight: Echtzeit-Tracking von Insekten Antenne Bewegungen und Rüssel Erweiterung Reflex mit einem gemeinsamen Vorbereitung und konventioneller Hardware

Summary

Dieses Protokoll beschreibt Schritte zur Nutzung der neuartigen Software, SwarmSight, für Frame-by-Frame-Tracking von Insekt Antenne und Rüssel Positionen von herkömmlichen Web Kamera Videos mit konventionellen Computern. Die kostenlose, Open-Source-Software verarbeitet Bilder etwa 120 Mal schneller als Menschen und führt zu besser als menschliche Genauigkeit.

Abstract

Viele wissenschaftlich und landwirtschaftlich wichtige Insekten verwenden Antennen, um das Vorhandensein von flüchtigen chemischen Verbindungen erkennen und erweitern ihre Rüssel während der Fütterung. Die Fähigkeit, schnell erhalten hochauflösende Messungen von natürlichen Bewegungen der Antenne und Rüssel und beurteilen, wie sie in Reaktion auf chemische, Entwicklungs- und genetische Manipulationen verändern kann helfen, das Verständnis der Insekten Verhalten. Durch die Erweiterung unserer bisherigen Arbeiten zur Bewertung der aggregierten Insekten Schwarm oder Tiergruppe Bewegungen aus natürlichen und Labor-Videos, die mit Hilfe der Videoanalyse-Software SwarmSight, entwickelten wir eine neuartige, freie und Open-Source Software-Modul SwarmSight Anhängsel Tracking (SwarmSight.org) für Frame-by-Frame-Tracking von Insekten Antenne und Rüssel Positionen von herkömmlichen Web Kamera Videos mit konventionellen Computern. Die Software verarbeitet Bilder etwa 120 Mal schneller als Menschen, führt zu besser als menschliche Genauigkeit und, mit 30 Frames pro zweite (fps) Videos können erfassen Riechzentrum Dynamik bis zu 15 Hz. Die Software wurde verwendet, um das Riechzentrum Antwort von Honigbienen auf zwei Gerüche zu verfolgen und fand bedeutende mittlere Riechzentrum Einziehungen Weg von der Geruch Quelle etwa 1 s nach Geruch Präsentation. Wir beobachteten Antenne Position Dichte Wärme Karte Clusterbildung und Cluster und meine Abhängigkeit Winkel von Geruch Konzentration.

Introduction

Die meisten Arthropoden bewegen Antennen oder andere Anhängsel, ökologische Hinweise und Signale in Raum und Zeit zu probieren. Die Antennen können die Tiere ihrer Umgebung navigieren durch das Erkennen von sensorischen Signale wie flüchtigen chemischen Stoffen und geschmackliche und mechanische Reize1,2,3,4. Bei Insekten enthalten die Antennen sensorische Rezeptoren, die an flüchtigen chemischen Stoffen4,5,6 binden und übertragen dieses Signal über olfaktorischen sensorischen Neuronen auf zentrales Gehirn Regionen1,7 ,8,9. Die Insekten können um Informationen zu eingehenden Gerüche4,10,11modulieren Antennen Positionen anpassen. Diese Modulation ermöglicht aktiv informierte Verhaltensreaktionen auf Gerüche und ihre Federn12,13.

Viele Insekten, darunter Hautflügler (z. B. Honigbienen und Hummeln), Schmetterlinge (z. B. Schmetterlinge) und Dipteren (z.B., fliegen und Mücken), unter anderem feed durch die Ausweitung ihrer Rüssel14 , 15 , 16 , 17 , 18 , 19 , 20 , 21. Rüssel Erweiterung zuverlässig betätigt wurde in der Vergangenheit für eine Vielzahl von lernen und Gedächtnis Aufgaben22,23,24,25,26, 27,28,29,30,31. Quantitative Bewertung der Antennen-Bewegung mit hoher zeitlicher und räumlicher Auflösung könnte in ähnlicher Weise Einblick in die Beziehung zwischen der Reiz, das Verhalten und die inneren Zustand des Tieres ergeben. In der Tat Vorarbeiten hat gezeigt, wie die Riechzentrum Bewegungen enthalten eine reiche Menge von Informationen über Honig Biene-Tracking der Umwelt und wie die Bewegungen ändern mit32,33,34lernen, 35,36,37,38.

In den letzten zehn Jahren wurden Methoden zur Beobachtung von Verhaltens der Tieren stark durch Fortschritte in der hochauflösenden Video-Kameras, Computer, Verarbeitungsgeschwindigkeit und Machine-Vision-Algorithmen, beschleunigt. Aufgaben wie das Tier erkennen, zählen, Tracking und Standortanalysen Präferenz haben mit ausgeklügelte Software, die Videos des Tierverhaltens verarbeiten kann gefördert worden und Extrakt relevanten misst39,40, 41,42,43,44,45,46,47.

Diese Technologien haben auch Verfolgung von Insekten Antenne und Rüssel Bewegungen gefördert. Es ist möglich, dass menschliche Rater einen Mauscursor verwenden, um manuell die Position der Antennen zu verfolgen. Während dieser Methode genau sein kann, die Aufgabe ist jedoch zeitaufwendig, und menschliche Unaufmerksamkeit und Müdigkeit unzuverlässigen Ergebnissen führen können. Spezielle Ausrüstung und Vorbereitung können verwendet werden, um die Notwendigkeit für komplexe Software zu reduzieren. Zum Beispiel ein Setup verwendet eine Hochgeschwindigkeitskamera und malte die Spitzen der Antennen, die Antenne Bewegung48zu verfolgen. Benutzer können auch Schlüssel-Frames des Videos, die Software zu unterstützen, bei der Aufdeckung von der Antenne und Rüssel Standort49auswählen aufgefordert. Ein weiterer Ansatz erkannt die zwei größten Bewegung Cluster um Antennen zu identifizieren, aber es erkennt nicht den Rüssel Lage50. Ein anderes Softwarepaket kann Antenne und Rüssel Standorte erkennen, aber erfordert ca. 7,5 s von Bearbeitungszeit pro Frame51, die unerschwinglich für Echtzeit- oder langfristige Beobachtung Studien sein könnte. Schließlich, es könnte möglich sein, kommerzielle Software-Pakete (z. B. EthoVision) zum Ausführen der Aufgabe46anpassen, ihre Kosten für Lizenzierung und Ausbildung können jedoch unerschwinglich.

Mit dem hier beschriebenen Verfahren verlängern wir unsere bisherige Arbeit auf Bewegung Analyse Software41 , die Standorte der Insekten Antennen und Rüssel mit den folgenden Zielen zu verfolgen: (1) keine Notwendigkeit, spezielle Hardware oder komplexe tierische Vorbereitung (2). Frame-Verarbeitung in Echtzeit (30 fps oder schneller) auf einem herkömmlichen Computer (3) einfache Verwendung und (4) Open-Source, leicht erweiterbar Code.

Die daraus resultierende neue Methode und Open Source Software, SwarmSight Anhängsel Tracking, erfordert keine Malerei der Antennen-Tipps, kann eine Verbraucher-Web-Kamera verwenden, um Videos und Prozesse video-Frames mit 30-60 fps auf einem herkömmlichen Computer (erfassen ( Abbildung 1). Die Software übernimmt die video-Dateien als Eingabe. Der Benutzer lokalisiert die Position des Kopfes Insekten in dem Video, und nach der Verarbeitung entsteht eine durch Komma getrennte Werte (CSV) Datei mit den Standorten der Antennen und Rüssel. Die Software ist in der Lage Hunderte von verschiedene video-Formate (einschließlich der Formate, die von den meisten Digitalkameras produziert) durch den Einsatz von FFmpeg Bibliothek52lesen.

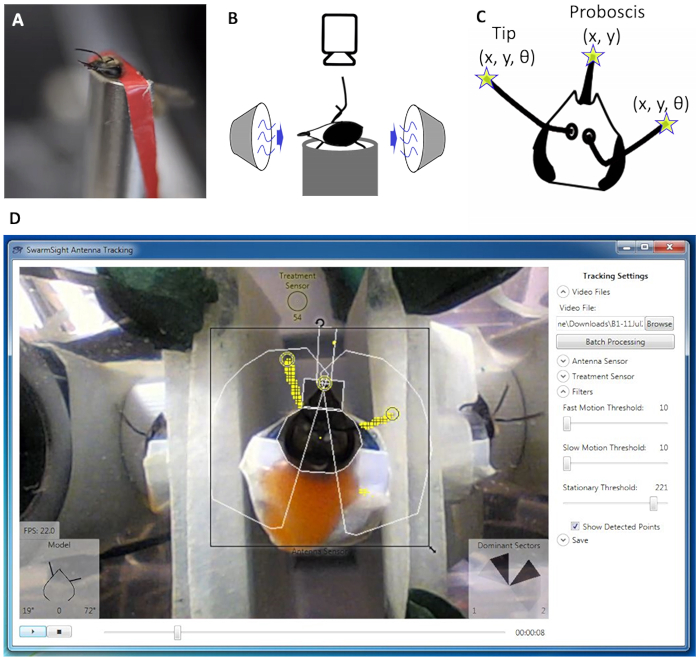

Abbildung 1: tierische Setup und Software Ausgabe. (A) A Honig Biene Sammler mit seinem Kopf und Körper in einem Kabelbaum zurückgehalten. (B) Geruch Quelle sich vor dem Tier, eine Videokamera befindet befindet sich oben, und eine Vakuumquelle befindet sich hinter dem Tier. (C) die Antenne Tip und Rüssel Variablen erkannt durch die SwarmSight-Software aus dem Video. (D) der Benutzer Positionen den Antenne Sensor über das Tier und passt die Filterparameter. Die Software erkennt die Antenne und Rüssel Positionen (gelbe Ringe).Bitte klicken Sie hier, um eine größere Version dieser Figur.

Erstens sind ein Insekt Körper und den Kopf in einem Kabelbaum Verhalten, so dass die Antenne und Rüssel Bewegungen leicht (Abbildung 1A) eingehalten werden. Eine Geruch-Quelle wird vor das Insekt mit einer Vakuumquelle platziert hinter, die Gerüche aus der Luft entfernen und minimieren potenzielle Auswirkungen der sensorischen Adaption (Abbildung 1 b) aufgestellt. Eine herkömmliche Webkamera wird über das Insekt Kopf auf einem Stativ platziert. Eine LED kann positioniert werden, innerhalb der Kamera-Ansicht, um anzuzeigen, wenn der Geruch präsentiert wird.

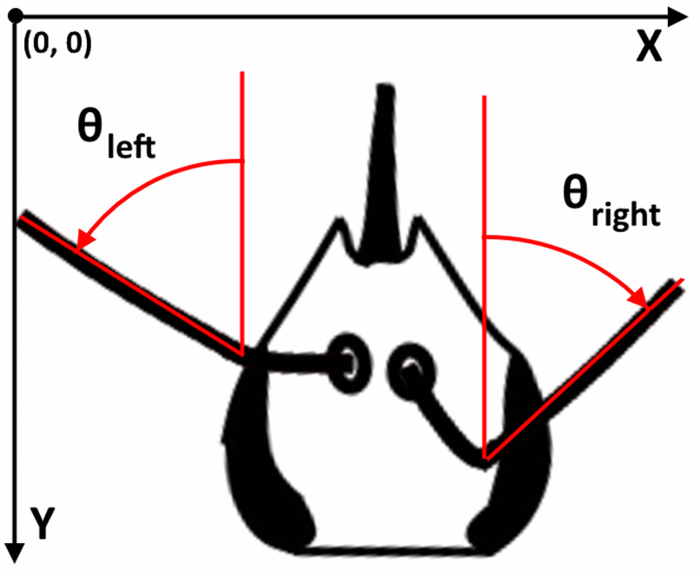

Abbildung 2: Antenne Koordinatensystem. X, Y-Werte der video Koordinatensystem verwenden, wo ist oben links den Ursprung und die X- und Y-Werte erhöhen, wenn in Richtung der unteren rechten Ecke. Winkel werden in Grad in Bezug auf die Vorderseite des Kopfes (in der Regel die Geruch-Quelle) ausgedrückt. Dem Wert “0” bedeutet, dass die Linie gebildet durch die Antenne Flagellum direkt vor das Tier weist. Alle Winkel sind positiv, außer wenn eine Antenne weist auf die entgegengesetzte Richtung (z. B. richtige Flagellum Punkte auf der linken Seite). Bitte klicken Sie hier für eine größere Version dieser Figur.

Nach den Dreharbeiten, wird die Videodatei mit der SwarmSight-Software geöffnet, wo der Benutzer Positionen der Antenne Sensor Widget (Abbildung 1, schwarzes Quadrat) über den Kopf des Insekts und beginnt die Videowiedergabe. Wenn die Ergebnisse gespeichert werden, die CSV-Datei enthält die X-und Y-Positionen der Antenne-Tipps, die Antenne Winkel im Verhältnis zu der Vorderseite des Kopfes (Abbildung 2) und den Rüssel X, Y-Position. Darüber hinaus wird eine dominierende Sektor Metrik für jede Antenne berechnet. Die metrische zeigt, die welche der fünf 36-Grad-Sektoren rund um jede Antenne die meisten Punkte enthalten als wahrscheinlich die Antennen und können nützlich sein, wenn die Antenne Positionswinkel/Metriken nicht zuverlässig durch laute oder anderweitig problematische Videos sind.

Kurz gesagt, funktioniert die Software mithilfe eines Satzes von Bewegung Filter53 und eine entspannte Flut Füllung Algorithmus54. Zwei Filter werden verwendet, um wahrscheinlich Antenne Punkte zu finden: eine 3-Mal in Folge-Frame Unterschied Filter41,55 und Median Hintergrundabzug56 Filter. Schwelle Farbfilter Abstand dient zur Erkennung Rüssel. Die oberste 10 % der Punkte der einzelnen Filter kombiniert, und ein Flut-Füllung-Algorithmus, der zusammenhängenden Punkte mit Lücken bis zu 2 Pixel (px) inspiziert lokalisiert Extrempunkte. Parallele Dekodierung Frame, Verarbeitung, und Rendering-Pipelines und optimierte Speicher Zuweisung des Datenflusses Filter hohen Leistung erreicht. Die rohen x und y Koordinatenwerte produziert von der Software sind nach der Verarbeitung mit einem 3-Frame rollenden Medianfilter57 (siehe Diskussion). Die Anweisungen, um den vollständigen Quellcode herunterzuladen finden Sie Online-58.

Unten ist ein Protokoll zur Antenne tracking ein Honig Biene Forager Vorbereitung. Ein ähnliches Protokoll könnte verwendet werden, um die Antenne/Rüssel Bewegungen des anderen Insekts zu verfolgen. Im Abschnitt “Ergebnisse” beschreiben wir eine Probe Antenne Trace-Ausgabe, die von der Software, der Vergleich der Software-Ausgabe auf Tracking durchgeführt durch menschliche Rater und Bewertung des Antennen-Bewegung als Reaktion auf fünf Geruchsstoffe erkannt wird.

Protocol

Representative Results

Discussion

Die hier vorgestellte Methode ermöglicht Echtzeit-Verfolgung von Insekten Antenne und Rüssel Bewegungen ohne besondere Tierpräparate oder Hardware.

Einschränkungen:

Trotz dieser Vorteile gibt es einige Einschränkungen der Methode. Dazu gehören die Anforderung, dass der Kopf des Tieres aus Bewegung, muss der Benutzer die Position und Ausrichtung des Tieres für jedes Video auswählen eingeschränkt ist die Forderung nach Zugang zu einem Windows-Computer und die Software Unfähigkeit zu verfolgen Bewegung in drei Dimensionen (3D) und in einigen visuell mehrdeutige Anhängsel Positionen beschrieben.

Die Software erfordert, dass der Kopf des Tieres fixiert ist und sich nicht während des Videos bewegt. Dies ist vergleichbar mit den Vorbereitungen der vorherigen Arbeit48,49,50,51. Es ist möglich, die automatische Erkennung von Kopfdrehungen ermöglichen anzupassen, dies würde verbrauchen zusätzliche Bearbeitungszeit und eine neue Fehlerquelle vorstellen. Würden die modifizierte Software die Rotation des Kopfes nicht richtig erkennen, würde dies die Antennen-Winkel beeinträchtigen, da ihre Berechnung im Verhältnis zu den Kopf Drehwinkel ist. Derzeit, wählt der Benutzer die Ausrichtung des Kopfes einmal pro Video. Dieser Ansatz minimiert während nicht ohne menschliches Versagen, Winkel Berechnungsfehler, wenn der Kopf nicht zulässig ist, während das Video bewegen.

Die Software erfordert auch ein Windows 7 (oder höher) Operating System (OS). Ziel war es, machen die Software einfach zu installieren, einrichten und verwenden von Benutzern ohne Programmier- oder anspruchsvolle EDV-Verwaltung-Kenntnisse. Wir beschlossen, Ziel Windows, denn es weit verbreitet ist, und in Fällen, wo Zugriff darauf beschränkt ist, virtuelle Maschinen (z. B. VirtualBox, VMware, Parallels) mit Windows leicht erstellt werden können. Diese Wahl der OS stark vereinfacht die Software-Installation durch eine einfach zu bedienende, command-line-freie Installer und vermeidet Fehler, die spezifisch für verschiedene Betriebssysteme.

Die Software verfolgt nur die Position der Gliedmaßen im 2D-Raum. Insekten sind dafür bekannt, ihre Antenne bewegen in 3D, was bedeuten könnte, dass wichtige Informationen verloren geht, wenn nur 2D Koordinaten gemessen werden. Während die Verwendung von mehreren Kameras oder Spiegel helfen konnte, die zusätzliche benötigte Angaben für 3D Lokalisierung zu sammeln, ist es möglich, mit dem Einsatz von trigonometrischen Beziehungen, eine geschätzte Out-of-Plane-Position durch Berechnung geht man davon aus, dass die Antennen sind einzelne Liniensegmente konstanter Länge und nur auf einer Seite der Kameraebene bewegen. Für Honigbienen diese Annahme gilt, grobe Schätzungen für die Position in 3D zu erhalten, aber nicht notwendigerweise der Fall wäre für andere Arten und Situationen.

Die Software wird nicht korrekt erkennen, die Antennen und Rüssel Tipp Standorte in einige unklare Situationen. Wenn ein Tier eine Antenne bewegt sich so, dass in dem Video, es einen längeren Rüssel überlappt, erkennt die Software wahrscheinlich die Spitze der Antenne als die Spitze der Rüssel. Der Antenne Winkel wird jedoch nach wie vor wahrscheinlich richtig (aus dem nicht-überlappende Teil) berechnet werden. In ähnlicher Weise bewegt sich die Antenne Tipps direkt über dem Kopf des Tieres (d. h. nicht an den Seiten) könnte dann die Software nur erkennen, die Teil der Antenne, die außerhalb der Kopf sichtbar ist übernehmen die früheren Standort der Antenne oder unechte zu erkennen Bildrauschen als Antennenstandort. In beiden Fällen haben auch die menschliche Rater Schwierigkeit anspruchsvolle die Antenne aus dem Rüssel oder den Kopf. Um dieses Problem zu umgehen, empfehlen wir, Anwenden eines 3-Frame, symmetrischen rollenden Median57 Filters auf die rohen X und Y Koordinaten durch die Software produziert. Dieser Filter entfernt große transient (Einzelbild) Position Schwankungen und längere Antenne Position Bewegungen bewahrt. Wir haben festgestellt, dass der 3-Frame-Filter entwickelten sich besser als kein Filter, während die breitere Filter (z. B. 5, 11 oder 15 Frames) Genauigkeit reduziert. R-Beispielcode, der Filter und ein video-Tutorial verwendet, finden Sie Online-58.

Wert als ein wissenschaftliches Instrument:

Die Verfügbarkeit einer Methode schnell genaue Insekt Anhängsel Bewegungen in einer kosteneffektiven Weise zu erhalten, hat das Potenzial, Erschließung neuer Untersuchung.

Rüssel Erweiterung Reflex (PER) ist eine häufig verwendete Verhaltensreaktion, lernen und Gedächtnis einer Vielzahl von Insekten59zu untersuchen. Frühere Studien haben in der Regel auf eine binäre verlängert oder nicht-Maßnahme von PER, verlassen, obwohl Video- und elektromyographische Untersuchungen, viel komplexere Topologien Rüssel Bewegungen65,66 gezeigt haben. Die Methode hier ermöglicht schnelle Quantifizierung der Rüssel Bewegungen in hoher zeitlicher und räumlicher Auflösung.

Insekt Antenne Bewegungen als Reaktion auf Gerüche sind kaum erforscht. Ein Grund dafür ist, dass die Antennen sind in der Regel so schnell bewegen, dass kostengünstige, automatisierte Mittel zur Antenne Bewegungsdaten zu erhalten nicht verfügbar ist. Die hier vorgestellte Methode ließe sich schnell Antenne Bewegungsdaten für eine große Anzahl von Insekten in eine große Anzahl von Bedingungen zu erhalten. Dies könnte zum Beispiel Forscher untersuchen die Zuordnung zwischen Antenne Bewegungen in Reaktion auf verschiedene Reize, insbesondere flüchtige Gerüche Beihilfen. Mit Kameras, die Bilder bei 30 Hz zu erfassen, die Software kann verwendet werden, um Riechzentrum Bewegungsdynamik charakterisieren bis zu 15 Hz (Nyquist-Grenze). Bei Bedarf Charakterisierung in höheren Frequenzen könnten Kameras mit höheren Datenerfassungsraten (z. B. 60 oder 120 fps) genutzt werden. Jedoch möglicherweise ein schneller Rechner müssen höhere fps-Videos in Echtzeit zu verarbeiten. Wir spekulieren, dass Klassen von Gerüchen und vielleicht sogar einige einzelne Gerüche charakteristischen angeborene Riechzentrum Bewegungen haben. Wäre diese Klassen oder Verbindungen entdeckt, unbekannte konnte Gerüche oder ihrer Klasse aus Riechzentrum Bewegung der ungeübte Insekten nachgewiesen werden. Wenn solch eine Zuordnung vorhanden ist, sollte die Kombination von ausreichend Antenne Bewegungsdaten und State-Of-The-Art Machine learning Algorithmen beginnen, um es zu entdecken. Auch, wie diese Zuordnung als Reaktion auf Lernformen im Laufe der Entwicklung verändert oder gestört ist mit könnten genetische Interventionen Einblick in die Funktionen des olfaktorischen Systems anbieten.Schließlich könnte diese Arbeit geben Einblick in künstliche Erkennung von Gerüchen, wenn es optimale Probenahmeverfahren für Gerüche in komplexen Umgebungen zeigt.

Zukünftige Arbeit:

Hier zeigten wir, dass die Antenne Bewegungsdaten schnell gewonnen und analysiert werden können: bedeutende Verhalten Antworten aus den Daten generiert durch unsere Software erkannt werden, und mehrere Bereiche der weiteren Untersuchung ermittelt wurden.

Die Zeit Kurse der Reiz ausgelöst Antenne Winkel Abweichungen und Wiederherstellung zur Grundlinie und Reiz-Abschluss Rebound-Effekte und seine Abhängigkeit auf Geruch Konzentration untersucht und mathematisch modelliert werden können. Darüber hinaus Änderungen der Antenne Bewegungen induziert durch begehrliche oder aversive Konditionierung auch mit der Software beurteilt werden kann.

Bessere Differenzierung von Gerüchen zu erkunden. In dieser Studie, Gerüche, in reiner und 35 x verdünnten Versionen entlockte ähnliche Reaktionen: die Antennen im Durchschnitt schien schnell weg von der Quelle Geruch zurückziehen und vor Geruch Basislinien nach ein paar Sekunden zurück. Wir spekulieren, dass sogar die verdünnten Versionen sehr starke olfaktorische Reize für die Honigbienen gewesen sein mag. Wenn “true”, könnte eine breitere Palette von Konzentrationen verwendet werden, um festzustellen, ob die Riechzentrum Antworten die Gerüche unterscheiden. Darüber hinaus kann komplexere Analyse Unterschiede im Riechzentrum Bewegungen als Reaktion auf verschiedene Gerüche besser offenbaren. Wir haben die Datendateien verwendet, um Zahlen in diesem Manuskript zur Verfügung, um interessierten Forscher auf der SwarmSight Webseite67generieren.

Darüber hinaus konnte zwar nicht in den Anwendungsbereich dieser Handschrift, die Software erweitert werden um Videos von Tieren platziert in Kammern mit zwei Spiegeln, die Winkel von 45° (siehe Abbildung 1 zum Beispiel) zu verarbeiten. Dies könnte verwendet werden, um genau zu lokalisieren und zu verfolgen, die Gliedmaßen und ihre Bewegung im 3D-Raum. Jedoch die Algorithmen für 3D-Tracking wäre erforderlich, um effizient: (a) zu unterscheiden zwischen mehreren Antennen, wenn sie in einer der die Seitenspiegel, (b) für Mängel im Spiegel Winkel korrekt sichtbar und (c) Verzerrungen durch Kamera entfallen Positionierung.

Zu guter Letzt zusätzliche Gewinne in der Positionsgenauigkeit könnte durch den Einsatz von einem Kalman Filter68, welche Modelle realisiert werden und nutzt Aggregatzustand Informationen wie Anhängsel Geschwindigkeits- und Beschleunigungswerte vorhergesagten Standorte beschränken. Allerdings sollte keine Gewinne in der Genauigkeit gegen Kürzungen in der Geschwindigkeit durch zusätzliche Berechnungen ausgewertet werden.

Fazit:

Viele Insekten nutzen Antennen, um flüchtige Verbindungen in ihrem lokalen Umfeld aktiv zu probieren. Muster im Riechzentrum Bewegungen können Einblick in die Insekten Geruch Wahrnehmung und wie es Klimaanlage, toxische Verbindungen und genetische Veränderungen betroffen ist. In ähnlicher Weise wurden Rüssel Bewegungen zur Wahrnehmung der Geruch und der Modulation zu beurteilen. Jedoch ist es schwierig gewesen, schnell große Mengen an hochauflösenden Anhängsel Bewegungsdaten zu erhalten. Hier wird ein Protokoll und Software beschrieben, die diese Aufgabe automatisiert. Zusammenfassend haben wir erstellt und gezeigt, wie die Kombination von preiswerte Hardware, eine gemeinsame tierische Vorbereitung und die Open-Source-Software verwendet werden, um schnell hochauflösende Insekt Anhängsel Bewegungsdaten zu erhalten. Die Ausgabe der Software, wie es menschliche Rater in Geschwindigkeit und Genauigkeit übertrifft, und wie seine Ausgabedaten analysiert und visualisiert werden können wurden gezeigt.

Divulgations

The authors have nothing to disclose.

Acknowledgements

JB, SMC und RCG wurden von NIH R01MH1006674 SMC und NIH R01EB021711, RCG unterstützt. CMJ und BHS wurden unterstützt durch NSF Ideen Laborprojekt auf “Cracking the olfaktorischen Code” zu BHS. Kyle Steinmetz, Taryn Oboyle und Rachael Halby danken wir für ihre Unterstützung bei der Durchführung dieser Forschung.

Materials

| Insect harness | N/A | N/A | Use materials needed for Protocol sections 1-3.1.1 of Smith & Burden (2014) |

| Odor delivery source | N/A | N/A | Use materials needed for Protocol section 3 of Smith & Burden (2014) |

| Vacuum source | N/A | N/A | Use materials needed for Protocol section 3 of Smith & Burden (2014) |

| LED connected to odor delivery source | N/A | N/A | Use materials needed for Protocol section 3 of Smith & Burden (2014) |

| Low Voltage Soldering Iron | Stannol | Low Voltage Micro Soldering Iron 12V, 8W | |

| DC Power Supply | Tekpower | HY152A | |

| White sheet of paper | Georgia-Pacific | 998606 | Any white sheet of paper can be used as alternative |

| Tripod | AmazonBasics | 50-Inch Lightweight Tripod | Optional |

| Camera | Genius | WideCam F100 | FLIR Flea3 or another camera with manual focus can be used. |

| Camera software | Genius | N/A | Software comes with camera. On MacOS, Photo Booth app can be used to record videos. |

| Camera shutter speed software | Genius | N/A | Genius camera software allows shutter speed setting. In Mac OS, iGlasses by ecamm can be used instead: http://www.ecamm.com/mac/iglasses/ |

| Windows Operating System | Microsoft | Windows 7 Professional | Versions 7 or later are compatible. Oracle VirtualBox, Parallels Desktop, or VMWare Fusion can be used to create a Windows virtual machine in MacOS environments. |

| SwarmSight software | SwarmSight | Appendage Tracking | Download from http://SwarmSight.org |

| R software | R Project | R 3.4.0 | Download from: https://cran.r-project.org/bin/windows/base/ |

| R Studio software | RStudio | RStudio Desktop | Download from: https://www.rstudio.com/products/rstudio/download/ |

References

- Hansson, B. S. . Insect Olfaction. , (1999).

- Masson, C., Mustaparta, H. Chemical information processing in the olfactory system of insects. Physiol Rev. 70 (1), 199-245 (1990).

- Firestein, S. How the olfactory system makes sense of scents. Nature. 413 (6852), 211-218 (2001).

- Schneider, D. Insect antennae. Annu Rev Entomol. 9 (1), 103-122 (1964).

- Kaissling, K. Chemo-electrical transduction in insect olfactory receptors. Annu Rev Neurosci. 9 (1), 121-145 (1986).

- Nakagawa, T., Vosshall, L. B. Controversy and consensus: noncanonical signaling mechanisms in the insect olfactory system. Curr Opin Neurobiol. 19 (3), 284-292 (2009).

- Heisenberg, M. What do the mushroom bodies do for the insect brain? An introduction. Learn Memory. 5 (1), 1-10 (1998).

- Zars, T. Behavioral functions of the insect mushroom bodies. Curr Opin Neurobiol. 10 (6), 790-795 (2000).

- Heisenberg, M. Mushroom body memoir: from maps to models. Nature Rev Neurosci. 4 (4), 266-275 (2003).

- Pelletier, Y., McLEOD, C. D. Obstacle perception by insect antennae during terrestrial locomotion. Physiol Entomol. 19 (4), 360-362 (1994).

- Suzuki, H. Antennal movements induced by odour and central projection of the antennal neurones in the honey-bee. J Insect Physiol. 21 (4), 831-847 (1975).

- Wachowiak, M. All in a sniff: olfaction as a model for active sensing. Neuron. 71 (6), 962-973 (2011).

- Bruce, T. J., Wadhams, L. J., Woodcock, C. M. Insect host location: a volatile situation. Trends Plant Sci. 10 (6), 269-274 (2005).

- Lunau, K., Wacht, S. Optical releasers of the innate proboscis extension in the hoverfly Eristalis tenax L.(Syrphidae, Diptera). J Comp Physiol [A]. 174 (5), 575-579 (1994).

- Szucsich, N. U., Krenn, H. W. Morphology and function of the proboscis in Bombyliidae (Diptera, Brachycera) and implications for proboscis evolution in Brachycera. Zoomorphology. 120 (2), 79-90 (2000).

- Harder, L. D. Measurement and estimation of functional proboscis length in bumblebees (Hymenoptera: Apidae). Can J Zool. 60 (5), 1073-1079 (1982).

- Hobbs, G. A. Further studies on the food-gathering behaviour of bumble bees (Hymenoptera: Apidae). Canadian Entomol. 94 (05), 538-541 (1962).

- Krenn, H. W. Functional morphology and movements of the proboscis of Lepidoptera (Insecta). Zoomorphology. 110 (2), 105-114 (1990).

- Krenn, H. W. Feeding mechanisms of adult Lepidoptera: structure, function, and evolution of the mouthparts. Annu Rev Entomol. 55, 307-327 (2010).

- Hepburn, H. R. Proboscis extension and recoil in Lepidoptera. J Insect Physiol. 17 (4), 637-656 (1971).

- Ramírez, G., Fagundez, C., Grosso, J. P., Argibay, P., Arenas, A., Farina, W. M. Odor Experiences during Preimaginal Stages Cause Behavioral and Neural Plasticity in Adult Honeybees. Front Behav Neurosci. 10, (2016).

- Takeda, K. Classical conditioned response in the honey bee. J Insect Physiol. 6 (3), 168-179 (1961).

- Bitterman, M. E., Menzel, R., Fietz, A., Schäfer, S. Classical conditioning of proboscis extension in honeybees (Apis mellifera). J Comp Psychol. 97 (2), 107 (1983).

- Lambin, M., Armengaud, C., Raymond, S., Gauthier, M. Imidacloprid-induced facilitation of the proboscis extension reflex habituation in the honeybee. Arch Insect Biochem Physiol. 48 (3), 129-134 (2001).

- Masterman, R., Smith, B. H., Spivak, M. Brood odor discrimination abilities in hygienic honey bees (Apis mellifera L.) using proboscis extension reflex conditioning. J Insect Behav. 13 (1), 87-101 (2000).

- Rix, R. R., Christopher Cutler, G. Acute Exposure to Worst-Case Concentrations of Amitraz Does Not Affect Honey Bee Learning, Short-Term Memory, or Hemolymph Octopamine Levels. J Econ Entomol. 110 (1), 127-132 (2017).

- Urlacher, E., et al. Measurements of Chlorpyrifos Levels in Forager Bees and Comparison with Levels that Disrupt Honey Bee Odor-Mediated Learning Under Laboratory Conditions. J Chem Ecol. 42 (2), 127-138 (2016).

- Charbonneau, L. R., Hillier, N. K., Rogers, R. E. L., Williams, G. R., Shutler, D. Effects of Nosema apis, N. ceranae, and coinfections on honey bee (Apis mellifera) learning and memory. Sci Rep. 6, (2016).

- Urlacher, E., Devaud, J. -. M., Mercer, A. R. C-type allatostatins mimic stress-related effects of alarm pheromone on honey bee learning and memory recall. PLOS ONE. 12 (3), e0174321 (2017).

- Eiri, D. M., Nieh, J. C. A nicotinic acetylcholine receptor agonist affects honey bee sucrose responsiveness and decreases waggle dancing. J Exp Biol. 215 (12), 2022-2029 (2012).

- Liang, C. -. H., Chuang, C. -. L., Jiang, J. -. A., Yang, E. -. C. Magnetic Sensing through the Abdomen of the Honey bee. Sci Rep. 6, (2016).

- Erber, J., Pribbenow, B., Bauer, A., Kloppenburg, P. Antennal reflexes in the honeybee: tools for studying the nervous system. Apidologie. 24, 283 (1993).

- Erber, J., Kierzek, S., Sander, E., Grandy, K. Tactile learning in the honeybee. J Comp Physiol [A]. 183 (6), 737-744 (1998).

- Erber, J., Pribbenow, B. Antennal Movements in the Honeybee: How Complex Tasks are Solved by a Simple Neuronal System. Prerational Intelligence: Adaptive Behavior and Intelligent Systems Without Symbols and Logic, Volume 1, Volume 2 Prerational Intelligence: Interdisciplinary Perspectives on the Behavior of Natural and Artificial Systems, Volume 3. , 109-121 (2000).

- McAfee, A., Collins, T. F., Madilao, L. L., Foster, L. J. Odorant cues linked to social immunity induce lateralized antenna stimulation in honey bees (Apis mellifera L). Sci Rep. 7, (2017).

- Dötterl, S., Vater, M., Rupp, T., Held, A. Ozone Differentially Affects Perception of Plant Volatiles in Western Honey Bees. J Chem Ecol. 42 (6), 486-489 (2016).

- Wang, Z., et al. Honey Bees Modulate Their Olfactory Learning in the Presence of Hornet Predators and Alarm Component. PLOS ONE. 11 (2), e0150399 (2016).

- Søvik, E., Plath, J. A., Devaud, J. -. M., Barron, A. B. Neuropharmacological Manipulation of Restrained and Free-flying Honey Bees, Apis mellifera. J Vis Exp. (117), e54695 (2016).

- Fang, Y., Du, S., Abdoola, R., Djouani, K., Richards, C. Motion Based Animal Detection in Aerial Videos. Procedia Computer Science. 92, 13-17 (2016).

- Miller, B., Lim, A. N., Heidbreder, A. F., Black, K. J. An Automated Motion Detection and Reward System for Animal Training. Cureus. 7 (12), (2015).

- Birgiolas, J., Jernigan, C. M., Smith, B. H., Crook, S. M. SwarmSight: Measuring the temporal progression of animal group activity levels from natural-scene and laboratory videos. Behav Res Methods. , (2016).

- Stern, U., Zhu, E. Y., He, R., Yang, C. -. H. Long-duration animal tracking in difficult lighting conditions. Sci Rep. 5, 10432 (2015).

- Macrì, S., Mainetti, L., Patrono, L., Pieretti, S., Secco, A., Sergi, I. A tracking system for laboratory mice to support medical researchers in behavioral analysis. Engineering in Medicine and Biology Society (EMBC), 2015 37th Annual International Conference of the IEEE. , 4946-4949 (2015).

- Crall, J. D., Gravish, N., Mountcastle, A. M., Combes, S. A. BEEtag: a low-cost, image-based tracking system for the study of animal behavior and locomotion. PLOS ONE. 10 (9), e0136487 (2015).

- York, J. M., Blevins, N. A., McNeil, L. K., Freund, G. G. Mouse short-and long-term locomotor activity analyzed by video tracking software. J Vis Exp. (76), e50252 (2013).

- Noldus, L. P., Spink, A. J., Tegelenbosch, R. A. EthoVision: a versatile video tracking system for automation of behavioral experiments. Behav Res Methods. 33 (3), 398-414 (2001).

- Egnor, S. E. R., Branson, K. Computational Analysis of Behavior. Annu Rev Neurosci. 39 (1), 217-236 (2016).

- Cholé, H., Junca, P., Sandoz, J. -. C. Appetitive but not aversive olfactory conditioning modifies antennal movements in honeybees. Learn Memory. 22 (12), 604-616 (2015).

- Shen, M., et al. Interactive tracking of insect posture. Pattern Recognit. 48 (11), 3560-3571 (2015).

- Mujagić, S., Würth, S. M., Hellbach, S., Dürr, V. Tactile conditioning and movement analysis of antennal sampling strategies in honey bees (apis mellifera l). J Vis Exp. (70), (2012).

- Shen, M., Szyszka, P., Deussen, O., Galizia, C. G., Merhof, D. Automated tracking and analysis of behavior in restrained insects. J Neurosci Methods. 239, 194-205 (2015).

- Cucchiara, R., Grana, C., Piccardi, M., Prati, A. Detecting moving objects, ghosts, and shadows in video streams. IEE Trans Pattern Anal Mach. 25 (10), 1337-1342 (2003).

- Shaw, J. R. QuickFill: An efficient flood fill algorithm. The Code Project. , (2004).

- Zhang, H., Wu, K. A vehicle detection algorithm based on three-frame differencing and background subtraction. Computational Intelligence and Design (ISCID), 2012 Fifth International Symposium on Computational Intelligence and Design. 1, 148-151 (2012).

- Elgammal, A., Harwood, D., Davis, L. Non-parametric Model for Background Subtraction. Computer Vision – ECCV 2000. , 751-767 (2000).

- Zeileis, A., Grothendieck, G. zoo: S3 infrastructure for regular and irregular time series. arXiv preprint math/0505527. , (2005).

- Smith, B. H., Burden, C. M. A Proboscis Extension Response Protocol for Investigating Behavioral Plasticity in Insects: Application to Basic, Biomedical, and Agricultural Research. J Vis Exp. (91), e51057 (2014).

- How to split a video or audio file with VLC Player. Darktips Available from: https://darktips.com/split-video-audio-file/ (2012)

- Team, R. s. . RStudio: integrated development for R. , (2015).

- Venables, W. N., Ripley, B. D. . Modern Applied Statistics with S-PLUS. , (2013).

- Smith, B. H., Menzel, R. An Analysis of Variability in the Feeding Motor Program of the Honey Bee; the Role of Learning in Releasing a Modal Action Pattern. Ethology. 82 (1), 68-81 (1989).

- Smith, B. H. An analysis of blocking in odorant mixtures: an increase but not a decrease in intensity of reinforcement produces unblocking. Behavioral neuroscience. 111 (1), 57 (1997).

- . SwarmSight Antenna Tracking CSV files Available from: https://github.com/JustasB/SwarmSight/tree/master/Examples/Appendage%20Tracking/Birgiolas%20et.%20al.%20(2015) (2017)

- Kalman, R. E. A New Approach to Linear Filtering and Prediction Problems. J Basic Eng. 82 (1), 35-45 (1960).