Control de proxy en tiempo real de señales periféricas re-parametrizadas utilizando una interfaz de bucle cercano

Summary

Presentamos protocolos y métodos de análisis para construir interfaces coa adaptativas que transmiten, parametrizan, analizan y modifican las señales del cuerpo humano y del corazón en bucle cercano. Esta configuración interfaces señales derivadas de los sistemas nerviosos periféricos y centrales de la persona con entradas sensoriales externas para ayudar a realizar un seguimiento del cambio biofísico.

Abstract

Los campos que desarrollan métodos de sustitución sensorial y aumento sensorial han tenido como objetivo controlar objetivos externos utilizando señales de los sistemas nerviosos centrales (SNC). Sin embargo, son menos frecuentes los protocolos que actualizan las señales externas generadas por cuerpos interactivos en movimiento. Hay una escasez de métodos que combinan los biorritmos cuerpo-corazón-cerebro de un agente en movimiento para dirigir los de otro agente en movimiento durante el intercambio dyadic. Parte del desafío para lograr tal hazaña ha sido la complejidad de la configuración utilizando bio-señales multimodales con diferentes unidades físicas, escalas de tiempo dispares y frecuencias de muestreo variables.

En los últimos años, la llegada de biosensores portátiles que no pueden aprovechar múltiples señales en tándem, ha abierto la posibilidad de re-parametrizar y actualizar las señales periféricas de los diásenos interactuantes, además de mejorar las interfaces cerebro y/o cuerpo-máquina. Aquí presentamos una interfaz coa adaptativa que actualiza la salida somática-motora efervestiva (incluyendo cinemática y frecuencia cardíaca) utilizando biosensores; parametriza las bio-señales estocásticas, sonifica esta salida y la vuelve a introducir en forma re-parametrizada como entrada reaferente visuo/audio-cinética. Ilustramos los métodos utilizando dos tipos de interacciones, una involucrando a dos seres humanos y otra que involucra a un humano y su avatar interactuando casi en tiempo real. Discutimos los nuevos métodos en el contexto de posibles nuevas formas de medir las influencias de la entrada externa en el control interno somático-sensorial-motor.

Introduction

El controlador de bucle cerrado natural

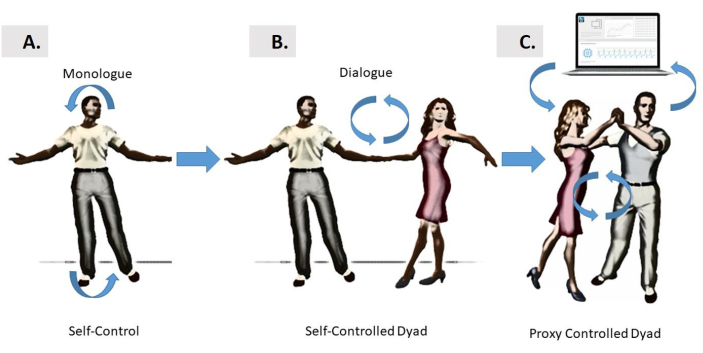

La información sensorial-motora fluye continuamente entre el cerebro y el cuerpo para producir comportamientos bien organizados y coordinados. Tales comportamientos se pueden estudiar mientras se centran únicamente en las acciones de la persona, como en un estilo de monólogo(Figura 1A),o durante complejas acciones dinámicas compartidas entre dos agentes en un dyad, como en un estilo de diálogo(Figura 1B). Sin embargo, una tercera opción es evaluar interacciones tan complejas a través de un controlador proxy, en el contexto de una interfaz de bucle cerrado humano-ordenador (Figura 1C). Tal interfaz puede rastrear las fluctuaciones de los movimientos momento a momento aportadas por cada agente en el dyad, y por el tipo de cohesividad que se autoexamina de sus interacciones sincrónicas, ayudando a dirigir los ritmos del dyad de maneras deseables.

Figura 1: Diferentes formas de control. (A) Las interfaces autocontroladas por cerebro se basan en las relaciones de bucle estrecho entre el cerebro de la persona y el propio cuerpo de la persona, que pueden autorregularse e auto-interactuar en estilo “monólogo”. Este modo intenta el control de los movimientos autogenerados, o también puede tener como objetivo controlar dispositivos externos. B) Se introduce el control de estilo “Diálogo” para dos bailarines que interactúan entre sí y a través del entrenamiento físico y la toma de turnos para alcanzar el control sobre los movimientos del otro. (C) El control de diálogo “tercero” de la diría se introduce como mediado por una interfaz informática que aprovecha en tándem las bio-señales de ambos bailarines, lo parametriza y lo alimenta de nuevo a los bailarines en forma re-parametrizada utilizando audio y/o visión como formas de orientación sensorial. La re-parametrización en los ejemplos aquí presentados se logró utilizando retroalimentación visual o de audio, mejorada por la salida del motor cinético en tiempo real de uno de los bailarines para influir en el otro; o de ambos bailarines, turnándose en algún patrón alterno. Haga clic aquí para ver una versión más grande de esta figura.

El objetivo general de este método es mostrar que es posible aprovechar, parametrizar y re-parametrizar las fluctuaciones momento por momento en las actividades biorritálmicas de los cuerpos en movimiento, ya que dos agentes participan en el intercambio dyadic que puede involucrar a dos seres humanos, o un humano y su avatar auto-en movimiento.

Las investigaciones sobre cómo el cerebro puede controlar las acciones y predecir sus consecuencias sensoriales han generado muchas líneas de investigaciones teóricas en los últimos1,2,3 y producido varios modelos de control neuromotor4,5,6,7,8. Una línea de investigación en este campo multidisciplinario ha implicado el desarrollo de la máquina del cerebro de bucle cercano o interfaces cerebro-computadora. Este tipo de configuraciones ofrecen formas de aprovechar y adaptar las señales CNS para controlar un dispositivo externo, como un brazo robótico9,10,11,un exoesqueleto12,un cursor en una pantalla de ordenador13 (entre otros). Todos estos dispositivos externos comparten la propiedad de que no tienen inteligencia propia. En cambio, el cerebro que intenta controlarlos tiene, y parte del problema que enfrenta el cerebro es aprender a predecir las consecuencias de los movimientos que genera en estos dispositivos (por ejemplo, los movimientos del cursor, los movimientos del brazo robótico, etc.) mientras genera otros movimientos de apoyo que contribuyen a la retroalimentación motora sensorial general en forma de reaferencia cinética. A menudo, el objetivo general de estas interfaces ha sido ayudar a la persona detrás de ese cerebro a evitar una lesión o trastorno, para recuperar la transformación de sus pensamientos intencionales en actos físicos volicionalmente controlados del dispositivo externo. Sin embargo, menos común ha sido el desarrollo de interfaces que intentan dirigir los movimientos de los cuerpos en movimiento.

Gran parte de la investigación original sobre las interfaces cerebro-máquina se centra en el control del sistema nervioso central (SNC) sobre partes del cuerpo que pueden lograr acciones dirigidas por objetivos9,14,15,16,17. Hay, sin embargo, otras situaciones por las que el uso de las señales derivadas de las actividades de los sistemas nerviosos periféricos (PNS), incluidos los de los sistemas nerviosos autónomos (ANS), es lo suficientemente informativo como para influir y dirigir las señales de los agentes externos, incluyendo a otro humano o avatar, o incluso la interacción de los seres humanos (como en la Figura 1C). A diferencia de un brazo robótico o cursor, el otro agente en este caso, tiene inteligencia impulsada por un cerebro (en el caso del avatar que ha sido dotado con los movimientos de la persona, o de otro agente, en el caso de un diálogo humano interactuando).

Una configuración que crea un entorno de una interfaz de bucle cerrado coa adaptativo con intercambio dyadic puede ser útil para intervenir en trastornos de los sistemas nerviosos por los cuales el cerebro no puede controlar volicionalmente su propio cuerpo en movimiento a voluntad, a pesar de no haber cortado físicamente el puente entre el SNC y el PNS. Este puede ser el caso debido a señales periféricas ruidosas por las cuales los bucles de retroalimentación para ayudar al cerebro monitorear continuamente y ajustar sus propios biorritmos autogenerados pueden haber sido interrumpidos. Este escenario surge en pacientes con enfermedad de Parkinson18,19,o en participantes con trastornos del espectro autista con exceso de ruido en su producción motora. De hecho, en ambos casos, hemos cuantificado altos niveles de relación ruido-señal en las señales cinéticas que regresan derivadas de la velocidad de sus movimientos previstos20,21,22 y del corazón23. En tales casos, tratar de dominar el control cerebral de las señales externas, mientras que también tratando de controlar el cuerpo en movimiento, puede resultar en una señal auto reactiva de la corriente de información re-participante (reaferente) que el cerebro recibe de la corriente motora continua (efervescencia) en la periferia. De hecho, las fluctuaciones momento a momento presentes en dicha corriente motora efervestiva autogenerada contienen información importante útil para ayudar a la predicción de las consecuencias sensoriales de las acciones intencionales24. Cuando esta retroalimentación se corrompe por el ruido, se hace difícil actualizar previsiblemente las señales de control y puentear los planes intencionales con actos físicos.

Si extendiéramos dicho bucle de retroalimentación a otro agente y controlemos las interacciones de la persona y el agente a través de un tercero(Figura 1C),es posible que tengamos la oportunidad de dirigir las actuaciones del otro casi en tiempo real. Esto nos proporcionaría la prueba de concepto de que tendríamos que extender la noción de interfaces coa adaptativas cerebro-cuerpo o cerebro-máquina para tratar trastornos de los sistemas nerviosos que resultan en una mala realización de la voluntad física de la intención mental.

Las acciones con propósito tienen consecuencias, que se caracterizan precisamente por firmas estocásticas motoras que dependen del contexto y permiten la inferencia de niveles de intención mental con alta certeza25,26. Por lo tanto, una ventaja de un nuevo método que aprovecha el intercambio dyadic sobre enfoques previos centrados en la persona a la máquina del cerebro o interfaces de computadora cerebral, es que podemos aumentar las señales de control para incluir los biorritmos corporales y cardíacos que transpiran en gran parte por debajo de la conciencia de la persona, bajo diferentes niveles de intención. De esta manera, amortiguamos la interferencia reactiva que el control consciente tiende a evocar en el proceso de adaptación del control cerebro-cursor17. Podemos añadir más certeza al proceso predictivo parametrizando las diversas señales a las que podemos acceder. En esa línea, existe un trabajo previo utilizando señales cerebrales y corporales en tándem27,28,29; pero el trabajo que involucra interacciones dyadic capturadas por señales cuerpo-cuerpo sigue siendo escaso. Además, la literatura extant aún no ha delineado la distinción entre segmentos deliberados de la acción realizada bajo plena conciencia y movimientos transitorios que se producen espontáneamente como consecuencia de los deliberados30,31. Aquí hacemos esa distinción en el contexto del intercambio dyadic, y ofrecemos nuevas formas de estudiar esta dicotomía32,al tiempo que proporcionamos ejemplos de movimientos coreografiados (deliberados) frente a movimientos improvisados (espontáneos) en el espacio de la danza.

Debido a los retrasos en la transducción y transmisión en los procesos de integración y transformación sensorial-motor33,es necesario tener tal código predictivo en su lugar, para aprender a anticipar la próxima entrada sensorial con alta certeza. Con ese fin, es importante poder caracterizar la evolución de la relación ruido-señal derivada de las señales en la corriente de reaferencia cinética que se actualiza continuamente. A continuación, necesitamos protocolos para medir sistemáticamente el cambio en la variabilidad del motor. La variabilidad está inherentemente presente en las fluctuaciones momento a momento de la corriente de motor efervescencia saliente34. Dado que estas señales no son estacionarias y sensibles a las variaciones contextuales35,36,es posible parametrizar los cambios que se producen con alteraciones del contexto de las tareas. Para minimizar la interferencia de las señales reactivas que surgen del control consciente del SNC, y para evocar cambios cuantificables en la efervescencia del motor PNS, presentamos aquí una interfaz proxy de bucle cercano que altera indirectamente la retroalimentación sensorial, mediante el reclutamiento de la señal periférica que está cambiando en gran medida por debajo de la autoconciencia de la persona. A continuación, mostramos maneras de medir sistemáticamente el cambio que se produce en las manipulaciones sensoriales, utilizando análisis estocásticos que se pueden visualizar para visualizar el proceso que la interfaz de bucle cercano proxy evoca indirectamente en ambos agentes.

Presentación de un controlador de bucle cerrado proxy

La variabilidad sensorial-motora presente en las señales periféricas constituye una rica fuente de información para guiar el rendimiento de los sistemas nerviosos mientras que el aprendizaje, la adaptación y la generalización tienen lugar en diferentes contextos37. Estas señales surgen en parte como un subproducto del CNS tratando de controlar volicionalmente las acciones, pero no son el objetivo directo del controlador. A medida que la persona interactúa naturalmente con los demás, las señales periféricas se pueden aprovechar, estandarizar y volver a parametrizar; lo que significa que sus variaciones se pueden parametrizar y cambiar sistemáticamente, ya que se altera la corriente motora efervesica que vuelve a entrar continuamente en el sistema como reaferencia cinética. En tales entornos, podemos visualizar los cambios estocásticos, capturando con alta precisión una señal rica que de otra manera se pierde a los tipos de gran promedio que realizan las técnicas más tradicionales.

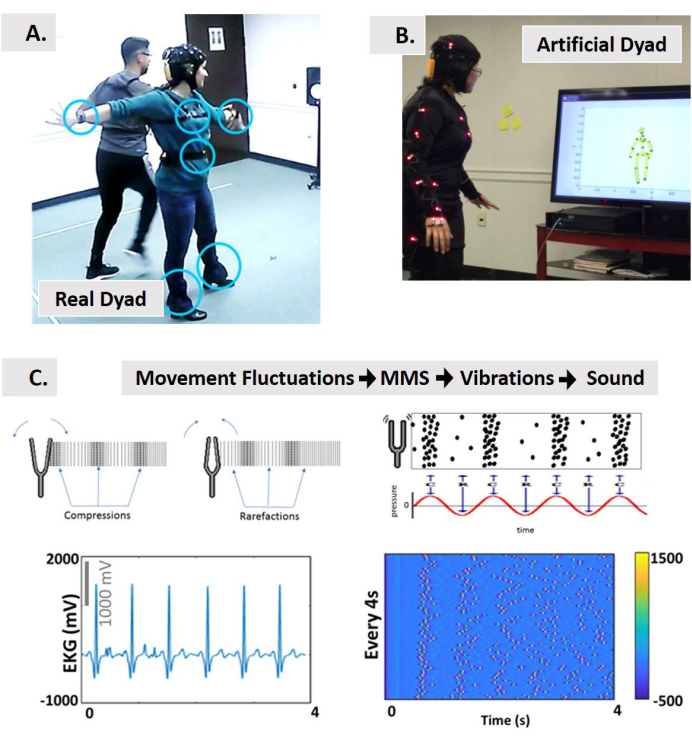

Para lograr la caracterización del cambio bajo la nueva plataforma estadística, aquí introducimos protocolos, tipos de datos estandarizados y análisis que permiten la integración de entrada sensorial externa (auditiva y visual) con señales motoras generadas internamente, mientras que la persona interactúa naturalmente con otra persona, o con una versión avatar de la persona. En este sentido, debido a que nuestro objetivo es controlar las señales periféricas (en lugar de modificar las señales CNS para controlar directamente el dispositivo externo o los medios), acuñamos esto como una interfaz de bucle cercano proxy (Figura 2). Nuestro objetivo es caracterizar los cambios en las señales estocásticas del PNS, ya que afectan a los del SNC.

Figura 2: Control proxy de una interacción dyadic utilizando interfaz multimodólica de bucle cerrado. (A) Control indirecto de dos bailarines (salsa danzante) a través de una interfaz coa adaptativa de computadora frente a (B) un dyad artificial interactivo persona-avatar controlado mediante el aprovechamiento de las señales de los sistemas nerviosos periféricos y volver a parametrizarlo como sonidos y / o como entrada visual. (C) El concepto de sonificación utilizando un nuevo tipo de datos estandarizados (los picos de micro-movimiento, MMS) derivado de las fluctuaciones momento a momento en la amplitud/sincronización de las señales biorritómicas convertidas en vibraciones y luego al sonido. De Physics, tomamos prestadas las nociones de compresiones y rarefacciones producidas por una horquilla de ajuste que produce onda sonora como vibraciones medibles. Esquemas de ondas sonoras representadas como presión modulada con el tiempo en paralelo a las concentraciones de pico para la sonificación. Ejemplo de una señal física para someterse a la tubería propuesta desde MMS hasta vibraciones y sonificación. Utilizamos la señal de frecuencia cardíaca como entrada a la interfaz. Esto toma fluctuaciones en la amplitud de la señal alineadas con el inicio de movimiento cada 4 segundos de movimiento y construye trenes MMS que representan las vibraciones. Los trenes spike del MMS están estandarizados a partir de [0,1]. El color de los picos según la barra de color representa la intensidad de la señal. Luego sonificamos estas vibraciones usando Max. Esta señal sonificada se puede utilizar para reproducir en A, o para alterar en B las interacciones con el avatar. Además, en B es posible incrustar el sonido en el entorno y utilizar la posición del cuerpo para reproducir el sonido en una región de interés (RoI), o para modular las características de audio como una función de distancia a la RoI, velocidad o aceleración de una parte del cuerpo anclada a otra parte del cuerpo, al pasar por el RoI. Haga clic aquí para ver una versión más grande de esta figura.

Las señales PNS se pueden aprovechar de forma no invasiva con tecnologías de detección ponibles que co-registran flujos efervesivos multimodales de diferentes capas funcionales de los sistemas nerviosos, que van desde las autonómicas hasta lasvoluntarias 32. A continuación, podemos medir casi en tiempo real los cambios en tales flujos y seleccionar aquellos cuyos cambios mejoran la relación señal-ruido. Esta señal motora efervestiva se puede aumentar con otras formas de orientación sensorial (por ejemplo, auditiva, visual, etc.) Debido a que las señales PNS chivo expiatorio plena conciencia, son más fáciles de manipular sin mucha resistencia 38. Como tal, los usamos para ayudar a dirigir el rendimiento de la persona de maneras que pueden ser menos estresantes para el sistema humano.

Construcción de la interfaz

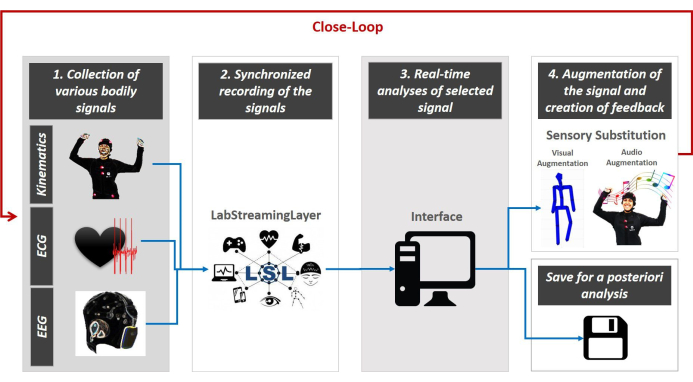

Presentamos el diseño del control proxy mediado por una interfaz multimodal co-adaptativa de bucle cerrado. Esta interfaz dirige los comentarios multisensoriales en tiempo real. La Figura 3 muestra el diseño general.

La interfaz de bucle cercano se caracteriza por 5 pasos principales. El primer paso es la recopilación de datos multimodal de múltiples instrumentos portátiles. El segundo paso es la sincronización de las secuencias multimodales a través de la plataforma de LabStreamingLayer (LSL, https://github.com/sccn/labstreaminglayer) desarrollada por el grupo MoBI 39. El tercer paso es la transmisión de la estructura de datos LSL a una interfaz de Python, MATLAB u otro lenguaje de programación para integrar las señales y parametrizar empíricamente las características fisiológicas (relevantes para nuestra configuración experimental) en tiempo real. El 4º paso es re-parametrizar las características seleccionadas extraídas de la corriente continua de la señal corporal estudiada y aumentarla utilizando una modalidad sensorial de elección (por ejemplo, visual, auditiva, cinética, etc.) para reproducirla en forma de sonidos o visuales, para aumentar, sustituir o mejorar la modalidad sensorial que es problemática en el sistema nervioso de la persona. Por último, el 5º paso es reevaluar las firmas estocásticas de las señales generadas por el sistema en tiempo real, para seleccionar qué modalidad sensorial lleva los cambios estocásticos de las fluctuaciones corporales a un régimen de alta certeza (minimización del ruido) en la predicción de las consecuencias sensoriales de la acción inminente. Este bucle se reproduce continuamente a lo largo de la duración del experimento con el foco en la señal seleccionada, mientras almacena el rendimiento completo para análisis posteriores (como se muestra en los esquemas de la Figura 3 y ver40,41,42,43,44,45,46,47 para un ejemplo de análisis a posteriori).

Figura 3: La arquitectura del concepto de interfaz de bucle estrecho de varios modales impulsados por periféricos. Se recopilan varias señales corporales -datos cinemáticos, actividad cardíaca y cerebral (paso 1). LSL se utiliza para co-registrar y transmitir sincrónicamente los datos procedentes de varios equipos a la interfaz (paso 2). El código Python/MATLAB/C# se utiliza para parametrizar continuamente las fluctuaciones en las señales utilizando un tipo de datos estandarizado y una escala común que permite seleccionar la fuente de orientación sensorial más adecuada para amortiguar la incertidumbre del sistema (paso 3). Esta mejora en tiempo real de la transmisión de señal a través de los canales seleccionados permite entonces la re-parametrización de la señal sensorial re-participante para integrarse en la corriente continua del motor y mejorar la secuencia de entrada perdida o dañada (paso de sustitución sensorial 4). La reevaluación continua cierra el bucle (paso 5) y guardamos todos los datos para análisis futuros adicionales. Haga clic aquí para ver una versión más grande de esta figura.

En las secciones siguientes se presenta el protocolo genérico de cómo construir una interfaz de bucle cerrado (como se describe en la Figura 3)y describir los resultados representativos de dos interfaces experimentales (elaboradamente presentadas en Material Suplementario) que implican interacción dyadica física entre dos bailarines (sistema de bucle estrecho real) y la interacción dyadica virtual entre una persona y un avatar (sistema de bucle cerrado artificial).

Protocol

Representative Results

Discussion

Este documento introduce el concepto de control de proxy a través de interfaces co-adaptables, interactivas y multimodales de bucle cerrado que aprovechan, parametrizan y reparametrizan la señal periférica de la persona en el contexto del intercambio dyadic. Nuestro objetivo era caracterizar los cambios estocásticos en las fluctuaciones de los biorritmos de la persona y parametrizar el cambio. Además, nuestro objetivo era dirigir sistemáticamente las firmas estocásticas de sus biorritmos hacia niveles específicos de regímenes de ruido a señal en tiempo casi real.

Presentamos un protocolo genérico para la construcción de una interfaz de bucle cerrado que satisfizo 5 elementos principales: 1) la recopilación de múltiples datos corporales procedentes del CNS, PNS y ANS utilizando varios instrumentos y tecnologías; 2) la grabación sincronizada y la transmisión de los datos; 3) el análisis en tiempo real de las señales seleccionadas; 4) la creación de aumento sensorial (audio, visual, etc.) utilizando características fisiológicas extraídas para las señales corporales; y 5) el seguimiento continuo del sistema humano y el aumento sensorial paralelo cierra el bucle de la interacción entre el humano y el sistema.

El protocolo genérico se aplicó en dos interfaces de ejemplo. El primero investiga el intercambio dyadic entre dos agentes humanos y el segundo entre un humano y un agente avatar. Los dos tipos de dyads se utilizaron para proporcionar pruebas de concepto de que la señal periférica se puede cambiar sistemáticamente en tiempo real y que estos cambios estocásticos se pueden rastrear con precisión. Un dyad estaba compuesto por dos participantes que interactuaban físicamente, mientras que el otro involucraba a un participante interactuando con un agente virtual en forma de un avatar renderizado en 3D dotado de los movimientos de la persona y con variantes alteradas de estos movimientos en tiempo real. Tales alteraciones fueron evocadas por manipulaciones interactivas impulsadas por entradas sensoriales auditivas y/o visuales en un entorno de sensaciones aumentadas. Tanto en el dyad real como en el dyad artificial, demostramos la viabilidad de cambiar remotamente las señales periféricas, incluidos los biorritmos corporales y las señales autonómicas del latido del corazón.

Presentamos nuevos protocolos experimentales para sondear tales cambios en la variabilidad motora efervescencia, ya que las corrientes de señal cinética están siendo manipuladas y re-parametrizadas casi en tiempo real. Esta información de re-participante (reaferencia cinética48)resultó valiosa para cambiar el rendimiento de los sistemas en tiempo real. Llevan información sobre las consecuencias sensoriales de la acción, que podemos rastrear con precisión utilizando los métodos que presentamos aquí.

También mostramos tipos de datos y métodos estadísticos aptos para estandarizar nuestros análisis. Proporcionamos múltiples herramientas de visualización para demostrar los cambios en tiempo real en las actividades fisiológicas que evolucionan naturalmente en diferentes contextos, con inferencia estadística guiada empíricamente que se presta a la interpretación de las señales de los sistemas nerviosos autogenerados y autocontrolados. Es importante destacar que los cambios que fueron evocados por el controlador proxy fueron suaves y sin embargo cuantificables, prestando así apoyo a la noción de que la actividad periférica es útil de más de una manera. Si bien podemos implementar estos métodos utilizando sensores portátiles inalámbricos disponibles comercialmente, podemos inducir sistemáticamente cambios en el rendimiento que son capturables en los ritmos biofísicos sin enfatizar el sistema. Es importante traducir nuestros métodos a la arena clínica y utilizarlos como un banco de pruebas para desarrollar nuevos modelos de intervención (por ejemplo, como cuando se utiliza la realidad aumentada en el autismo 49). En estos modelos, podremos rastrear y cuantificar las consecuencias sensoriales de las acciones naturalistas de la persona, ya que las entradas sensoriales se manipulan con precisión, y la salida se parametriza y se vuelve a parametrizar casi en tiempo real.

Ofrecemos este protocolo como modelo general para utilizar diversas actividades biorritómicas autogeneradas por los sistemas nerviosos humanos y aprovechadas no invasivamente con wearables inalámbricos. Aunque utilizamos un conjunto de biosensores para registrar EEG, ECG y cinemática en este documento, los métodos de grabación, sincronización y análisis de las señales son generales. Por lo tanto, la interfaz puede incorporar otras tecnologías. Además, los protocolos pueden modificarse para incluir otras acciones y contextos naturalistas que se extienden al ámbito médico. Debido a que hemos dirigido comportamientos naturales, la configuración que hemos desarrollado se puede utilizar en entornos lúdicos (por ejemplo, involucrando a niños y padres.)

Varios trastornos de los sistemas nerviosos podrían beneficiarse de tales enfoques lúdicos para el problema de control. En ambos tipos de interacciones dyadic que mostramos aquí, los participantes podrían aspirar a controlar conscientemente la música, mientras que el controlador proxy utiliza la salida periférica para manipular inconscientemente y cambiar sistemáticamente sus firmas. Porque los científicos han pasado años mapeando empíricamente el plano del parámetro Gamma y el correspondiente espacio de momentos Gamma en diferentes grupos de edad (neonatos a los 78 años de edad)19,50,51,52,53 y condiciones (autismo, Enfermedad de Parkinson, accidente cerebrovascular, estado de coma y desafferentación), para diferentes niveles de control (voluntario, automático, espontáneo, involuntario y autonómico)25,47,54,tienen criterios empíricamente medidos que denotan dónde en los espacios gamma las firmas estocásticas deben ser para un buen control predictivo. Investigaciones anteriores también han demostrado que sabemos dónde están los parámetros en presencia de ruido aleatorio espontáneo procedente de los ritmos autogenerados de los sistemas nerviosos humanos7,19,55,56. Dentro de un esquema de optimización que minimiza el ruido biorritálmico del motor, podemos apuntar así a conducir las señales de tal manera que alcance las áreas específicas de los espacios Gamma donde la forma y las firmas de dispersión de la familia de ARCHIVOS PDF de cada persona es propicia de alta relación señal-ruido y valores predictivos. En este sentido, no perdemos datos brutos y más bien los utilizamos eficazmente para conducir el sistema hacia niveles deseables de ruido dentro de una situación dada.

Las interacciones dyadicas son omnipresentes en entornos clínicos o de entrenamiento. Pueden ocurrir entre el entrenador y el aprendiz; el médico y el paciente; el terapeuta clínico y el paciente; y también pueden ocurrir en entornos de investigación que involucran la ciencia traslacional e involucran al investigador y al participante. Una de las ventajas de los protocolos actuales es que si bien están diseñados para dyads, también están personalizados. Como tal, es posible adaptar las interacciones coa adaptativas a las mejores capacidades y predisposiciones de la persona, de acuerdo con sus rangos de movimiento, sus rangos de tiempos de procesamiento sensorial y teniendo en cuenta los rangos en la amplitud de las señales a través de la jerarquía funcional de los sistemas nerviosos de la persona. A medida que la trayectoria estocástica emerge y evoluciona con el tiempo, también es posible determinar las tasas de probabilidad de las firmas y utilizar esa serie temporal para pronosticar varios eventos inminentes junto con posibles consecuencias sensoriales.

Por último, las interfaces de bucle cerrado podrían incluso utilizarse en el mundo del arte. Podrían ofrecer a los artistas escénicos nuevas vías para generar formas computacionales de danzas modernas, bailes tecnológicos y nuevas formas de visualización y sonificación de la expresión corporal. En tales contextos, el cuerpo del bailarín puede convertirse en un instrumento impulsado sensorialmente para explorar de manera flexible diferentes modalidades sensoriales a través de la sonificación y visualización de las actividades biorritrómicas autogeneradas, como lo demuestran los trabajos previos en esta área40,41,43,46. Tal actuación podría aumentar el papel de un bailarín en el escenario y dejar que el público experimente señales corporales sutiles más allá del movimiento visible.

Varios aspectos de esta tecnología requieren un mayor desarrollo y pruebas para optimizar su uso en entornos en tiempo real. La transmisión sincrónica exige potencia de CPU/GPU de alta velocidad y capacidad de memoria para explotar realmente la noción de ganar tiempo y ser un paso adelante a la hora de predecir las consecuencias sensoriales de los comandos motores en curso. Las velocidades de muestreo del equipo deben ser comparables para poder alinear verdaderamente las señales, realizar una fusión sensorial adecuada y explorar la transmisión de información a través de los diferentes canales del sistema nervioso. Estas son algunas de las limitaciones presentes en esta nueva interfaz.

Con todo, este trabajo ofrece un nuevo concepto para mejorar el control de nuestro sistema corporal, al tiempo que emplea medios subliminales que, no obstante, permiten mediciones sistemáticas estandarizadas de resultados del cambio estocástico.

Disclosures

The authors have nothing to disclose.

Acknowledgements

Agradecemos a los estudiantes que ofrecieron su tiempo para ayudar a realizar esta investigación; Kan Anant y PhaseSpace Inc. para proporcionarnos imágenes y videos necesarios para describir la configuración; y Neuroelectrónica por permitirnos utilizar material del canal www.youtube.com/c/neuroelectrics/ y sus manuales. Por último, agradecemos al Profesor Thomas Papathomas del Rutgers Center for Cognitive Science por su apoyo profesional durante las etapas de presentación de este manuscrito, nancy Lurie Marks Family Foundation Career Development Award a EBT y el Gerondelis Foundation Award a VK.

Contribuciones

Conceptualización, VK y EBT; metodología, EBT; software, VK, EBT, SK.; validación, VK y SK; análisis formal, VK; investigación, VK, EBT, SK; recursos, EBT; curación de datos, VK; escritura — preparación original del borrador, EBT; escritura: revisión y edición, VK, SK.; visualización, VK y EBT.; supervisión, EBT.; administración del proyecto, EBT.; adquisición de fondos, EBT Todos los autores han leído y acordado la versión publicada del manuscrito.

Materials

| Enobio 32 | Enobio | Hardware for EEG data collection | |

| Enobio ECG Extention | Enobio | Hardware for ECG data collection | |

| LabStreamingLayer (LSL) | Synchronization and streaming of data | ||

| Matlab | Mathwork | Analysis and processing of data | |

| Max | Cycling'74 | Sonification of bodily information | |

| NIC.2 | Enobio | Software for EEG and ECG data collection | |

| PhaseSpace Impulse | PhaseSpace | Hardware for collection of the kinematic data (position, speed, acceleration) | |

| Python3 | Python | Analysis and processing of data | |

| Recap | PhaseSpace | Software for collection of the kinematic data (position, speed, acceleration) |

References

- Kawato, M., Wolpert, D. Internal models for motor control. Novartis Foundation Symposium. 218, 291-304 (1998).

- Wolpert, D. M., Kawato, M. Multiple paired forward and inverse models for motor control. Neural Networks. 11 (7-8), 1317-1329 (1998).

- Wolpert, D. M., Miall, R. C., Kawato, M. Internal models in the cerebellum. Trends in Cognitive Sciences. 2 (9), 338-347 (1998).

- Todorov, E., Jordan, M. I. Optimal feedback control as a theory of motor coordination. Nature Neuroscience. 5 (11), 1226-1235 (2002).

- Todorov, E. Optimality principles in sensorimotor control. Nature Neuroscience. 7 (9), 907-915 (2004).

- Torres, E. B. . Theoretical Framework for the Study of Sensori-motor Integration. , (2001).

- Harris, C. M., Wolpert, D. M. Signal-dependent noise determines motor planning. Nature. 394 (20), 780-784 (1998).

- Torres, E. B., Zipser, D. Reaching to Grasp with a Multi-jointed Arm (I): A Computational Model. Journal of Neurophysiology. 88, 1-13 (2002).

- Carmena, J. M., et al. Learning to control a brain-machine interface for reaching and grasping by primates. PLoS Biology. 1 (2), 42 (2003).

- Hwang, E. J., Andersen, R. A. Cognitively driven brain machine control using neural signals in the parietal reach region. 2010 Annual International Conference of the IEEE Engineering in Medicine and Biology. 2010, 3329-3332 (2010).

- Andersen, R. A., Kellis, S., Klaes, C., Aflalo, T. Toward more versatile and intuitive cortical brain-machine interfaces. Current Biology. 24 (18), 885-897 (2014).

- Contreras-Vidal, J. L., et al. Powered exoskeletons for bipedal locomotion after spinal cord injury. Journal of Neural Engineering. 13 (3), 031001 (2016).

- Choi, K., Torres, E. B. Intentional signal in prefrontal cortex generalizes across different sensory modalities. Journal of Neurophysiology. 112 (1), 61-80 (2014).

- Hwang, E. J., Andersen, R. A. Cognitively driven brain machine control using neural signals in the parietal reach region. 2010 Annual International Conference of the IEEE Engineering in Medicine and Biology. 2010, 3329-3332 (2010).

- Andersen, R. A., Kellis, S., Klaes, C., Aflalo, T. Toward more versatile and intuitive cortical brain-machine interfaces. Current Biology. 24 (18), 885-897 (2014).

- Contreras-Vidal, J. L., et al. Powered exoskeletons for bipedal locomotion after spinal cord injury. Journal of Neural Engineering. 13 (3), 031001 (2016).

- Choi, K., Torres, E. B. Intentional signal in prefrontal cortex generalizes across different sensory modalities. Journal of Neurophysiology. 112 (1), 61-80 (2014).

- Yanovich, P., Isenhower, R. W., Sage, J., Torres, E. B. Spatial-orientation priming impedes rather than facilitates the spontaneous control of hand-retraction speeds in patients with Parkinson’s disease. PLoS One. 8 (7), 66757 (2013).

- Torres, E. B., Cole, J., Poizner, H. Motor output variability, deafferentation, and putative deficits in kinesthetic reafference in Parkinson’s disease. Frontiers in Human Neuroscience. 8, 823 (2014).

- Torres, E. B., et al. Toward Precision Psychiatry: Statistical Platform for the Personalized Characterization of Natural Behaviors. Frontiers in Human Neuroscience. 7, 8 (2016).

- Torres, E. B., Cole, J., Poizner, H. Motor output variability, deafferentation, and putative deficits in kinesthetic reafference in Parkinson’s disease. Frontiers in Human Neuroscience. 8, 823 (2014).

- Torres, E. B., et al. Autism: the micro-movement perspective. Frontiers in Integrative Neuroscience. 7, 32 (2013).

- Ryu, J., Vero, J., Torres, E. B. . MOCO ’17: Proceedings of the 4th International Conference on Movement Computing. , 1-8 (2017).

- Brincker, M., Torres, E. B. Noise from the periphery in autism. Frontiers in Integrative Neuroscience. 7, 34 (2013).

- Torres, E. B. Two classes of movements in motor control. Experimental Brain Research. 215 (3-4), 269-283 (2011).

- Torres, E. B. Signatures of movement variability anticipate hand speed according to levels of intent. Behavioral and Brain Functions. 9, 10 (2013).

- Gramann, K., et al. Cognition in action: imaging brain/body dynamics in mobile humans. Reviews in the Neurosciences. 22 (6), 593-608 (2011).

- Makeig, S., Gramann, K., Jung, T. P., Sejnowski, T. J., Poizner, H. Linking brain, mind and behavior. International Journal of Psychophysiology. 73 (2), 95-100 (2009).

- Ojeda, A., Bigdely-Shamlo, N., Makeig, S. MoBILAB: an open source toolbox for analysis and visualization of mobile brain/body imaging data. Frontiers in Human Neuroscience. 8, 121 (2014).

- Casadio, M., et al. . IEEE International Conference on Rehabilitation Robotics. , (2019).

- Pierella, C., Sciacchitano, A., Farshchiansadegh, A., Casadio, M., Mussaivaldi, S. A. . 7th IEEE International Conference on Biomedical Robotics and Biomechatronics. , (2018).

- Torres, E. B. Two classes of movements in motor control. Experimental Brain Research. 215 (3-4), 269-283 (2011).

- Purves, D. . Neuroscience. Sixth edition. , (2018).

- Torres, E. B. Signatures of movement variability anticipate hand speed according to levels of intent. Behavioral and Brain Functions. 9, 10 (2013).

- Torres, E. B. The rates of change of the stochastic trajectories of acceleration variability are a good predictor of normal aging and of the stage of Parkinson’s disease. Frontiers in Integrative Neuroscience. 7, 50 (2013).

- Torres, E. B., Vero, J., Rai, R. Statistical Platform for Individualized Behavioral Analyses Using Biophysical Micro-Movement Spikes. Sensors (Basel). 18 (4), (2018).

- Torres, E. B. . Progress in Motor Control. , 229-254 (2016).

- Torres, E. B., Yanovich, P., Metaxas, D. N. Give spontaneity and self-discovery a chance in ASD: spontaneous peripheral limb variability as a proxy to evoke centrally driven intentional acts. Frontiers in Integrative Neuroscience. 7, 46 (2013).

- Gramann, K., Jung, T. P., Ferris, D. P., Lin, C. T., Makeig, S. Toward a new cognitive neuroscience: modeling natural brain dynamics. Frontiers in Human Neuroscience. 8, 444 (2014).

- Kalampratsidou, V., Torres, E. B. Bodily Signals Entrainment in the Presence of Music. Proceedings of the 6th International Conference on Movement and Computing. , (2019).

- Kalampratsidou, V., Torres, E. B. Sonification of heart rate variability can entrain bodies in motion. Proceedings of the 7th International Conference on Movement and Computing. , (2020).

- Kalampratsidou, V. . Co-adaptive multimodal interface guided by real-time multisensory stochastic feedback. , (2018).

- Kalampratsidou, V., Kemper, S., Torres, E. B. Real time streaming and closed loop co-adaptive interface to steer multi-layered nervous systems performance. 48th Annual Meeting of Society for Neuroscience. , (2018).

- Kalampratsidou, V., Torres, E. B. Body-brain-avatar interface: a tool to study sensory-motor integration and neuroplasticity. Fourth International Symposium on Movement and Computing, MOCO. 17, (2017).

- Kalampratsidou, V., Torres, E. B. Peripheral Network Connectivity Analyses for the Real-Time Tracking of Coupled Bodies in Motion. Sensors (Basel). 18 (9), (2018).

- Kalampratsidou, V., Zavorskas, M., Albano, J., Kemper, S., Torres, E. B. Dance from the heart: A dance performance of sounds led by the dancer’s heart. Sixth International Symposium on Movement and Computing. , (2019).

- Kalampratsidou, V., Torres, E. B. Outcome measures of deliberate and spontaneous motions. Proceedings of the 3rd International Symposium on Movement and Computing. , 9 (2016).

- Von Holst, E., Mittelstaedt, H., Dodwell, P. C. . Perceptual Processing: Stimulus equivalence and pattern recognition. , 41-72 (1950).

- Torres, E. B., Yanovich, P., Metaxas, D. N. Give spontaneity and self-discovery a chance in ASD: spontaneous peripheral limb variability as a proxy to evoke centrally driven intentional acts. Frontiers in Integrative Neuroscience. 7, 46 (2013).

- Torres, E. B. . Objective Biometric Methods for the Diagnosis and Treatment of Nervous System Disorders. , (2018).

- Torres, E. B., et al. Toward Precision Psychiatry: Statistical Platform for the Personalized Characterization of Natural Behaviors. Frontiers in Neurology. 7, 8 (2016).

- Wu, D., et al. How doing a dynamical analysis of gait movement may provide information about Autism. APS March Meeting Abstracts. , (2017).

- Torres, E. B., et al. Characterization of the statistical signatures of micro-movements underlying natural gait patterns in children with Phelan McDermid syndrome: towards precision-phenotyping of behavior in ASD. Frontiers in Integrative Neuroscience. 10, 22 (2016).

- Kalampratsidou, V. Peripheral Network Connectivity Analyses for the Real-Time Tracking of Coupled Bodies in Motion. Sensors. , (2018).

- Brincker, M., Torres, E. B. Noise from the periphery in autism. Frontiers in Integrative Neuroscience. 7, 34 (2013).

- Torres, E. B., Denisova, K. Motor noise is rich signal in autism research and pharmacological treatments. Scientific Reports. 6, 37422 (2016).