Contrôle proxy en temps réel des signaux périphériques re-paramétrisés à l’aide d’une interface en boucle étroite

Summary

Nous présentons des protocoles et des méthodes d’analyse pour construire des interfaces co-adaptatives qui diffusent, paramétrisent, analysent et modifient les signaux du corps humain et du cœur en boucle rapprochée. Cette configuration interface les signaux dérivés des systèmes nerveux périphériques et centraux de la personne avec des entrées sensorielles externes pour aider à suivre le changement biophysique.

Abstract

Les champs qui développent des méthodes de substitution sensorielle et d’augmentation sensorielle ont visé à contrôler les objectifs externes à l’aide de signaux du système nerveux central (SNC). Cependant, les protocoles qui mettent à jour les signaux externes autogénérés par des corps interactifs en mouvement sont moins fréquents. Il ya un manque de méthodes qui combinent les biorythmes corps-cœur-cerveau d’un agent en mouvement pour orienter ceux d’un autre agent en mouvement pendant l’échange dyade. Une partie du défi pour accomplir un tel exploit a été la complexité de la configuration en utilisant des bio-signaux multimodaux avec différentes unités physiques, des échelles de temps disparates et des fréquences d’échantillonnage variables.

Ces dernières années, l’avènement de bio-capteurs portables qui peuvent exploiter de manière non invasive plusieurs signaux en tandem, a ouvert la possibilité de re-paramétriser et de mettre à jour les signaux périphériques des dyades en interaction, en plus d’améliorer les interfaces cerveau-et/ou corps-machine. Nous présentons ici une interface co-adaptative qui met à jour la sortie somatique-moteur efferent (y compris la cinématique et la fréquence cardiaque) à l’aide de biocapteurs; paramétrise les bio-signaux stochastiques, sonifie cette sortie et la redy paramétrise sous forme re-paramétrisée sous forme d’entrée réaffecté visuo/audio-kinesthésique. Nous montrons les méthodes utilisant deux types d’interactions, l’une impliquant deux humains et l’autre impliquant un humain et son avatar interagissant en temps quasi réel. Nous discutons des nouvelles méthodes dans le contexte de nouvelles façons possibles de mesurer les influences de l’apport externe sur le contrôle interne somatique-sensoriel-moteur.

Introduction

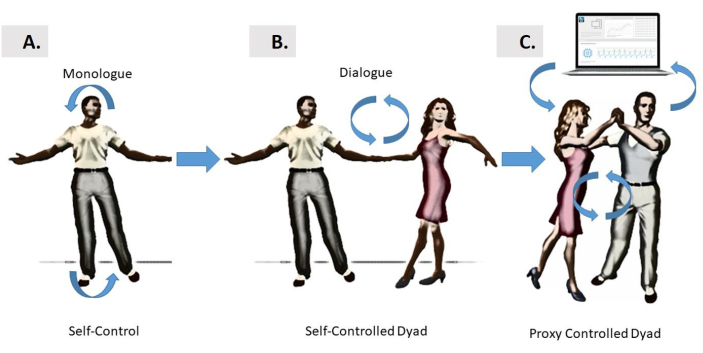

Le contrôleur naturel en boucle rapprochée

L’information sensoro-motrice circule continuellement entre le cerveau et le corps pour produire des comportements bien organisés et coordonnés. De tels comportements peuvent être étudiés tout en se concentrant uniquement sur les actions de la personne, comme dans un style monologue (Figure 1A), ou lors d’actions dynamiques complexes partagées entre deux agents dans une dyade, comme dans un style de dialogue (Figure 1B). Pourtant, une troisième option consiste à évaluer ces interactions complexes par l’intermédiaire d’un contrôleur proxy, dans le contexte d’une interface en boucle étroite homme-ordinateur (figure 1C). Une telle interface peut suivre les fluctuations des mouvements moment par moment apportées par chaque agent dans la dyade, et par le type de cohésion qui émerge de leurs interactions synchrones, aidant à orienter les rythmes de la dyade de manière souhaitable.

Figure 1: Différentes formes de contrôle. ( A )Lesinterfaces auto-contrôlées par le cerveau reposent sur les relations en boucle étroite entre le cerveau de la personne et son propre corps, qui peuvent s’autoréguler et s’auto-interagir dans le style « monologue ». Ce mode tente le contrôle des mouvements autogénérés, ou il peut également viser à contrôler les périphériques externes. (B) Le contrôle du style « Dialogue » est introduit pour deux danseurs qui interagissent les uns avec les autres et par l’entraînement physique et la prise de tour pour prendre le contrôle des mouvements de l’autre. (C) Le contrôle du dialogue « tiers » de la dyade est introduit sous la forme d’une interface informatique qui exploite en tandem les bio-signaux des deux danseurs, le paramétrise et le redyle aux danseurs sous forme remétr paramétrisée en utilisant l’audio et/ou la vision comme formes de guidage sensoriel. La re-paramétrisation dans les exemples présentés ici ont été atteints à l’aide de rétroaction audio ou visuelle, renforcée par la sortie motrice kinesthésique en temps réel de l’un des danseurs pour influencer l’autre; ou des deux danseurs, à tour de rôle dans un motif alternatif. S’il vous plaît cliquez ici pour voir une version plus grande de ce chiffre.

L’objectif global de cette méthode est de montrer qu’il est possible d’exploiter, de paramétriser et de re-paramétriser les fluctuations moment par moment dans les activités biorythmiques des corps en mouvement, car deux agents s’engagent dans un échange dynamique qui peut impliquer deux humains, ou un humain et son avatar auto-mobile.

Les investigations sur la façon dont le cerveau peut contrôler les actions et prédire leurs conséquences sensorielles ont généré de nombreuses lignes de demandes théoriques dans les1,2,3 et ont produit divers modèles de contrôle neuromoteur4,5,6,7,8. Une ligne de recherche dans ce domaine multidisciplinaire a impliqué le développement d’interfaces cerveau-machine ou cerveau-ordinateur en boucle rapprochée. Ces types de configurations offrent des moyens d’exploiter et d’adapter les signaux CNS pour contrôler un dispositif externe, comme un brasrobotique 9,10,11, un exosquelette12, un curseur sur un écran d’ordinateur13 (entre autres). Tous ces appareils externes partagent la propriété qu’ils n’ont pas de propre intelligence. Au lieu de cela, le cerveau qui essaie de les contrôler a, et une partie du problème auquel le cerveau est confronté est d’apprendre à prédire les conséquences des mouvements qu’il génère dans ces dispositifs (par exemple, les mouvements du curseur, les mouvements du bras robotique, etc) tout en générant d’autres mouvements de soutien qui contribuent à la rétroaction motrice sensorielle globale sous la forme de reafference kinesthésique. Souvent, le but primordial de ces interfaces a été d’aider la personne derrière ce cerveau à contourner une blessure ou un trouble, à retrouver la transformation de ses pensées intentionnelles en actes physiques volontairement contrôlés du dispositif externe. Moins fréquent cependant a été le développement d’interfaces qui tentent de diriger les mouvements des corps en mouvement.

Une grande partie de la recherche originale sur les interfaces cerveau-machine se concentrent sur le contrôle du système nerveux central (SNC) sur les parties du corps qui peuvent accomplir des actions dirigéespar des objectifs 9,14,15,16,17. Il existe toutefois d’autres situations où l’utilisation des signaux dérivés des activités du système nerveux périphérique (SPN), y compris celles du système nerveux autonome (ANS), est suffisamment instructive pour influencer et orienter les signaux des agents externes, y compris d’un autre humain ou avatar, ou même interagir avec les humains (comme dans la figure 1C). Contrairement à un bras robotique ou curseur, l’autre agent dans ce cas, a l’intelligence entraînée par un cerveau (dans le cas de l’avatar qui a été doté des mouvements de la personne, ou d’un autre agent, dans le cas d’une dyade humaine en interaction).

Une configuration qui crée un environnement d’interface co-adaptative en boucle rapprochée avec échange dyadique peut être d’usage pour intervenir dans les troubles du système nerveux par lequel le cerveau ne peut pas contrôler volitionally son propre corps en mouvement à volonté, bien qu’il n’ait pas physiquement coupé le pont entre le SNC et le PNS. Cela peut être le cas en raison de signaux périphériques bruyants par lesquels les boucles de rétroaction pour aider le cerveau à surveiller et ajuster en permanence ses propres biorythmes autogénérés peuvent avoir été perturbés. Ce scénario se produit chez les patients atteints de la maladie de Parkinson18,19, ou chez les participants atteints de troubles du spectre autistique avec un excès de bruit dans leur production motrice. En effet, dans les deux cas, nous avons quantifié des niveaux élevés de rapport bruit-signal dans les signaux kinesthésiques de retour dérivés de la vitessede leurs mouvements prévus 20,21,22 et du cœur23. Dans de tels cas, essayer de maîtriser le contrôle du cerveau des signaux externes, tout en essayant de contrôler le corps en mouvement, peut entraîner un signal auto-réactif du flux d’informations réintéser (re-afferent) que le cerveau reçoit du flux moteur continu (efferent) à la périphérie. En effet, les fluctuations moment par moment présentes dans un tel flux moteur efferent autogénéré contiennent des informations importantes utiles pour aider à la prédiction des conséquences sensorielles des actions délibérées24. Lorsque cette rétroaction est corrompue par le bruit, il devient difficile de mettre à jour de façon prévisible les signaux de commande et de ponter les plans intentionnels par des actes physiques.

Si nous étendions une telle boucle de rétroaction à un autre agent et contrôlions les interactions de la personne et de l’agent par l’intermédiaire d’un tiers(figure 1C),nous pourrions avoir la chance de diriger les performances de l’autre en temps quasi réel. Cela nous fournirait la preuve de concept que nous aurions besoin d’étendre la notion d’interfaces cerveau-corps-cerveau co-adaptatif ou cerveau-machine pour traiter les troubles du système nerveux qui entraînent une mauvaise réalisation de la volonté physique de l’intention mentale.

Les actions délibérées ont des conséquences, qui sont précisément caractérisées par des signatures stochastiques motrices qui dépendent du contexte et permettent l’inférence de niveaux d’intention mentale avec une grandecertitude 25,26. Ainsi, un avantage d’une nouvelle méthode qui tire parti de l’échange dydique sur les approches antérieures centrées sur la personne à la machine cérébrale ou interfaces informatiques du cerveau, est que nous pouvons augmenter les signaux de contrôle pour inclure les biorythmes corporels et cardiaques qui transpirent en grande partie sous la conscience de la personne, sous différents niveaux d’intention. De cette façon, nous amortissons les interférences réactives que le contrôle conscient tend à évoquer dans le processus d’adaptation du contrôle cerveau-curseur17. Nous pouvons ajouter plus de certitude au processus prédictif en paramétrisant les différents signaux que nous pouvons accéder. Dans ce sens, il existe des travaux antérieurs utilisant des signaux cérébraux et corporels en tandem27,28,29; mais les travaux impliquant des interactions dyades capturées par les signaux cérébraux restent rares. En outre, la littérature existante n’a pas encore délimité la distinction entre les segments délibérés de l’action exécutée sous pleine conscience et les motions transitoires qui se produisent spontanément à la suite des mouvementsdélibérés 30,31. Ici, nous faisons cette distinction dans le contexte de l’échange dyade, et offrons de nouvelles façons d’étudier cette dichotomie32, tout en fournissant des exemples de chorégraphiés (délibéré) vs improvisé (spontané) mouvements dans l’espace de danse.

En raison des retards de transduction et de transmission dans les processus d’intégration et de transformation sensorielle-motrice33,il est nécessaire d’avoir un tel code prédictif en place, d’apprendre à anticiper l’entrée sensorielle à venir avec une grande certitude. À cette fin, il est important de pouvoir caractériser l’évolution du rapport bruit-signal dérivé des signaux dans le flux kinesthésique de réafferent continuellement mis à jour. Nous avons ensuite besoin de protocoles en place pour mesurer systématiquement l’évolution de la variabilité motrice. La variabilité est intrinsèquement présente dans les fluctuations moment par moment du courant moteur sortant34. Étant donné que ces signaux ne sont pas stationnaires et sensibles aux variationscontextuelles 35,36, il est possible de paramétriser les changements qui se produisent avec des modifications du contexte des tâches. Afin de minimiser les interférences des signaux réactifs qui émergent du contrôle conscient du SNC, et d’évoquer des changements quantifiables dans le flux moteur Efferent PNS, nous introduisons ici une interface proxy en boucle étroite qui modifie indirectement la rétroaction sensorielle, en recrutant le signal périphérique qui change en grande partie sous la conscience de soi de la personne. Nous montrons ensuite des moyens de mesurer systématiquement le changement qui s’ensuit les manipulations sensorielles, en utilisant des analyses stochastiques permettant de visualiser le processus que l’interface proxy boucle rapprochée évoque indirectement chez les deux agents.

Présentation d’un contrôleur proxy en boucle rapprochée

La variabilité sensoro-motrice présente dans les signaux périphériques constitue une riche source d’information pour guider les performances du système nerveux tandis que l’apprentissage, l’adaptation et la généralisation ont lieu dans différents contextes37. Ces signaux apparaissent en partie comme un sous-produit de la SNC qui tente de contrôler les actions de façon volontaire, mais qui n’est pas l’objectif direct du contrôleur. Comme la personne interagit naturellement avec les autres, les signaux périphériques peuvent être exploités, normalisés et re-paramétrisés; ce qui signifie que leurs variations peuvent être paramétrisées et systématiquement décalées, car on modifie le flux moteur efferent qui revient continuellement dans le système comme une réafférence kinesthésique. Dans de tels contextes, nous pouvons visualiser les changements stochastiques, capturant avec une grande précision un signal riche qui est autrement perdu aux types de grande moyenne que les techniques plus traditionnelles effectuent.

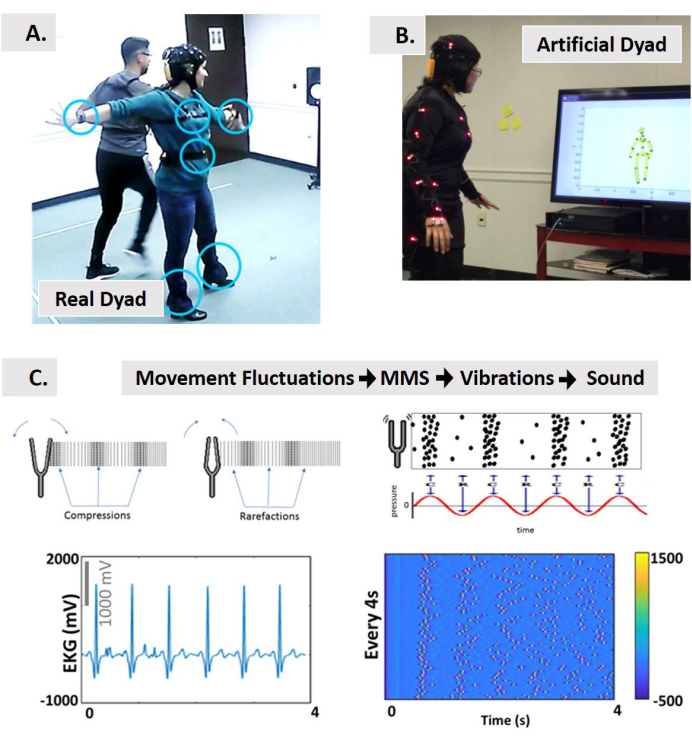

Pour parvenir à la caractérisation du changement sous la nouvelle plate-forme statistique, nous introduisons ici des protocoles, des types de données normalisés et des analyses qui permettent l’intégration d’entrées sensorielles externes (auditives et visuelles) avec des signaux moteurs autogénérés en interne, tandis que la personne interagit naturellement avec une autre personne, ou avec une version avatar de la personne. En ce sens, parce que nous visons à contrôler les signaux périphériques (plutôt que de modifier les signaux CNS pour contrôler directement l’appareil ou le média externe), nous inventons ceci une interface proxy en boucle étroite (Figure 2). Nous visons à caractériser les changements dans les signaux stochastiques du SNR, car ils ont un impact sur ceux du SNC.

Figure 2: Contrôle indirect d’une interaction dyadique à l’aide d’une interface multimodale en boucle étroite. (A) Contrôle indirect de deux danseurs (salsa dansante) via une interface co-adaptative par ordinateur vs (B) une dyade interactive artificielle avatar-personne contrôlée en exploitant les signaux périphériques du système nerveux et en le remétrisant sous forme de sons et/ou d’entrée visuelle. (C) Le concept de sonification à l’aide d’un nouveau type de données normalisées (les pointes de micro-mouvement, MMS) dérivé des fluctuations moment par moment de l’amplitude/synchronisation des signaux biorythmiques convertis en vibrations, puis en son. De la physique, nous empruntons les notions de compressions et de rares faits produits par une fourchette de réglage qui produit l’onde sonore comme vibrations mesurables. Les schémas des ondes sonores représentés sous forme de pression modulée au fil du temps en parallèle aux concentrations de pointes pour la sonification. Exemple d’un signal physique pour subir le pipeline proposé de MMS à des vibrations et à la sonification. Nous utilisons le signal de fréquence cardiaque comme entrée à l’interface. Cela prend des fluctuations dans l’amplitude du signal alignées à l’apparition du mouvement toutes les 4 secondes de mouvement et construit des trains MMS représentant les vibrations. Les trains à pointes du MMS sont normalisés à partir de [0,1]. La couleur des pointes selon la barre de couleur, représente l’intensité du signal. Nous sonifions ensuite ces vibrations à l’aide de Max. Ce signal sonifié peut être utilisé pour lire en A, ou pour modifier en B les interactions avec l’avatar. En outre, en B, il est possible d’intégrer le son dans l’environnement et d’utiliser la position du corps pour jouer le son en arrière à une région d’intérêt (RoI), ou de moduler les caractéristiques audio en fonction de la distance à la RoI, la vitesse ou l’accélération d’une partie du corps ancrée à une autre partie du corps, lors du passage par le RoI. S’il vous plaît cliquez ici pour voir une version plus grande de ce chiffre.

Les signaux PNS peuvent être exploités de manière non invasive avec des technologies de détection portable qui co-enregistrent des flux efferents multimodaux de différentes couches fonctionnelles du système nerveux, allant de l’autonome auvolontaire 32. Nous pouvons ensuite mesurer en temps quasi réel les changements dans ces flux et sélectionner ceux dont les modifications améliorent le rapport signal-bruit. Ce signal moteur éfferent peut alors être augmenté avec d’autres formes de guidage sensoriel (p. ex., auditive, visuelle, etc.) Parce que le PNS signale une conscience totale du paysage, ils sont plus faciles à manipuler sans beaucoup de résistance 38. En tant que tel, nous les utilisons pour aider à orienter la performance de la personne d’une manière qui peut être moins stressante pour le système humain.

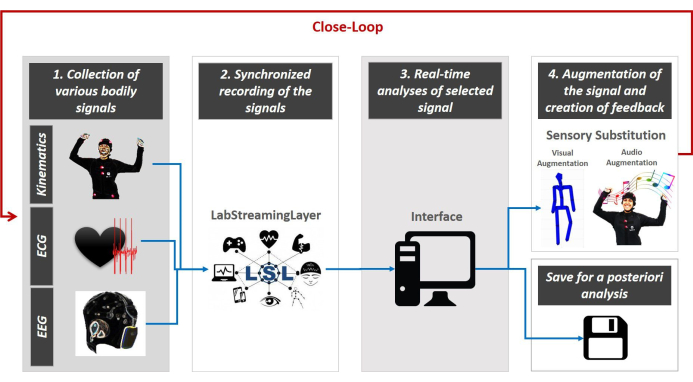

Construction de l’interface

Nous présentons la conception du contrôle proxy médié par une interface multimodale co-adaptative en boucle étroite. Cette interface oriente la rétroaction multisensorielle en temps réel. La figure 3 affiche la conception générale.

L’interface boucle rapprochée se caractérise par 5 étapes principales. La première étape est la collecte de données multimodales à partir de multiples instruments portable. La 2ème étape est la synchronisation des flux multimodaux à travers la plate-forme de LabStreamingLayer (LSL, https://github.com/sccn/labstreaminglayer) développée par le groupe MoBI 39. La 3ème étape est la diffusion de la structure de données LSL vers une interface python, MATLAB ou autre langage de programmation pour intégrer les signaux et paramétiser empiriquement les fonctionnalités physiologiques (pertinentes à notre configuration expérimentale) en temps réel. La 4ème étape consiste à re-paramétriser les caractéristiques sélectionnées extraites du flux continu du signal corporel étudié et à l’augmenter à l’aide d’une modalité sensorielle de choix (par exemple, visuelle, auditive, kinesthésique, etc.) pour le rejouer sous forme de sons ou de visuels, pour augmenter, remplacer ou améliorer la modalité sensorielle qui est problématique dans le système nerveux de la personne. Enfin, la 5ème étape consiste à réévaluer les signatures stochastiques des signaux générés par le système en temps réel, à sélectionner quelles modalités sensorielles apportent les changements stochastiques des fluctuations corporelles à un régime de haute certitude (minimisation du bruit) dans la prédiction des conséquences sensorielles de l’action imminente. Cette boucle est jouée en continu tout au long de l’expérience en se concentrer sur le signal sélectionné, tout en stockant la performance complète pour les analyses ultérieures (comme indiqué dans les schémas de la figure 3 etvoir 40,41,42,43,44,45,46,47 pourun exemple d’analyses posteriori).

Figure 3: L’architecture du concept d’interface en boucle étroite multimodale à boucle périphérique. Divers signaux corporels sont recueillis – données cinétiques, activité cardiaque et cérébrale (étape 1). LSL est utilisé pour co-enregistrer et diffuser de façon synchrone les données provenant de divers équipements vers l’interface (étape 2). Python/MATLAB/C# code est utilisé pour paramétriser en permanence les fluctuations des signaux à l’aide d’un type de données normalisé et d’une échelle commune qui permet de sélectionner la source de guidage sensoriel la plus adéquate pour atténuer l’incertitude du système (étape 3). Cette amélioration en temps réel de la transmission du signal par le biais de certains canaux permet ensuite de re-paramétriser le signal sensoriel de réintégration pour s’intégrer dans le flux moteur continu et améliorer le flux d’entrée perdu ou corrompu (étape de substitution sensorielle 4). Une nouvelle évaluation continue ferme la boucle (étape 5) et nous en sauvons toutes les données pour d’autres analyses futures. S’il vous plaît cliquez ici pour voir une version plus grande de ce chiffre.

Les sections suivantes présentent le protocole générique de la façon de construire une interface en boucle étroite (telle que décrite dans la figure 3)et décrivent les résultats représentatifs de deux interfaces expérimentales (minutieusement présentées dans Le matériel supplémentaire) impliquant l’interaction dyade physique entre deux danseurs (véritable système en boucle étroite) et l’interaction dyade virtuelle entre une personne et un avatar (système artificiel en boucle rapprochée).

Protocol

Representative Results

Discussion

Cet article introduit le concept de contrôle par procuration par le biais d’interfaces co-adaptatives, interactives et multimodales en boucle étroite qui exploitent, paramétrisent et remétrisent le signal périphérique de la personne dans le contexte de l’échange dyadique. Nous voulions caractériser les changements stochastiques dans les fluctuations des biorythmes de la personne et paramétriser le changement. En outre, nous voulions orienter systématiquement les signatures stochastiques de leurs biorythmes vers des niveaux ciblés de régimes de bruit à signal en temps quasi réel.

Nous avons présenté un protocole générique pour la construction d’une interface en boucle étroite qui satisfaisait 5 éléments de base : 1) la collecte de données corporelles multiples provenant du SNC, du PNS et de l’ANS à l’aide de divers instruments et technologies; 2) l’enregistrement et la diffusion synchronisés des données; 3) l’analyse en temps réel des signaux sélectionnés; 4) la création d’une augmentation sensorielle (audio, visuelle, etc.) à l’aide de caractéristiques physiologiques extraites pour les signaux corporels; et 5) le suivi continu du système humain et l’augmentation sensorielle parallèle ferme la boucle de l’interaction entre l’humain et le système.

Le protocole générique a été appliqué sur deux interfaces d’exemple. Le premier étudie l’échange dyadique entre deux agents humains et le second entre un humain et un agent avatar. Les deux types de dyades ont été utilisés pour fournir la preuve de concept que le signal périphérique peut être systématiquement modifié en temps réel et que ces changements stochastiques peuvent être suivis avec précision. L’une dyade était composée de deux participants qui interagissaient physiquement, tandis que l’autre impliquait un participant interagissant avec un agent virtuel sous la forme d’un avatar rendu en 3D doté des mouvements de la personne et de variantes modifiées de ces mouvements en temps réel. Ces altérations ont été évoquées par des manipulations interactives entraînées par des entrées sensorielles auditives et/ou visuelles dans un cadre de sensations augmentées. Dans le vrai dyade et le dyade artificiel, nous avons démontré la faisabilité de déplacer à distance les signaux périphériques, y compris les biorythmes corporels et les signaux autonomes du rythme cardiaque.

Nous avons présenté de nouveaux protocoles expérimentaux pour sonder ces changements dans la variabilité du moteur efferent, car les flux de signaux kinesthésiques sont manipulés et remétrisés en temps quasi réel. Cette information de réinsertence (reafferencekinesthésique 48)s’est avérée utile pour déplacer les performances des systèmes en temps réel. Ils portent des informations sur les conséquences sensorielles de l’action, que nous pouvons être suivis avec précision en utilisant les méthodes que nous avons présentées ici.

Nous avons également montré des types de données et des méthodes statistiques qui nous permettaient de normaliser nos analyses. Nous avons fourni de multiples outils de visualisation pour démontrer les changements en temps réel dans les activités physiologiques qui évoluent naturellement dans différents contextes, avec une inférence statistique guidée empiriquement qui se prête à l’interprétation des signaux autogénérés et auto-contrôlés du système nerveux. Fait important, les changements qui ont été évoqués par le contrôleur proxy étaient lisses et pourtant quantifiables, ce qui appuie l’idée que l’activité périphérique est utile de plus d’une manière. Bien que nous puissions mettre en œuvre ces méthodes à l’aide de capteurs portable sans fil disponibles dans le commerce, nous pouvons systématiquement induire des changements dans les performances qui sont capturables dans les rythmes biophysiques sans stresser le système. Il est important de traduire nos méthodes dans l’arène clinique et de les utiliser comme un lit d’essai pour développer de nouveaux modèles d’intervention (par exemple, comme lors de l’utilisation de la réalité augmentée dans l’autisme 49). Dans de tels modèles, nous serons en mesure de suivre et de quantifier les conséquences sensorielles des actions naturalistes de la personne, car les entrées sensorielles sont manipulées avec précision, et la sortie est paramétrisée et re-paramétrisée en temps quasi réel.

Nous offrons ce protocole comme modèle général pour utiliser diverses activités biorythmiques autogénérés par les systèmes nerveux humains et exploités de façon non invasive avec des portables sans fil. Bien que nous 199ions utilisé un ensemble de biocapteurs pour enregistrer l’EEG, l’ECG et la cinématique dans cet article, les méthodes d’enregistrement, de synchronisation et d’analyse des signaux sont générales. L’interface peut ainsi intégrer d’autres technologies. En outre, les protocoles peuvent être modifiés pour inclure d’autres actions et contextes naturalistes qui s’étendent au domaine médical. Parce que nous avons visé pour les comportements naturels, la configuration que nous avons développé peut être utilisé dans des paramètres ludiques (par exemple, impliquant les enfants et les parents.)

Plusieurs troubles du système nerveux pourraient bénéficier de telles approches ludiques du problème de contrôle. Dans les deux types d’interactions dyadiques que nous avons montré ici, les participants pouvaient viser à contrôler consciemment la musique, tandis que le contrôleur proxy utilise la sortie périphérique pour manipuler inconsciemment et déplacer systématiquement ses signatures. Parce que les scientifiques ont passé des années empiriquement à cartographier le plan de paramètres Gamma et l’espace correspondant des moments Gamma à travers différents groupes d’âge (nouveau-nés à 78 ans)19,50,51,52,53 et les conditions (autisme, La maladie de Parkinson, accident vasculaire cérébral, état de coma et de désafferentation), pour différents niveaux de contrôle (volontaire, automatique, spontané, involontaire et autonome)25,47,54, ils ont mesuré empiriquement des critères désignant où sur les espaces Gamma les signatures stochastiques devraient être pour un bon contrôle prédictif. Des recherches antérieures ont également montré que nous savons où sont les paramètres en présence de bruit aléatoire spontané provenant des rythmes autogénérés des systèmes nerveuxhumains 7,19,55,56. Dans un schéma d’optimisation minimisant le bruit moteur biorythmique, nous pouvons ainsi viser à conduire les signaux de manière à atteindre les zones ciblées des espaces Gamma où la forme et la dispersion des signatures de la famille des PDF de chaque personne est propice à un rapport signal/bruit élevé et à des valeurs prédictives. En ce sens, nous ne perdons pas de données brutes et nous les utilisons plutôt efficacement pour conduire le système vers des niveaux souhaitables de bruit dans une situation donnée.

Les interactions dyades sont omniprésentes dans les milieux cliniques ou de formation. Elles peuvent se produire entre le formateur et le stagiaire; le médecin et le patient; le thérapeute clinique et le patient; et ils peuvent également se produire dans des contextes de recherche qui impliquent la science translationnelle et engagent le chercheur et le participant. Un des avantages des protocoles actuels est que, bien qu’ils soient conçus pour les dyades, ils sont également personnalisés. En tant que tel, il est possible d’adapter les interactions co-adaptatives aux meilleures capacités et prédispositions de la personne, en fonction de leurs amplitudes de mouvement, de leurs plages de temps de traitement sensoriel et tout en tenant compte des plages dans l’amplitude des signaux à travers la hiérarchie fonctionnelle des systèmes nerveux de la personne. Au fur et à mesure que la trajectoire stochastique émerge et évolue dans le temps, il est également possible de déterminer les taux de chances des signatures et d’utiliser cette série de temps pour prévoir plusieurs événements imminents ainsi que d’éventuelles conséquences sensorielles.

Enfin, des interfaces en boucle étroite pourraient même être utilisées dans le monde de l’art. Ils pourraient offrir aux artistes de la scène de nouvelles avenues pour générer des formes informatiques de danses modernes, de danses technologiques et de nouvelles formes de visualisation et de sonification de l’expression corporelle. Dans de tels contextes, le corps du danseur peut être transformé en un instrument sensoriel pour explorer avec souplesse différentes modalités sensorielles par la sonification et la visualisation des activités biorythmiques autogénérées, comme le montrent les travaux antérieursdans ce domaine 40,41,43,46. Une telle performance pourrait augmenter le rôle d’un danseur sur scène et laisser le public éprouver des signaux corporels subtils au-delà du mouvement visible.

Plusieurs aspects de cette technologie nécessitent un développement et des tests supplémentaires pour optimiser leur utilisation en temps réel. Le streaming synchrone exige une puissance et une capacité de mémoire cpu/GPU à grande vitesse pour vraiment exploiter la notion de gagner du temps et d’avoir une longueur d’avance lors de la prévision des conséquences sensorielles des commandes motrices en cours. Les taux d’échantillonnage de l’équipement devraient être comparables afin d’être en mesure d’aligner véritablement les signaux, d’effectuer une fusion sensorielle appropriée et d’explorer la transmission de l’information par les différents canaux du système nerveux. Ce sont quelques-unes des limitations présentes dans cette nouvelle interface.

Dans l’ensemble, ce travail offre un nouveau concept pour améliorer le contrôle de notre système corporel tout en employant des moyens subliminaux qui permettent néanmoins des mesures systématiques normalisées des résultats du changement stochastique.

Disclosures

The authors have nothing to disclose.

Acknowledgements

Nous remercions les étudiants qui ont donné de leur temps pour aider à effectuer cette recherche; Kan Anant et phaseSpace Inc. pour nous avoir fourni les images et les vidéos nécessaires pour décrire la mise en place; et Neuroélectronique pour nous permettre d’utiliser du matériel du canal www.youtube.com/c/neuroelectrics/ et leurs manuels. Enfin, nous remercions le Professeur Thomas Papathomas du Rutgers Center for Cognitive Science pour son soutien professionnel pendant les étapes de soumission de ce manuscrit, le Prix nancy Lurie Marks pour le développement de carrière de la Fondation familiale à EBT et le Prix de la Fondation Gerondelis à VK.

Contributions

Conceptualisation, VK et EBT; méthodologie, EBT; logiciels, VK, EBT, SK.; validation, VK et SK; analyse formelle, VK; enquête, VK, EBT, SK; ressources, EBT; curation des données, VK; rédaction — préparation originale du projet, EBT; rédaction — examen et édition, VK, SK.; visualisation, VK et EBT.; supervision, EBT.; l’administration du projet, EBT.; financement de l’acquisition, EBT Tous les auteurs ont lu et accepté la version publiée du manuscrit.

Materials

| Enobio 32 | Enobio | Hardware for EEG data collection | |

| Enobio ECG Extention | Enobio | Hardware for ECG data collection | |

| LabStreamingLayer (LSL) | Synchronization and streaming of data | ||

| Matlab | Mathwork | Analysis and processing of data | |

| Max | Cycling'74 | Sonification of bodily information | |

| NIC.2 | Enobio | Software for EEG and ECG data collection | |

| PhaseSpace Impulse | PhaseSpace | Hardware for collection of the kinematic data (position, speed, acceleration) | |

| Python3 | Python | Analysis and processing of data | |

| Recap | PhaseSpace | Software for collection of the kinematic data (position, speed, acceleration) |

References

- Kawato, M., Wolpert, D. Internal models for motor control. Novartis Foundation Symposium. 218, 291-304 (1998).

- Wolpert, D. M., Kawato, M. Multiple paired forward and inverse models for motor control. Neural Networks. 11 (7-8), 1317-1329 (1998).

- Wolpert, D. M., Miall, R. C., Kawato, M. Internal models in the cerebellum. Trends in Cognitive Sciences. 2 (9), 338-347 (1998).

- Todorov, E., Jordan, M. I. Optimal feedback control as a theory of motor coordination. Nature Neuroscience. 5 (11), 1226-1235 (2002).

- Todorov, E. Optimality principles in sensorimotor control. Nature Neuroscience. 7 (9), 907-915 (2004).

- Torres, E. B. . Theoretical Framework for the Study of Sensori-motor Integration. , (2001).

- Harris, C. M., Wolpert, D. M. Signal-dependent noise determines motor planning. Nature. 394 (20), 780-784 (1998).

- Torres, E. B., Zipser, D. Reaching to Grasp with a Multi-jointed Arm (I): A Computational Model. Journal of Neurophysiology. 88, 1-13 (2002).

- Carmena, J. M., et al. Learning to control a brain-machine interface for reaching and grasping by primates. PLoS Biology. 1 (2), 42 (2003).

- Hwang, E. J., Andersen, R. A. Cognitively driven brain machine control using neural signals in the parietal reach region. 2010 Annual International Conference of the IEEE Engineering in Medicine and Biology. 2010, 3329-3332 (2010).

- Andersen, R. A., Kellis, S., Klaes, C., Aflalo, T. Toward more versatile and intuitive cortical brain-machine interfaces. Current Biology. 24 (18), 885-897 (2014).

- Contreras-Vidal, J. L., et al. Powered exoskeletons for bipedal locomotion after spinal cord injury. Journal of Neural Engineering. 13 (3), 031001 (2016).

- Choi, K., Torres, E. B. Intentional signal in prefrontal cortex generalizes across different sensory modalities. Journal of Neurophysiology. 112 (1), 61-80 (2014).

- Hwang, E. J., Andersen, R. A. Cognitively driven brain machine control using neural signals in the parietal reach region. 2010 Annual International Conference of the IEEE Engineering in Medicine and Biology. 2010, 3329-3332 (2010).

- Andersen, R. A., Kellis, S., Klaes, C., Aflalo, T. Toward more versatile and intuitive cortical brain-machine interfaces. Current Biology. 24 (18), 885-897 (2014).

- Contreras-Vidal, J. L., et al. Powered exoskeletons for bipedal locomotion after spinal cord injury. Journal of Neural Engineering. 13 (3), 031001 (2016).

- Choi, K., Torres, E. B. Intentional signal in prefrontal cortex generalizes across different sensory modalities. Journal of Neurophysiology. 112 (1), 61-80 (2014).

- Yanovich, P., Isenhower, R. W., Sage, J., Torres, E. B. Spatial-orientation priming impedes rather than facilitates the spontaneous control of hand-retraction speeds in patients with Parkinson’s disease. PLoS One. 8 (7), 66757 (2013).

- Torres, E. B., Cole, J., Poizner, H. Motor output variability, deafferentation, and putative deficits in kinesthetic reafference in Parkinson’s disease. Frontiers in Human Neuroscience. 8, 823 (2014).

- Torres, E. B., et al. Toward Precision Psychiatry: Statistical Platform for the Personalized Characterization of Natural Behaviors. Frontiers in Human Neuroscience. 7, 8 (2016).

- Torres, E. B., Cole, J., Poizner, H. Motor output variability, deafferentation, and putative deficits in kinesthetic reafference in Parkinson’s disease. Frontiers in Human Neuroscience. 8, 823 (2014).

- Torres, E. B., et al. Autism: the micro-movement perspective. Frontiers in Integrative Neuroscience. 7, 32 (2013).

- Ryu, J., Vero, J., Torres, E. B. . MOCO ’17: Proceedings of the 4th International Conference on Movement Computing. , 1-8 (2017).

- Brincker, M., Torres, E. B. Noise from the periphery in autism. Frontiers in Integrative Neuroscience. 7, 34 (2013).

- Torres, E. B. Two classes of movements in motor control. Experimental Brain Research. 215 (3-4), 269-283 (2011).

- Torres, E. B. Signatures of movement variability anticipate hand speed according to levels of intent. Behavioral and Brain Functions. 9, 10 (2013).

- Gramann, K., et al. Cognition in action: imaging brain/body dynamics in mobile humans. Reviews in the Neurosciences. 22 (6), 593-608 (2011).

- Makeig, S., Gramann, K., Jung, T. P., Sejnowski, T. J., Poizner, H. Linking brain, mind and behavior. International Journal of Psychophysiology. 73 (2), 95-100 (2009).

- Ojeda, A., Bigdely-Shamlo, N., Makeig, S. MoBILAB: an open source toolbox for analysis and visualization of mobile brain/body imaging data. Frontiers in Human Neuroscience. 8, 121 (2014).

- Casadio, M., et al. . IEEE International Conference on Rehabilitation Robotics. , (2019).

- Pierella, C., Sciacchitano, A., Farshchiansadegh, A., Casadio, M., Mussaivaldi, S. A. . 7th IEEE International Conference on Biomedical Robotics and Biomechatronics. , (2018).

- Torres, E. B. Two classes of movements in motor control. Experimental Brain Research. 215 (3-4), 269-283 (2011).

- Purves, D. . Neuroscience. Sixth edition. , (2018).

- Torres, E. B. Signatures of movement variability anticipate hand speed according to levels of intent. Behavioral and Brain Functions. 9, 10 (2013).

- Torres, E. B. The rates of change of the stochastic trajectories of acceleration variability are a good predictor of normal aging and of the stage of Parkinson’s disease. Frontiers in Integrative Neuroscience. 7, 50 (2013).

- Torres, E. B., Vero, J., Rai, R. Statistical Platform for Individualized Behavioral Analyses Using Biophysical Micro-Movement Spikes. Sensors (Basel). 18 (4), (2018).

- Torres, E. B. . Progress in Motor Control. , 229-254 (2016).

- Torres, E. B., Yanovich, P., Metaxas, D. N. Give spontaneity and self-discovery a chance in ASD: spontaneous peripheral limb variability as a proxy to evoke centrally driven intentional acts. Frontiers in Integrative Neuroscience. 7, 46 (2013).

- Gramann, K., Jung, T. P., Ferris, D. P., Lin, C. T., Makeig, S. Toward a new cognitive neuroscience: modeling natural brain dynamics. Frontiers in Human Neuroscience. 8, 444 (2014).

- Kalampratsidou, V., Torres, E. B. Bodily Signals Entrainment in the Presence of Music. Proceedings of the 6th International Conference on Movement and Computing. , (2019).

- Kalampratsidou, V., Torres, E. B. Sonification of heart rate variability can entrain bodies in motion. Proceedings of the 7th International Conference on Movement and Computing. , (2020).

- Kalampratsidou, V. . Co-adaptive multimodal interface guided by real-time multisensory stochastic feedback. , (2018).

- Kalampratsidou, V., Kemper, S., Torres, E. B. Real time streaming and closed loop co-adaptive interface to steer multi-layered nervous systems performance. 48th Annual Meeting of Society for Neuroscience. , (2018).

- Kalampratsidou, V., Torres, E. B. Body-brain-avatar interface: a tool to study sensory-motor integration and neuroplasticity. Fourth International Symposium on Movement and Computing, MOCO. 17, (2017).

- Kalampratsidou, V., Torres, E. B. Peripheral Network Connectivity Analyses for the Real-Time Tracking of Coupled Bodies in Motion. Sensors (Basel). 18 (9), (2018).

- Kalampratsidou, V., Zavorskas, M., Albano, J., Kemper, S., Torres, E. B. Dance from the heart: A dance performance of sounds led by the dancer’s heart. Sixth International Symposium on Movement and Computing. , (2019).

- Kalampratsidou, V., Torres, E. B. Outcome measures of deliberate and spontaneous motions. Proceedings of the 3rd International Symposium on Movement and Computing. , 9 (2016).

- Von Holst, E., Mittelstaedt, H., Dodwell, P. C. . Perceptual Processing: Stimulus equivalence and pattern recognition. , 41-72 (1950).

- Torres, E. B., Yanovich, P., Metaxas, D. N. Give spontaneity and self-discovery a chance in ASD: spontaneous peripheral limb variability as a proxy to evoke centrally driven intentional acts. Frontiers in Integrative Neuroscience. 7, 46 (2013).

- Torres, E. B. . Objective Biometric Methods for the Diagnosis and Treatment of Nervous System Disorders. , (2018).

- Torres, E. B., et al. Toward Precision Psychiatry: Statistical Platform for the Personalized Characterization of Natural Behaviors. Frontiers in Neurology. 7, 8 (2016).

- Wu, D., et al. How doing a dynamical analysis of gait movement may provide information about Autism. APS March Meeting Abstracts. , (2017).

- Torres, E. B., et al. Characterization of the statistical signatures of micro-movements underlying natural gait patterns in children with Phelan McDermid syndrome: towards precision-phenotyping of behavior in ASD. Frontiers in Integrative Neuroscience. 10, 22 (2016).

- Kalampratsidou, V. Peripheral Network Connectivity Analyses for the Real-Time Tracking of Coupled Bodies in Motion. Sensors. , (2018).

- Brincker, M., Torres, E. B. Noise from the periphery in autism. Frontiers in Integrative Neuroscience. 7, 34 (2013).

- Torres, E. B., Denisova, K. Motor noise is rich signal in autism research and pharmacological treatments. Scientific Reports. 6, 37422 (2016).