Controllo proxy in tempo reale dei segnali periferici rimizionati utilizzando un'interfaccia a circuito chiuso

Summary

Presentiamo protocolli e metodi di analisi per costruire interfacce co-adattive che tras stream, parametrizzano, analizzano e modificano i segnali del corpo umano e del cuore in loop ravvicinato. Questa configurazione interfaccia i segnali derivati dal sistema nervoso periferico e centrale della persona con ingressi sensoriali esterni per aiutare a tenere traccia del cambiamento biofisico.

Abstract

I campi che sviluppano metodi per la sostituzione sensoriale e l’aumento sensoriale hanno mirato a controllare obiettivi esterni utilizzando segnali del sistema nervoso centrale (SNC). Meno frequenti, tuttavia, sono protocolli che aggiornano i segnali esterni autogenerati da corpi interattivi in movimento. C’è una scarsità di metodi che combinano i bioritmi corpo-cuore-cervello di un agente in movimento per guidare quelli di un altro agente in movimento durante lo scambio diadico. Parte della sfida per realizzare una tale impresa è stata la complessità della configurazione utilizzando bio-segnali multimodali con diverse unità fisiche, scale di tempo disparate e frequenze di campionamento variabili.

Negli ultimi anni, l’avvento di bio-sensori indossabili in grado di sfruttare in modo non invasivo più segnali in tandem, ha aperto la possibilità di ri-parametrizzare e aggiornare i segnali periferici dei diadi interagenti, oltre a migliorare le interfacce cervello e/o corpo-macchina. Qui presentiamo un’interfaccia co-adattiva che aggiorna l’uscita somatico-motoria efferente (inclusa cinematica e frequenza cardiaca) utilizzando biosensori; parametrizza i bio-segnali stocastica, sonifica questa uscita e la alimenta in forma ri-parametrizzata come ingresso reafferente visuo/audio-cinestetico. Illustriamo i metodi usando due tipi di interazioni, una che coinvolge due esseri umani e un’altra che coinvolge un essere umano e il suo avatar che interagiscono quasi in tempo reale. Discutiamo i nuovi metodi nel contesto di possibili nuovi modi per misurare le influenze dell’input esterno sul controllo interno somatico-sensoriale-motorio.

Introduction

Il controller a circuito chiuso naturale

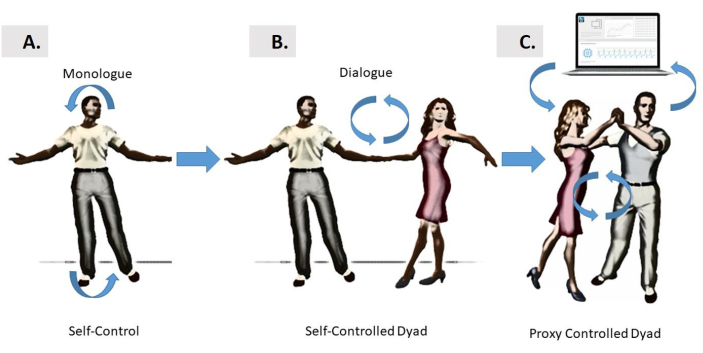

Le informazioni sensoriali-motorie fluiranno continuamente tra il cervello e il corpo per produrre comportamenti ben organizzati e coordinati. Tali comportamenti possono essere studiati concentrandosi solo sulle azioni della persona, come in uno stile monologo (Figura 1A), o durante complesse azioni dinamiche condivise tra due agenti in una diade, come in uno stile di dialogo (Figura 1B). Tuttavia, una terza opzione è quella di valutare interazioni così complesse attraverso un controller proxy, nel contesto di un’interfaccia a circuito chiuso uomo-computer (Figura 1C). Tale interfaccia può tenere traccia delle fluttuazioni dei movimenti momento per momento fornite da ogni agente nel diade, e del tipo di coesione che emerge da sé dalle loro interazioni sincrone, aiutando a guidare i ritmi del diade in modi desiderabili.

Figura 1: Diverse forme di controllo. (A) Le interfacce autocontrolle controllate dal cervello si basano sulle relazioni a circuito stretto tra il cervello della persona e il corpo della persona, che può autoregolarsi e interagire autonomamente in stile “monologo”. Questa modalità tenta il controllo dei movimenti autogenerativi, oppure può anche mirare a controllare i dispositivi esterni. (B) Viene introdotto il controllo dello stile “Dialogue” per due ballerini che interagiscono tra loro e attraverso l’intrappolamento fisico e il turn-taking per ottenere il controllo sui movimenti dell’altro. (C) Il controllo di dialogo “di terze parti” del dyad è introdotto come mediato da un’interfaccia informatica che sfrutta in tandem i bio-segnali di entrambi i ballerini, lo parametrizza e lo rilava ai ballerini in forma ri-parametrizzata utilizzando l’audio e/o la visione come forme di guida sensoriale. La ri-parametrizzazione negli esempi qui presentati è stata ottenuta utilizzando feedback audio o visivi, potenziati dall’uscita cinestetica in tempo reale del motore di uno dei ballerini per influenzare l’altro; o di entrambi i ballerini, a turno in qualche schema alternato. Clicca qui per visualizzare una versione più grande di questa figura.

L’obiettivo generale di questo metodo è dimostrare che è possibile sfruttare, parametrizzare e ri-parametrizzare le fluttuazioni momento per momento nelle attività bioritmiche dei corpi in movimento, poiché due agenti si impegnano in uno scambio diadico che può coinvolgere due esseri umani, o un essere umano e il suo avatar auto-commovente.

Le indagini su come il cervello può controllare le azioni e prevedere le loro conseguenze sensoriali hanno generato molte linee di indagini teoriche negliultimi 1,2,3 e prodotto vari modelli di controllo neuromotorio4,5,6,7,8. Una linea di ricerca in questo campo multidisciplinare ha comportato lo sviluppo di interfacce cervello-macchina a circuito chiuso o cervello-computer. Questi tipi di configurazioni offrono modi per sfruttare e adattare i segnali del SNC per controllare un dispositivo esterno, come un braccio robotico9,10,11,un esoscheletro12,un cursore sullo schermo di un computer13 (tra gli altri). Tutti questi dispositivi esterni condividono la proprietà che non hanno una propria intelligenza. Invece, il cervello che cerca di controllarli ha, e parte del problema che il cervello affronta è imparare a prevedere le conseguenze dei movimenti che genera in questi dispositivi (ad esempio, i movimenti del cursore, i movimenti del braccio robotico, ecc.) generando altri movimenti di supporto che contribuiscono al feedback motorio sensoriale complessivo sotto forma di reafferenza cinestetica. Spesso, lo scopo generale di queste interfacce è stato quello di aiutare la persona dietro quel cervello a bypassare una lesione o un disturbo, a recuperare la trasformazione dei suoi pensieri intenzionali in atti fisici controllati volilmente del dispositivo esterno. Meno comune è stato tuttavia lo sviluppo di interfacce che tentano di guidare i movimenti dei corpi in movimento.

Gran parte della ricerca originale sulle interfacce cervello-macchina si concentra sul controllo del sistema nervoso centrale (SNC) sulle parti del corpo che possono realizzare azioni dirette agliobiettivi 9,14,15,16,17. Vi sono, tuttavia, altre situazioni in cui l’uso dei segnali derivati dalle attività del sistema nervoso periferico (PNS), compresi quelli del sistema nervoso autonomo (ANS), è abbastanza informativo da influenzare e guidare i segnali di agenti esterni, inclusi un altro essere umano o avatar, o persino interagire con gli esseri umani (come nella figura 1C). A differenza di un braccio robotico o di un cursore, l’altro agente in questo caso, ha un’intelligenza guidata da un cervello (nel caso dell’avatar che è stato dotato dei movimenti della persona, o di un altro agente, nel caso di un diade umano interagente).

Una configurazione che crea un ambiente di un’interfaccia co-adattiva a circuito chiuso con scambio diadico può essere di uso per intervenire in disturbi del sistema nervoso in cui il cervello non può controllare volilmente il proprio corpo in movimento a volontà, nonostante non abbia fisicamente reciso il ponte tra il SNC e il PNS. Questo può essere il caso a causa di rumorosi segnali periferici in cui i cicli di feedback per aiutare il cervello a monitorare e regolare continuamente i propri bioritmi autogenerati potrebbero essere stati interrotti. Questo scenario si verifica nei pazienti con morbo di Parkinson18,19o nei partecipanti con disturbi dello spettro autistico con rumore in eccesso nella loro produzione motoria. Infatti, in entrambi i casi, abbiamo quantificato alti livelli di rapporto rumore-segnale nei segnali cinestetici di ritorno derivati dalla velocità dei movimentiprevisti 20,21,22 e dal cuore23. In questi casi, cercare di padroneggiare il controllo cerebrale dei segnali esterni, mentre si cerca anche di controllare il corpo in movimento, può comportare un segnale autoreattore dal flusso di informazioni re-entrante (re-afferent) che il cervello riceve dal flusso motore continuo (efferent) alla periferia. Infatti, le fluttuazioni momento per momento presenti in tale flusso motore efferente autogenerato contengono informazioni importanti utili per aiutare la previsione delle conseguenze sensoriali delle azioni intenzionali24. Quando questo feedback è danneggiato dal rumore, diventa difficile aggiornare prevedibilmente i segnali di controllo e collegare i piani intenzionali con atti fisici.

Se dovessimo estendere tale ciclo di feedback a un altro agente e controllare le interazioni della persona e dell’agente attraverso una terza parte (Figura 1C), potremmo avere la possibilità di guidare le recinte le prestazioni in tempo quasi reale. Questo ci fornirebbe la prova del concetto che avremmo bisogno di estendere la nozione di interfacce co-adattivo cervello-corpo o macchina cerebrale per trattare i disturbi del sistema nervoso che si traducono in una scarsa realizzazione della volontà fisica da intenti mentali.

Le azioni intenzionali hanno conseguenze, che sono precisamente caratterizzate da firme stocastiche motorie che dipendono dal contesto e consentono l’inferenza di livelli di intento mentalecon alta certezza 25,26. Quindi, un vantaggio di un nuovo metodo che sfrutta lo scambio diadadico rispetto ai precedenti approcci incentrati dalla persona alle interfacce della macchina cerebrale o del computer cerebrale, è che possiamo aumentare i segnali di controllo per includere i bioritmi corporei e cardiaci che trasparero in gran parte sotto la consapevolezza della persona, sotto diversi livelli di intento. In questo modo, smorzamo le interferenze reattive che il controllo cosciente tende a evocare nel processo di adattamento del controllo cervello-cursore17. Possiamo aggiungere maggiore certezza al processo predittivo parametrizzando i vari segnali a cui possiamo accedere. In questo senso, il lavoro precedente esiste utilizzando segnali cerebrali e corporei in tandem27,28,29; ma il lavoro che coinvolge interazioni diadiche catturate da segnali corpo-cerebrali rimane scarso. Inoltre, la letteratura esistente deve ancora delineare la distinzione tra segmenti deliberati dell’azione eseguita sotto piena consapevolezza e movimenti transitori che si verificano spontaneamente come conseguenza di quellideliberati 30,31. Qui facciamo questa distinzione nel contesto dello scambio diadico e offriamo nuovi modi per studiare questa dicotomia32, fornendoal contempo esempi di movimenti coreografati (deliberati) vs improvvisati (spontanei) nello spazio della danza.

A causa dei ritardi di trasduzione e trasmissione nei processi di integrazione e trasformazione sensoriale-motoria33, è necessario avere tale codice predittivo in atto, per imparare ad anticipare con alta certezza l’imminente input sensoriale. A tal fine, è importante essere in grado di caratterizzare l’evoluzione del rapporto rumore-segnale derivato dai segnali nel flusso reafferente cinestetico in continuo aggiornamento. Abbiamo quindi bisogno di protocolli per misurare sistematicamente il cambiamento nella variabilità motoria. La variabilità è intrinsecamente presente nelle fluttuazioni momento per momento del flusso motore efferento in uscita34. Poiché questi segnali non sono stazionari e sensibili alle variazioni contestuali35,36, è possibile parametrizzare le modifiche che si verificano con alterazioni del contesto delle attività. Per ridurre al minimo le interferenze dei segnali reattivi che emergono dal controllo consapevole del SNC e per evocare cambiamenti quantificabili nell’efferento flusso motore PNS, introduciamo qui un’interfaccia proxy close-loop che altera indirettamente il feedback sensoriale, reclutando il segnale periferico che sta cambiando in gran parte sotto l’autocoscienza della persona. Mostriamo quindi modi per misurare sistematicamente il cambiamento che ne deriva le manipolazioni sensoriali, utilizzando analisi stocastiche suscettibili di visualizzare il processo che l’interfaccia proxy close-loop evoca indirettamente in entrambi gli agenti.

Introduzione a un controller proxy a ciclo chiuso

La variabilità sensoriale-motoria presente nei segnali periferici costituisce una ricca fonte di informazioni per guidare le prestazioni del sistema nervoso mentre l’apprendimento, l’adattamento e la generalizzazione si svolgono in diversi contesti37. Questi segnali emergono in parte come un sottoprodotto del SNC che cerca di controllare volilmente le azioni, ma non sono l’obiettivo diretto del controller. Poiché la persona interagisce naturalmente con gli altri, i segnali periferici possono essere sfruttati, standardizzati e ri-parametrizzati; il che significa che le loro variazioni possono essere parametrizzate e spostate sistematicamente, poiché si altera il flusso motore efferente che rientra continuamente nel sistema come reafferenza cinestetica. In tali impostazioni, possiamo visualizzare i cambiamenti stocastica, catturando con alta precisione un segnale ricco che altrimenti viene perso per i tipi di grande media che le tecniche più tradizionali eseguono.

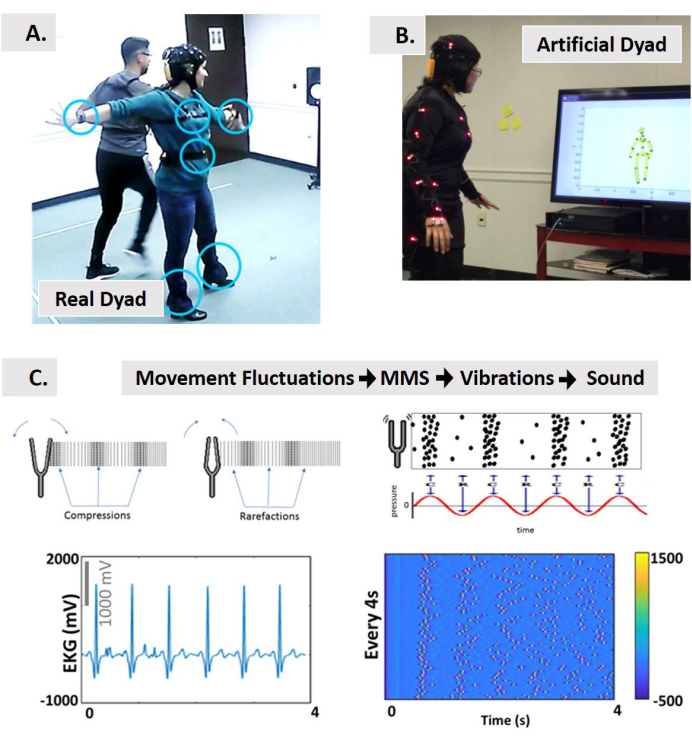

Per ottenere la caratterizzazione del cambiamento sotto la nuova piattaforma statistica, introduciamo qui protocolli, tipi di dati standardizzati e analisi che consentono l’integrazione dell’input sensoriale esterno (uditivo e visivo) con segnali motori autogenerati internamente, mentre la persona interagisce naturalmente con un’altra persona, o con una versione avatar della persona. In questo senso, poiché miriamo a controllare i segnali periferici (piuttosto che modificare i segnali del SNC per controllare direttamente il dispositivo esterno o il supporto), coniamo questa interfaccia proxy close-loop (Figura 2). Miriamo a caratterizzare i cambiamenti nei segnali stocastica del PNS, in quanto hanno un impatto su quelli del SNC.

Figura 2: Controllo proxy diun’interazione diaddica mediante interfaccia multimoso modale a circuito chiuso. (A) Controllo indiretto di due ballerini (salsa danzante) tramite un’interfaccia co-adattiva del computer rispetto a (B) un dyad interattivo artificiale persona-avatar controllato sfruttando i segnali del sistema nervoso periferico e ri-parametrizzandolo come suoni e/o come input visivo. (C) Il concetto di sonificazione mediante un nuovo tipo di dati standardizzato (i picchi di micro-movimento, MMS) derivato dalle fluttuazioni momento per momento nell’ampiezza/temporizzazione dei segnali bioritmici convertiti in vibrazioni e quindi nel suono. Dalla Fisica, prendiamo in prestito le nozioni di compressioni e rarefazioni prodotte da un diapason che emette onde sonore come vibrazioni misurabili. Gli schemi delle onde sonore rappresentati come pressione modulata nel tempo in parallelo alle concentrazioni di picco per la sonificazione. Esempio di segnale fisico per sottoporsi alla tubazione proposta dalla MMS alle vibrazioni e alla sonificazione. Usiamo il segnale di frequenza cardiaca come ingresso all’interfaccia. Ciò richiede fluttuazioni nell’ampiezza del segnale allineate all’inizio del movimento ogni 4 secondi di movimento e costruisce treni MMS che rappresentano le vibrazioni. I treni a spillo della MMS sono standardizzati da [0,1]. Il colore dei picchi in base alla barra dei colori rappresenta l’intensità del segnale. Quindi sonifichiamo queste vibrazioni usando Max. Questo segnale sonificato può essere usato per riprodurre in A, o per alterare in B le interazioni con l’avatar. Inoltre, in B è possibile incorporare il suono nell’ambiente e utilizzare la posizione del corpo per riprodurre il suono in una regione di interesse (RoI), o per modulare le caratteristiche audio in funzione della distanza dal RoI, della velocità o dell’accelerazione di una parte del corpo ancorata a un’altra parte del corpo, quando si passa dal RoI. Clicca qui per visualizzare una versione più grande di questa figura.

I segnali PNS possono essere sfruttati in modo non invasivo con tecnologie di rilevamento indossabili che co-registrano flussi efferenti multimobili da diversi strati funzionali del sistema nervoso, che vanno dall’autonomo alvolontario 32. Possiamo quindi misurare quasi in tempo reale i cambiamenti in tali flussi e selezionare quelli i cui cambiamenti migliorano il rapporto segnale-rumore. Questo segnale motore efferente può quindi essere aumentato con altre forme di guida sensoriale (ad esempio, uditivo, visivo, ecc.) Poiché il PNS segnala la piena consapevolezza, sono più facili da manipolare senza molta resistenza 38. Come tale, li usiamo per aiutare a guidare le prestazioni della persona in modi che potrebbero essere meno stressanti per il sistema umano.

Creazione dell’interfaccia

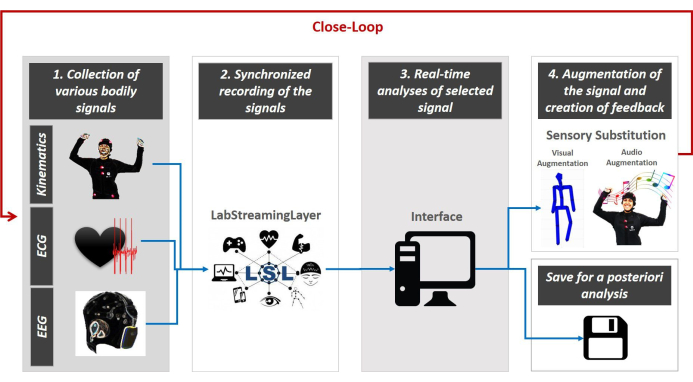

Presentiamo il design del controllo proxy mediato da un’interfaccia multimodale co-adattiva a ciclo ravvicinato. Questa interfaccia guida il feedback multisensorie in tempo reale. Nella figura 3 viene visualizzata la struttura generale.

L’interfaccia a circuito chiuso è caratterizzata da 5 passaggi principali. Il primo passo è la raccolta di dati multimobili da più strumenti indossabili. Il secondo passo è la sincronizzazione dei flussi multimo modali attraverso la piattaforma di LabStreamingLayer (LSL, https://github.com/sccn/labstreaminglayer) sviluppata dal gruppo MoBI 39. Il terzo passo è lo streaming della struttura dati LSL su un Python, MATLAB o altra interfaccia del linguaggio di programmazione per integrare i segnali e parametrizzare empiricamente le caratteristiche fisiologiche (rilevanti per la nostra configurazione sperimentale) in tempo reale. Il quarto passo consiste nel ri-parametrizzare le feature selezionate estratte dal flusso continuo del segnale corporeo studiato e aumentarlo utilizzando una modalità sensoriale di scelta (ad esempio, visiva, uditiva, cinestetica, ecc.) per riprodurlo sotto forma di suoni o immagini, per aumentare, sostituire o migliorare la modalità sensoriale che è problematica nel sistema nervoso della persona. Infine, il 5° passo è quello di rivalutazione delle firme stocastiche dei segnali generati dal sistema in tempo reale, per selezionare quale modalità sensoriale porta i cambiamenti stocastica delle fluttuazioni corporee ad un regime di alta certezza (minimizzazione del rumore) nella previsione delle conseguenze sensoriali dell’azione imminente. Questo ciclo viene riprodotto continuamente per tutta la durata dell’esperimento con l’attenzione sul segnale selezionato, memorizzando le prestazioni complete per le analisi successive (come descritto negli schemi della Figura 3 e vedi40,41,42,43,44,45,46,47 per un esempio di analisi a posteriori).

Figura 3: Architettura del concetto di interfaccia a circuito chiuso multimo modale guidatoperiferico. Vengono raccolti vari segnali corporei- dati cinematici, attività cardiaca e cerebrale (fase 1). LSL viene utilizzato per co-registrare e trasmettere in modo sincrono i dati provenienti da varie apparecchiature all’interfaccia (passaggio 2). Il codice Python/MATLAB/C# viene utilizzato per parametrizzare continuamente le fluttuazioni dei segnali utilizzando un tipo di dati standardizzato e una scala comune che consente di selezionare la fonte di guida sensoriale più adeguata per smorzare l’incertezza del sistema (passaggio 3). Questo miglioramento in tempo reale della trasmissione del segnale attraverso canali selezionati consente quindi la ri-parametrizzazione del segnale sensoriale di re-entrante per integrarsi nel flusso del motore continuo e migliorare il flusso di ingresso perso o danneggiato (passaggio di sostituzione sensoriale 4). La rivalutazione continua chiude il ciclo (passaggio 5) e salviamo tutti i dati per ulteriori analisi future. Clicca qui per visualizzare una versione più grande di questa figura.

Le sezioni seguenti presentano il protocollo generico su come costruire un’interfaccia a circuito chiuso (come descritto nella figura 3) e descrivono i risultati rappresentativi di due interfacce sperimentali (elaborate nel materiale supplementare) che coinvolgono l’interazione diadad fisica tra due ballerini (vero sistema a circuito chiuso) e l’interazione diadad virtuale tra una persona e un avatar (sistema a circuito chiuso artificiale).

Protocol

Representative Results

Discussion

Questo documento introduce il concetto di controllo proxy tramite interfacce co-adattive, interattive e multimo modali a circuito chiuso che sfruttano, parametrizzano e rimozionano il segnale periferico della persona nel contesto dello scambio diadico. Abbiamo mirato a caratterizzare i cambiamenti stocastica nelle fluttuazioni dei bioritmi della persona e a parametrizzare il cambiamento. Inoltre, mirammo a orientare sistematicamente le firme stocastiche dei loro bioritmi verso livelli mirati di regimi rumore-segnale quasi in tempo reale.

Abbiamo presentato un protocollo generico per la costruzione di un’interfaccia a circuito chiuso che soddisfaceva 5 elementi fondamentali: 1) la raccolta di più dati corporei provenienti dal CNS, PNS e ANS utilizzando vari strumenti e tecnologie; 2) la registrazione sincronizzata e lo streaming dei dati; 3) l’analisi in tempo reale dei segnali selezionati; 4) la creazione di un aumento sensoriale (audio, visivo, ecc.) utilizzando caratteristiche fisiologiche estratte per i segnali corporei; e 5) il tracciamento continuo del sistema umano e l’aumento sensoriale parallelo chiude il ciclo dell’interazione tra l’uomo e il sistema.

Il protocollo generico è stato applicato su due interfacce di esempio. Il primo indaga lo scambio diadico tra due agenti umani e il secondo tra un umano e un agente avatar. I due tipi di diadi sono stati usati per fornire la prova del concetto che il segnale periferico può essere cambiato sistematicamente in tempo reale e che questi cambiamenti stocastica possono essere tracciati con precisione. Un dyad era composto da due partecipanti che interagivano fisicamente, mentre l’altro comportava un partecipante che interagiva con un agente virtuale sotto forma di un avatar reso in 3D dotato dei movimenti della persona e di varianti alterate di questi movimenti in tempo reale. Tali alterazioni sono state evocate da manipolazioni interattive guidate da input sensoriali uditivi e / o visivi in un ambiente di sensazioni aumentate. Sia nella dyad reale che nella dyad artificiale, abbiamo dimostrato la fattibilità di spostare a distanza i segnali periferici, inclusi bioritmi corporei e segnali autonomici dal battito cardiaco.

Abbiamo presentato nuovi protocolli sperimentali per sondare tali spostamenti nella variabilità motoria efferente poiché i flussi di segnale cinestetico vengono manipolati e ri-parametrizzati quasi in tempo reale. Queste informazioni di re entrante (reafferenza cinestetica48)si sono rivelate preziose per spostare le prestazioni dei sistemi in tempo reale. Portano informazioni sulle conseguenze sensoriali dell’azione, che possiamo essere tracciati con precisione utilizzando i metodi che abbiamo presentato qui.

Abbiamo anche mostrato tipi di dati e metodi statistici disponibili per standardizzare le nostre analisi. Abbiamo fornito più strumenti di visualizzazione per dimostrare i cambiamenti in tempo reale nelle attività fisiologiche che si evolvono naturalmente in diversi contesti, con inferenza statistica guidata empiricamente che si presta all’interpretazione dei segnali del sistema nervoso autogenerati e autocontrolli. È importante sottolineare che i cambiamenti evocati dal responsabile del proxy sono stati fluidi e tuttavia quantificabili, supportare così l’idea che l’attività periferica sia utile in più di un modo. Mentre possiamo implementare questi metodi utilizzando sensori indossabili wireless disponibili in commercio, possiamo indurre sistematicamente cambiamenti nelle prestazioni che sono catturabili nei ritmi biofisici senza stressare il sistema. È importante tradurre i nostri metodi nell’arena clinica e usarli come banco di prova per sviluppare nuovi modelli di intervento (ad esempio, come quando si utilizza la realtà aumentata nell’autismo 49). In tali modelli, saremo in grado di tracciare e quantificare le conseguenze sensoriali delle azioni naturalistiche della persona, poiché gli ingressi sensoriali sono manipolati con precisione e l’output viene parametrizzato e ri-parametrizzato quasi in tempo reale.

Offriamo questo protocollo come modello generale per utilizzare varie attività bioritmiche autogenerate dal sistema nervoso umano e sfruttate in modo non invasivo con dispositivi indossabili wireless. Sebbene abbiamo usato una serie di biosensori per registrare EEG, ECG e cinematica in questo articolo, i metodi di registrazione, sincronizzazione e analisi dei segnali sono generali. L’interfaccia può quindi incorporare altre tecnologie. Inoltre, i protocolli possono essere modificati per includere altre azioni naturalistiche e contesti che si estendono al campo medico. Poiché abbiamo mirato a comportamenti naturali, la configurazione che abbiamo sviluppato può essere utilizzata in ambienti giocosi (ad esempio, coinvolgendo bambini e genitori).

Diversi disturbi del sistema nervoso potrebbero beneficiare di approcci così giocosi al problema del controllo. In entrambi i tipi di interazioni diadiche che abbiamo mostrato qui, i partecipanti potrebbero mirare a controllare consapevolmente la musica, mentre il controller proxy usa l’output periferico per manipolare inconsciamente e spostare sistematicamente le sue firme. Poiché gli scienziati hanno trascorso anni mappando empiricamente il piano dei parametri Gamma e il corrispondente spazio dei momenti Gamma in diverse fasce d’età (neonati a 78 anni)19,50,51,52,53 e condizioni (autismo, Morbo di Parkinson, ictus, stato coma e sordità), per diversi livelli di controllo (volontario, automatico, spontaneo, involontario e autonomo)25,47,54, hanno criteri empiricamente misurati che denotano dove sugli spazi Gamma le firme stocastiche dovrebbero essere per un buon controllo predittivo. Ricerche precedenti hanno anche dimostrato che sappiamo dove sono i parametri in presenza di rumore casuale spontaneo proveniente dai ritmi autogenerati del sistema nervoso umano7,19,55,56. All’interno di uno schema di ottimizzazione che minimizza il rumore del motore bioritmico, possiamo quindi mirare a guidare i segnali in modo tale da raggiungere le aree mirate degli spazi Gamma in cui la forma e le firme di dispersione della famiglia di PDF di ogni persona favoriscono un elevato rapporto segnale/rumore e valori predittivi. In questo senso, non perdiamo dati lordi e li usiamo in modo efficace per guidare il sistema verso livelli desiderabili di rumore all’interno di una determinata situazione.

Le interazioni diadiche sono onnipresenti in contesti clinici o di allenamento. Possono verificarsi tra il formatore e il tirocinante; il medico e il paziente; il terapista clinico e il paziente; e possono anche verificarsi in contesti di ricerca che coinvolgono la scienza traslizionale e coinvolgono il ricercatore e il partecipante. Uno dei vantaggi dei protocolli attuali è che mentre sono progettati per i diadi, sono anche personalizzati. Come tale, è possibile adattare le interazioni co-adattive alle migliori capacità e predisposizioni della persona, in base ai loro intervalli di movimento, ai loro intervalli di tempi di elaborazione sensoriale e considerando gli intervalli nell’ampiezza dei segnali attraverso la gerarchia funzionale del sistema nervoso della persona. Man mano che la traiettoria stocastica emerge ed evolve nel tempo, è anche possibile accertare i tassi di probabilità delle firme e utilizzare tali serie temporali per prevedere diversi eventi imminenti insieme a possibili conseguenze sensoriali.

Infine, le interfacce a circuito chiuso potrebbero essere utilizzate anche nel mondo dell’arte. Potrebbero offrire agli artisti che si esibiscono nuove strade per generare forme computaziche di danze moderne, danze tecnologiche e nuove forme di visualizzazione e sonificazione dell’espressione corporea. In tali contesti, il corpo del ballerino può essere trasformato in uno strumento a guida sensoriale per esplorare in modo flessibile diverse modalità sensoriali attraverso la sonificazione e la visualizzazione delle attività bioritmiche autogenerati, come dimostrato dal lavoro precedente inquest’area 40,41,43,46. Tale performance potrebbe aumentare il ruolo di un ballerino sul palco e lasciare che il pubblico sperimenti sottili segnali corporei oltre il movimento visibile.

Diversi aspetti di questa tecnologia richiedono ulteriore sviluppo e test per ottimizzarne l’utilizzo in tempo reale. Lo streaming sincrono richiede potenza e capacità di memoria della CPU/GPU ad alta velocità per sfruttare davvero la nozione di guadagnare tempo ed essere un passo avanti quando si prevedono le conseguenze sensoriali dei comandi motori in corso. Le frequenze di campionamento dell’apparecchiatura dovrebbero essere comparabili per poter realmente allineare i segnali, eseguire una corretta fusione sensoriale ed esplorare la trasmissione di informazioni attraverso i diversi canali del sistema nervoso. Queste sono alcune delle limitazioni presenti in questa nuova interfaccia.

Tutto e tutto ciò, questo lavoro offre un nuovo concetto per migliorare il controllo del nostro sistema corporeo impiegando al contempo mezzi subliminali che tuttavia consentono misurazioni sistematiche standardizzate dei risultati del cambiamento stocastico.

Disclosures

The authors have nothing to disclose.

Acknowledgements

Ringraziamo gli studenti che si sono offerti volontari per contribuire a svolgere questa ricerca; per averci fornito immagini e video necessari per descrivere l’insieme; neuroelettronica per averci permesso di utilizzare materiale proveniente dal canale www.youtube.com/c/neuroelectrics/ e dai loro manuali. Infine, ringraziamo il Prof. Thomas Papathomas del Rutgers Center for Cognitive Science per il supporto professionale durante le fasi di presentazione di questo manoscritto, nancy lurie marks family foundation career development award all’EBT e il Gerondelis Foundation Award a VK.

Contributi

Concettualizzazione, VK ed EBT; metodologia, EBT; software, VK, EBT, SK.; convalida, VK e SK; analisi formale, VK; indagine, VK, EBT, SK; risorse, EBT; cura dei dati, VK; scrittura – preparazione originale del progetto, EBT; scrittura: revisione e modifica, VK, SK.; visualizzazione, VK ed EBT.; vigilanza, EBT.; amministrazione dei progetti, EBT.; acquisizione del finanziamento, EBT Tutti gli autori hanno letto e accettato la versione pubblicata del manoscritto.

Materials

| Enobio 32 | Enobio | Hardware for EEG data collection | |

| Enobio ECG Extention | Enobio | Hardware for ECG data collection | |

| LabStreamingLayer (LSL) | Synchronization and streaming of data | ||

| Matlab | Mathwork | Analysis and processing of data | |

| Max | Cycling'74 | Sonification of bodily information | |

| NIC.2 | Enobio | Software for EEG and ECG data collection | |

| PhaseSpace Impulse | PhaseSpace | Hardware for collection of the kinematic data (position, speed, acceleration) | |

| Python3 | Python | Analysis and processing of data | |

| Recap | PhaseSpace | Software for collection of the kinematic data (position, speed, acceleration) |

References

- Kawato, M., Wolpert, D. Internal models for motor control. Novartis Foundation Symposium. 218, 291-304 (1998).

- Wolpert, D. M., Kawato, M. Multiple paired forward and inverse models for motor control. Neural Networks. 11 (7-8), 1317-1329 (1998).

- Wolpert, D. M., Miall, R. C., Kawato, M. Internal models in the cerebellum. Trends in Cognitive Sciences. 2 (9), 338-347 (1998).

- Todorov, E., Jordan, M. I. Optimal feedback control as a theory of motor coordination. Nature Neuroscience. 5 (11), 1226-1235 (2002).

- Todorov, E. Optimality principles in sensorimotor control. Nature Neuroscience. 7 (9), 907-915 (2004).

- Torres, E. B. . Theoretical Framework for the Study of Sensori-motor Integration. , (2001).

- Harris, C. M., Wolpert, D. M. Signal-dependent noise determines motor planning. Nature. 394 (20), 780-784 (1998).

- Torres, E. B., Zipser, D. Reaching to Grasp with a Multi-jointed Arm (I): A Computational Model. Journal of Neurophysiology. 88, 1-13 (2002).

- Carmena, J. M., et al. Learning to control a brain-machine interface for reaching and grasping by primates. PLoS Biology. 1 (2), 42 (2003).

- Hwang, E. J., Andersen, R. A. Cognitively driven brain machine control using neural signals in the parietal reach region. 2010 Annual International Conference of the IEEE Engineering in Medicine and Biology. 2010, 3329-3332 (2010).

- Andersen, R. A., Kellis, S., Klaes, C., Aflalo, T. Toward more versatile and intuitive cortical brain-machine interfaces. Current Biology. 24 (18), 885-897 (2014).

- Contreras-Vidal, J. L., et al. Powered exoskeletons for bipedal locomotion after spinal cord injury. Journal of Neural Engineering. 13 (3), 031001 (2016).

- Choi, K., Torres, E. B. Intentional signal in prefrontal cortex generalizes across different sensory modalities. Journal of Neurophysiology. 112 (1), 61-80 (2014).

- Hwang, E. J., Andersen, R. A. Cognitively driven brain machine control using neural signals in the parietal reach region. 2010 Annual International Conference of the IEEE Engineering in Medicine and Biology. 2010, 3329-3332 (2010).

- Andersen, R. A., Kellis, S., Klaes, C., Aflalo, T. Toward more versatile and intuitive cortical brain-machine interfaces. Current Biology. 24 (18), 885-897 (2014).

- Contreras-Vidal, J. L., et al. Powered exoskeletons for bipedal locomotion after spinal cord injury. Journal of Neural Engineering. 13 (3), 031001 (2016).

- Choi, K., Torres, E. B. Intentional signal in prefrontal cortex generalizes across different sensory modalities. Journal of Neurophysiology. 112 (1), 61-80 (2014).

- Yanovich, P., Isenhower, R. W., Sage, J., Torres, E. B. Spatial-orientation priming impedes rather than facilitates the spontaneous control of hand-retraction speeds in patients with Parkinson’s disease. PLoS One. 8 (7), 66757 (2013).

- Torres, E. B., Cole, J., Poizner, H. Motor output variability, deafferentation, and putative deficits in kinesthetic reafference in Parkinson’s disease. Frontiers in Human Neuroscience. 8, 823 (2014).

- Torres, E. B., et al. Toward Precision Psychiatry: Statistical Platform for the Personalized Characterization of Natural Behaviors. Frontiers in Human Neuroscience. 7, 8 (2016).

- Torres, E. B., Cole, J., Poizner, H. Motor output variability, deafferentation, and putative deficits in kinesthetic reafference in Parkinson’s disease. Frontiers in Human Neuroscience. 8, 823 (2014).

- Torres, E. B., et al. Autism: the micro-movement perspective. Frontiers in Integrative Neuroscience. 7, 32 (2013).

- Ryu, J., Vero, J., Torres, E. B. . MOCO ’17: Proceedings of the 4th International Conference on Movement Computing. , 1-8 (2017).

- Brincker, M., Torres, E. B. Noise from the periphery in autism. Frontiers in Integrative Neuroscience. 7, 34 (2013).

- Torres, E. B. Two classes of movements in motor control. Experimental Brain Research. 215 (3-4), 269-283 (2011).

- Torres, E. B. Signatures of movement variability anticipate hand speed according to levels of intent. Behavioral and Brain Functions. 9, 10 (2013).

- Gramann, K., et al. Cognition in action: imaging brain/body dynamics in mobile humans. Reviews in the Neurosciences. 22 (6), 593-608 (2011).

- Makeig, S., Gramann, K., Jung, T. P., Sejnowski, T. J., Poizner, H. Linking brain, mind and behavior. International Journal of Psychophysiology. 73 (2), 95-100 (2009).

- Ojeda, A., Bigdely-Shamlo, N., Makeig, S. MoBILAB: an open source toolbox for analysis and visualization of mobile brain/body imaging data. Frontiers in Human Neuroscience. 8, 121 (2014).

- Casadio, M., et al. . IEEE International Conference on Rehabilitation Robotics. , (2019).

- Pierella, C., Sciacchitano, A., Farshchiansadegh, A., Casadio, M., Mussaivaldi, S. A. . 7th IEEE International Conference on Biomedical Robotics and Biomechatronics. , (2018).

- Torres, E. B. Two classes of movements in motor control. Experimental Brain Research. 215 (3-4), 269-283 (2011).

- Purves, D. . Neuroscience. Sixth edition. , (2018).

- Torres, E. B. Signatures of movement variability anticipate hand speed according to levels of intent. Behavioral and Brain Functions. 9, 10 (2013).

- Torres, E. B. The rates of change of the stochastic trajectories of acceleration variability are a good predictor of normal aging and of the stage of Parkinson’s disease. Frontiers in Integrative Neuroscience. 7, 50 (2013).

- Torres, E. B., Vero, J., Rai, R. Statistical Platform for Individualized Behavioral Analyses Using Biophysical Micro-Movement Spikes. Sensors (Basel). 18 (4), (2018).

- Torres, E. B. . Progress in Motor Control. , 229-254 (2016).

- Torres, E. B., Yanovich, P., Metaxas, D. N. Give spontaneity and self-discovery a chance in ASD: spontaneous peripheral limb variability as a proxy to evoke centrally driven intentional acts. Frontiers in Integrative Neuroscience. 7, 46 (2013).

- Gramann, K., Jung, T. P., Ferris, D. P., Lin, C. T., Makeig, S. Toward a new cognitive neuroscience: modeling natural brain dynamics. Frontiers in Human Neuroscience. 8, 444 (2014).

- Kalampratsidou, V., Torres, E. B. Bodily Signals Entrainment in the Presence of Music. Proceedings of the 6th International Conference on Movement and Computing. , (2019).

- Kalampratsidou, V., Torres, E. B. Sonification of heart rate variability can entrain bodies in motion. Proceedings of the 7th International Conference on Movement and Computing. , (2020).

- Kalampratsidou, V. . Co-adaptive multimodal interface guided by real-time multisensory stochastic feedback. , (2018).

- Kalampratsidou, V., Kemper, S., Torres, E. B. Real time streaming and closed loop co-adaptive interface to steer multi-layered nervous systems performance. 48th Annual Meeting of Society for Neuroscience. , (2018).

- Kalampratsidou, V., Torres, E. B. Body-brain-avatar interface: a tool to study sensory-motor integration and neuroplasticity. Fourth International Symposium on Movement and Computing, MOCO. 17, (2017).

- Kalampratsidou, V., Torres, E. B. Peripheral Network Connectivity Analyses for the Real-Time Tracking of Coupled Bodies in Motion. Sensors (Basel). 18 (9), (2018).

- Kalampratsidou, V., Zavorskas, M., Albano, J., Kemper, S., Torres, E. B. Dance from the heart: A dance performance of sounds led by the dancer’s heart. Sixth International Symposium on Movement and Computing. , (2019).

- Kalampratsidou, V., Torres, E. B. Outcome measures of deliberate and spontaneous motions. Proceedings of the 3rd International Symposium on Movement and Computing. , 9 (2016).

- Von Holst, E., Mittelstaedt, H., Dodwell, P. C. . Perceptual Processing: Stimulus equivalence and pattern recognition. , 41-72 (1950).

- Torres, E. B., Yanovich, P., Metaxas, D. N. Give spontaneity and self-discovery a chance in ASD: spontaneous peripheral limb variability as a proxy to evoke centrally driven intentional acts. Frontiers in Integrative Neuroscience. 7, 46 (2013).

- Torres, E. B. . Objective Biometric Methods for the Diagnosis and Treatment of Nervous System Disorders. , (2018).

- Torres, E. B., et al. Toward Precision Psychiatry: Statistical Platform for the Personalized Characterization of Natural Behaviors. Frontiers in Neurology. 7, 8 (2016).

- Wu, D., et al. How doing a dynamical analysis of gait movement may provide information about Autism. APS March Meeting Abstracts. , (2017).

- Torres, E. B., et al. Characterization of the statistical signatures of micro-movements underlying natural gait patterns in children with Phelan McDermid syndrome: towards precision-phenotyping of behavior in ASD. Frontiers in Integrative Neuroscience. 10, 22 (2016).

- Kalampratsidou, V. Peripheral Network Connectivity Analyses for the Real-Time Tracking of Coupled Bodies in Motion. Sensors. , (2018).

- Brincker, M., Torres, E. B. Noise from the periphery in autism. Frontiers in Integrative Neuroscience. 7, 34 (2013).

- Torres, E. B., Denisova, K. Motor noise is rich signal in autism research and pharmacological treatments. Scientific Reports. 6, 37422 (2016).