Echtzeit-Proxy-Steuerung von re-parametrisierten Peripheriesignalen über eine Close-Loop-Schnittstelle

Summary

Wir präsentieren Protokolle und Methoden von Analysen, um koadaptive Schnittstellen zu erstellen, die menschliche Körper- und Herzsignale in enger Schleife streamen, parametrisieren, analysieren und modifizieren. Dieses Setup verbindet Signale, die vom peripheren und zentralen Nervensystem der Person abgeleitet werden, mit externen sensorischen Eingängen, um biophysikalische Veränderungen zu verfolgen.

Abstract

Die Bereiche, die Methoden zur sensorischen Substitution und sensorischen Augmentation entwickeln, zielen darauf ab, externe Ziele mit Signalen des Zentralnervensystems (ZNS) zu steuern. Weniger häufig sind jedoch Protokolle, die externe Signale aktualisieren, die von interaktiven Körpern in Bewegung selbst generiert werden. Es gibt einen Mangel an Methoden, die den Körper-Herz-Hirn-Biorhythmen eines beweglichen Agenten kombinieren, um die eines anderen beweglichen Agenten während des dyadischen Austauschs zu steuern. Ein Teil der Herausforderung, eine solche Leistung zu vollbringen, war die Komplexität des Setups mit multimodalen Biosignalen mit verschiedenen physikalischen Einheiten, unterschiedlichen Zeitskalen und variablen Sampling-Frequenzen.

In den letzten Jahren hat das Aufkommen tragbarer Biosensoren, die mehrere Signale nicht invasiv im Tandem nutzen können, die Möglichkeit eröffnet, die peripheren Signale interagierender Dyaden neu zu parametrisieren und zu aktualisieren, zusätzlich zur Verbesserung der Gehirn- und/oder Körper-Maschinen-Schnittstellen. Hier stellen wir eine koadaptive Schnittstelle vor, die die effiziente somatic-motorische Leistung (einschließlich Kinematik und Herzfrequenz) mit Biosensoren aktualisiert; parametriert die stochastischen Biosignale, sonifiziert diesen Ausgang und speist sie in reparametrisierter Form als visuo/audio-kinesthetischer reafferent Eingang zurück. Wir veranschaulichen die Methoden anhand von zwei Arten von Interaktionen, von denen eine zwei Menschen und eine mit einem Menschen und seinem Avatar, der in nahezu Echtzeit interagiert, beteiligt sind. Wir diskutieren die neuen Methoden im Kontext möglicher neuer Methoden zur Messung der Einflüsse externer Eingaben auf die interne somatic-sensorische Motorsteuerung.

Introduction

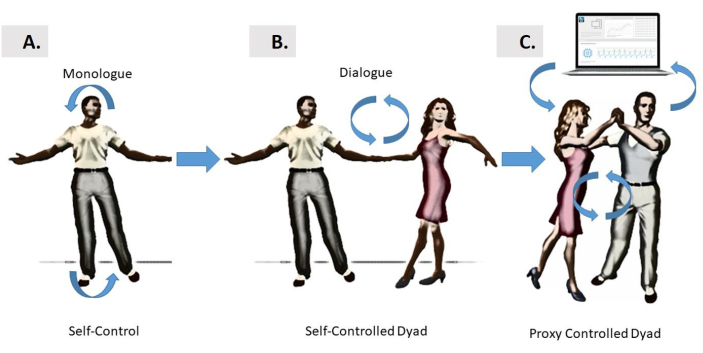

Der natürliche Close-Loop-Controller

Sensorisch-motorische Informationen fließen kontinuierlich zwischen Gehirn und Körper, um gut organisierte, koordinierte Verhaltensweisen zu erzeugen. Solche Verhaltensweisen können untersucht werden, während man sich auf die Handlungen der Person allein konzentriert, wie in einem Monologstil (Abbildung 1A), oder bei komplexen dynamischen Aktionen, die von zwei Agenten in einer Dydegeteilten geteilt werden, wie in einem Dialogstil (Abbildung 1B). Eine dritte Möglichkeit besteht jedoch darin, solche komplexen Interaktionen über einen Proxy-Controller im Kontext einer Nahschleifenschnittstelle zwischen Mensch und Computer zu bewerten (Abbildung 1C). Eine solche Schnittstelle kann die Moment-für-Moment-Bewegungen Schwankungen verfolgen, die von jedem Agenten in der Dyade beigesteuert werden, und durch die Art von Kohäsivität, die sich aus ihren synchronen Interaktionen ergibt, und dabei helfen, die Rhythmen der Dyade auf wünschenswerte Weise zu steuern.

Abbildung 1: Verschiedene Formen der Kontrolle. (A) Selbst hirngesteuerte Schnittstellen basieren auf den engen Beziehungen zwischen dem Gehirn der Person und dem eigenen Körper, die sich selbst regulieren und selbst interagieren können im “Monolog”-Stil. Dieser Modus versucht die Steuerung von selbst generierten Bewegungen, oder es kann auch darauf abzielen, externe Geräte zu steuern. (B) Die Stilsteuerung “Dialog” wird für zwei Tänzer eingeführt, die miteinander interagieren, und durch physische einzuschlagende und umgedrehte Bewegungen, um die Kontrolle über die Bewegungen des jeweils anderen zu erlangen. (C) Die Dialogsteuerung der Dyade wird durch eine Computerschnittstelle vermittelt, die die Biosignale beider Tänzer zusammen nutzt, parametriert und den Tänzern in reparaparatorisierter Form mit Audio und/oder Vision als Formen sensorischer Führung zuführt. Die Reparametrierung in den hier vorgestellten Beispielen wurde durch Audio- oder visuelles Feedback erreicht, verstärkt durch die echtzeit-kinesthetische Motorleistung eines der Tänzer, um den anderen zu beeinflussen; oder von beiden Tänzern, abwechselnd in wechselnden Mustern. Bitte klicken Sie hier, um eine größere Version dieser Abbildung anzuzeigen.

Das übergeordnete Ziel dieser Methode ist es, zu zeigen, dass es möglich ist, die Moment-für-Moment-Schwankungen in den biorhythmischen Aktivitäten von Körpern in Bewegung zu nutzen, zu parametrierisieren und neu zu parametrisieren, da zwei Agenten einen dyadischen Austausch betreiben, an dem zwei Menschen oder ein Mensch und sein/ihr sich selbst bewegender Avatar beteiligt sein können.

Untersuchungen darüber, wie das Gehirn Aktionen steuern und ihre sensorischen Folgen vorhersagen kann, haben in der Vergangenheit viele Zeilen theoretischer Untersuchungen in der Vergangenheit1,2,3 und produziert verschiedene Modelle der neuromotorischen Steuerung4,5,6,7,8. Eine Forschungslinie in diesem multidisziplinären Bereich umfasste die Entwicklung von Nahschleifen-Gehirn-Maschine- oder Gehirn-Computer-Schnittstellen. Diese Arten von Setups bieten Möglichkeiten, die CNS-Signale zu nutzen und anzupassen, um ein externes Gerät zu steuern, wie z. B. einen Roboterarm9,10,11, ein Exoskelett12, einen Cursor auf einem Computerbildschirm13 (unter anderem). Alle diese externen Geräte teilen die Eigenschaft, dass sie keine eigene Intelligenz haben. Stattdessen hat das Gehirn, das versucht, sie zu kontrollieren, und ein Teil des Problems, mit dem das Gehirn konfrontiert ist, zu lernen, wie man die Folgen der Bewegungen vorhersagt, die es in diesen Geräten erzeugt (z. B. die Bewegungen des Cursors, die Bewegungen des Roboterarms usw.), während andere unterstützende Bewegungen erzeugt werden, die zur allgemeinen sensorischen motorischen Rückkopplung in Form von kinesthetischem Rückfall beitragen. Oft war das übergeordnete Ziel dieser Schnittstellen, der Person hinter diesem Gehirn zu helfen, eine Verletzung oder Störung zu umgehen, die Transformation ihrer absichtlichen Gedanken in volitional kontrollierte körperliche Handlungen des externen Geräts wiederzuerlangen. Weniger verbreitet ist jedoch die Entwicklung von Schnittstellen, die versuchen, die Bewegungen von Körpern in Bewegung zu lenken.

Ein Großteil der ursprünglichen Forschung auf Gehirn-Maschine-Schnittstellen konzentrieren sich auf die Kontrolle des zentralen Nervensystems (ZNS) über Körperteile, die zielgerichteteAktionen9,14,15,16,17erreichen können. Es gibt jedoch andere Situationen, in denen die Verwendung der Signale, die von Aktivitäten des peripheren Nervensystems (PNS) abgeleitet werden, einschließlich der Signale des autonomen Nervensystems (ANS), informativ genug ist, um die Signale externer Wirkstoffe zu beeinflussen und zu steuern, einschließlich eines anderen Menschen oder Avatars oder sogar interagierender Menschen (wie in Abbildung 1C). Anders als bei einem Roboterarm oder -cursor verfügt der andere Agent in diesem Fall über Intelligenz, die von einem Gehirn angetrieben wird (im Fall des Avatars, der mit den Bewegungen der Person oder eines anderen Agenten ausgestattet ist, im Falle einer interagierenden menschlichen Dyade).

Ein Setup, das eine Umgebung einer koadaptiven Nahschleifenschnittstelle mit dyadischem Austausch schafft, kann von Nutzen sein, um bei Störungen des Nervensystems einzugreifen, wobei das Gehirn den eigenen Körper nicht freiwillig nach Belieben steuern kann, obwohl es die Brücke zwischen ZNS und PNS nicht physisch durchtrennt hat. Dies kann aufgrund lauter peripherer Signale der Fall sein, bei denen die Rückkopplungsschleifen, um das Gehirn kontinuierlich zu überwachen und seine eigenen selbst erzeugten Biorhythmen anzupassen, gestört worden sein könnten. Dieses Szenario tritt bei Patienten mit Parkinson-Krankheit18,19, oder bei Teilnehmern mit Autismus-Spektrum-Störungen mit übermäßigem Rauschen in ihrer motorischen Leistung. In beiden Fällen haben wir in den zurückkehrenden kinesthetischen Signalen, die aus der Geschwindigkeit ihrer beabsichtigten Bewegungen20,21,22 und aus dem Herzenabgeleitetwerden, ein hohes Geräusch-Signal-Verhältnis quantifiziert. In solchen Fällen kann der Versuch, die Gehirnsteuerung externer Signale zu beherrschen, während gleichzeitig versucht wird, den Körper in Bewegung zu steuern, zu einem selbstreaktiven Signal des wiedereintretenden (wiedereintretenden) Informationsstroms führen, den das Gehirn vom kontinuierlichen (effedünnen) Motorstrom an der Peripherie erhält. Tatsächlich enthalten die Moment-für-Moment-Schwankungen in einem solchen selbsterzeugten effetierischen Motorstrom wichtige Informationen, die nützlich sind, um die Vorhersage der sensorischen Folgen zielgerichteter Handlungen zu unterstützen24. Wenn dieses Feedback durch Rauschen beschädigt wird, wird es schwierig, die Steuersignale vorhersagbar zu aktualisieren und absichtliche Pläne mit physischen Handlungen zu überbrücken.

Wenn wir eine solche Feedback-Schleife auf einen anderen Agenten ausdehnen und die Interaktionen der Person und des Agenten über einen Dritten steuern würden(Abbildung 1C), hätten wir möglicherweise die Möglichkeit, die Leistungen des anderen in nahezu Echtzeit zu steuern. Dies würde uns den Beweis des Konzepts liefern, dass wir den Begriff der ko-adaptiven Gehirn-Körper- oder Gehirn-Maschine-Schnittstellen erweitern müssten, um Störungen des Nervensystems zu behandeln, die zu einer schlechten Realisierung körperlicher Willensfähigkeit aus geistiger Absicht führen.

Gezielte Handlungen haben Folgen, die gerade durch motorisch-stochastische Signaturen gekennzeichnet sind, die kontextabhängig sind und mit hoher Sicherheit Rückschlüsse auf mentale Absichtsniveaus ermöglichen25,26. Ein Vorteil einer neuen Methode, die den dyadischen Austausch gegenüber früheren personenzentrierten Ansätzen an die Gehirnmaschine oder die Computerschnittstellen des Gehirns nutzt, besteht darin, dass wir die Kontrollsignale erweitern können, um den Körper- und Herzbiorhythmus einzubeziehen, der sich weitgehend unter dem Bewusstsein der Person unter verschiedenen Ebenen der Absicht abspielt. Auf diese Weise dämpfen wir reaktive Interferenzen, die bewusste Kontrolle bei der Anpassung der Hirncursorsteuerung tendenziell hervorruft17. Wir können dem Vorhersageprozess mehr Sicherheit verleihen, indem wir die verschiedenen Signale parametrieren, auf die wir zugreifen können. In diesem Sinne gibt es vorarbeiten mit Gehirn- und Körpersignalen im Tandem27,28,29; aber Arbeit mit dyadischen Interaktionen, die von Gehirn-Körper-Signalen erfasst werden, bleibt rar. Darüber hinaus hat die bestehende Literatur noch nicht die Unterscheidung zwischen absichtlichen Abschnitten der Handlung unter vollem Bewusstsein und Übergangsbewegungen, die spontan als Folge der absichtlichen30,31auftreten. Hier machen wir diese Unterscheidung im Kontext des dyadischen Austauschs und bieten neue Möglichkeiten, diese Dichotomie zu studieren32, während wir Beispiele für choreographierte (absichtliche) vs. improvisierte (spontane) Bewegungen im Tanzraum anbieten.

Aufgrund der Transduktions- und Übertragungsverzögerungen in den sensorisch-motorischen Integrations- und Transformationsprozessen33ist es notwendig, einen solchen Vorhersagecode an Ort und Stelle zu haben, um zu lernen, bevorstehende sensorische Eingaben mit hoher Sicherheit zu antizipieren. Zu diesem Zweck ist es wichtig, die Entwicklung des Geräusch-Signal-Verhältnisses zu charakterisieren, das von Signalen im sich ständig aktualisierenden kinesthetischen reafferenten Strom abgeleitet wird. Wir brauchen dann Protokolle, um die Veränderung der Motorvariabilität systematisch zu messen. Die Variabilität ist inhärent in den Moment-für-Moment-Schwankungen des ausgehenden effedünnen Motorstroms34vorhanden. Da diese Signale nicht stationär und empfindlich auf kontextuelle Variationen35,36sind, ist es möglich, Änderungen zu parametrierieren, die mit Änderungen des Aufgabenkontexts auftreten. Um Interferenzen durch reaktive Signale, die aus der bewussten ZNS-Steuerung entstehen, zu minimieren und quantifizierbare Veränderungen im effedünnen PNS-Motorstrom hervorzurufen, führen wir hier eine Proxy-Close-Loop-Schnittstelle ein, die indirekt das sensorische Feedback verändert, indem wir das periphere Signal rekrutieren, das sich weitgehend unter dem Selbstbewusstsein der Person ändert. Wir zeigen dann Möglichkeiten auf, die Veränderung, die die sensorischen Manipulationen durchführt, systematisch zu messen, indem wir stochastische Analysen verwenden, die geeignet sind, den Prozess zu visualisieren, den die Proxy-Close-Loop-Schnittstelle indirekt in beiden Agenten hervorruft.

Einführung eines Proxy Close-Loop Controllers

Die sensorisch-motorische Variabilität in den peripheren Signalen stellt eine reiche Informationsquelle dar, die die Leistung des Nervensystems leiten kann, während Lernen, Anpassung und Verallgemeinerung in verschiedenen Kontexten stattfinden37. Diese Signale treten teilweise als Nebenprodukt des ZNS hervor, das versucht, Aktionen volitativ zu steuern, sind aber nicht das direkte Ziel des Controllers. Da die Person natürlich mit anderen interagiert, können die peripheren Signale genutzt, standardisiert und neu parametrisiert werden; d.h. ihre Variationen können parametriert und systematisch verschoben werden, da man den effedünnen Motorstrom, der kontinuierlich als kinesthetische Referenz in das System eindringt, ändert. In solchen Einstellungen können wir die stochastischen Verschiebungen visualisieren und mit hoher Präzision ein reichhaltiges Signal erfassen, das ansonsten an die Arten von grand averaging verloren geht, die traditionellere Techniken ausführen.

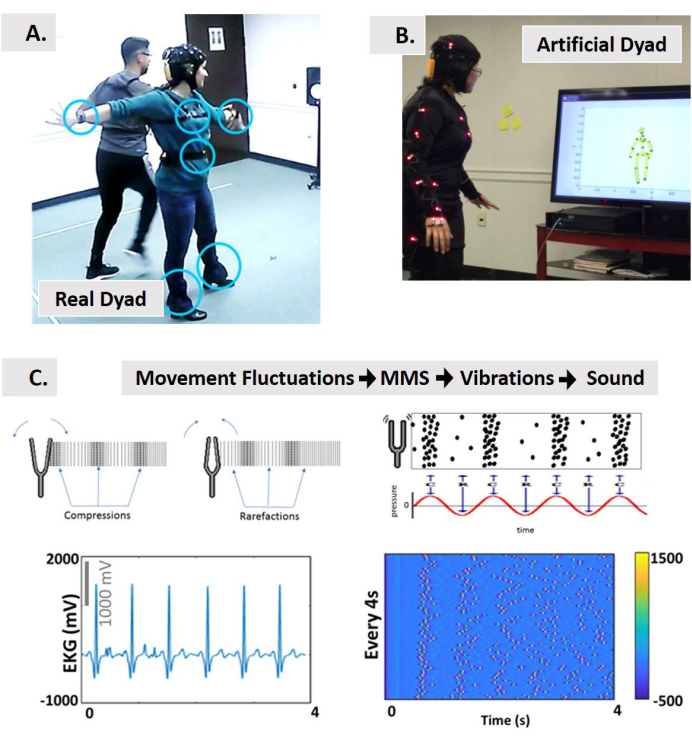

Um die Charakterisierung des Wandels unter der neuen statistischen Plattform zu erreichen, führen wir hier Protokolle, standardisierte Datentypen und Analysen ein, die die Integration externer sensorischer Eingaben (auditorisch und visuell) mit intern selbst generierten motorischen Signalen ermöglichen, während die Person natürlich mit einer anderen Person oder mit einer Avatarversion der Person interagiert. In diesem Sinne, weil wir darauf abzielen, die peripheren Signale zu steuern (anstatt die CNS-Signale zu ändern, um das externe Gerät oder Medien direkt zu steuern), koinieren wir dies eine Proxy-Close-Loop-Schnittstelle (Abbildung 2). Unser Ziel ist es, die Veränderungen in den stochastischen Signalen des PNS zu charakterisieren, da sie sich auf die im ZNS auswirken.

Abbildung 2: Proxy-Steuerung einer dyadischen Interaktion mit nahschleifenübergreifender multimodaler Schnittstelle. (A) Indirekte Steuerung von zwei Tänzern (tanzende Salsa) über eine Computer-Ko-adaptive Schnittstelle vs. (B) eine interaktive künstliche Personen-Avatar-Dya, die durch die Nutzung der Signale des peripheren Nervensystems gesteuert wird und sie als Sounds und/oder als visuelle Eingabe neu parametrisiert. (C) Das Konzept der Sonifikation mit einem neuen standardisierten Datentyp (die Mikrobewegungsspitzen, MMS) abgeleitet von den Moment-für-Moment-Schwankungen der biorhythmischen Signale Amplitude/Timing in Vibrationen und dann in Ton umgewandelt. Aus der Physik entlehnt man uns die Begriffe Kompressionen und Seltenheiten, die von einer Stimmgabel erzeugt werden, die Schallwelle als messbare Schwingungen ausgibt. Schemata von Schallwellen, die im Laufe der Zeit parallel zu Spitzenkonzentrationen zur Sonifikation als Druck moduliert dargestellt werden. Beispiel für ein physikalisches Signal, das die vorgeschlagene Pipeline von MMS zu Vibrationen und Sonifikation enthoniert werden soll. Wir verwenden das Herzfrequenzsignal als Eingang zur Schnittstelle. Dies nimmt Schwankungen in der Amplitude des Signals, die alle 4 Sekunden der Bewegung ausgerichtet sind, und baut MMS-Züge, die die Vibrationen darstellen. Die Spike-Züge des MMS sind ab [0,1] standardisiert. Die Farbe der Spitzen gemäß der Farbleiste stellt die Intensität des Signals dar. Wir sonifizieren diese Schwingungen dann mit Max. Dieses sonifizierte Signal kann verwendet werden, um in A wiederzugeben oder in B die Interaktionen mit dem Avatar zu ändern. Darüber hinaus ist es in B möglich, den Klang in die Umgebung einzubetten und die Körperposition zu verwenden, um den Klang in einem Bereich von Interesse (RoI) wieder abzuspielen, oder die Audio-Features als Funktion der Entfernung zum RoI, der Geschwindigkeit oder Beschleunigung eines Anliegerteils zu modulieren, wenn es am RoI vorbeigeht. Bitte klicken Sie hier, um eine größere Version dieser Abbildung anzuzeigen.

Die PNS-Signale können nicht-invasiv mit tragbaren Sensortechnologien genutzt werden, die multimodale effetierische Ströme aus verschiedenen funktionellen Schichten des Nervensystems, von autonombis zu freiwilligen32, ko-registrieren. Wir können dann in nahezu Echtzeit die Änderungen in solchen Streams messen und diejenigen auswählen, deren Änderungen das Signal-Rausch-Verhältnis verbessern. Dieses effevermotorische Signal kann dann durch andere Formen der sensorischen Führung (z.B. auditiv, visuell usw.) ergänzt werden. Da das PNS Landschaftsbewusstsein signalisiert, sind sie ohne großen Widerstand leichter zu manipulieren 38. Als solche verwenden wir sie, um die Leistung der Person auf eine Weise zu steuern, die für das menschliche System weniger belastend sein kann.

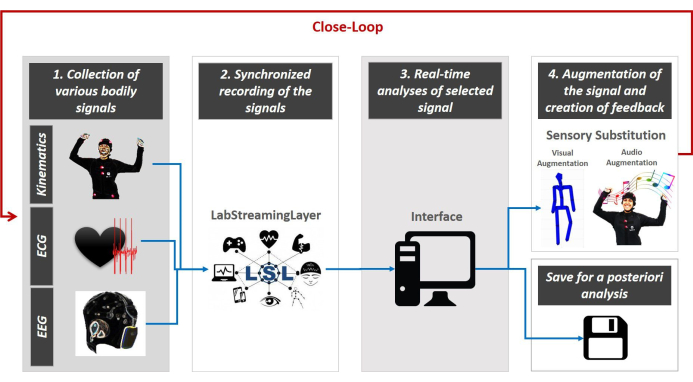

Erstellen der Schnittstelle

Wir präsentieren das Design der Proxy-Steuerung, die durch eine close-loop co-adaptive multimodale Schnittstelle vermittelt wird. Diese Schnittstelle steuert das multisensorische Feedback in Echtzeit. Abbildung 3 zeigt den allgemeinen Entwurf.

Die Close-Loop-Schnittstelle zeichnet sich durch 5 Hauptschritte aus. Der erste Schritt ist die multimodale Datenerfassung von mehreren tragbaren Instrumenten. Der zweite Schritt ist die Synchronisation der multimodalen Streams über die Plattform von LabStreamingLayer (LSL, https://github.com/sccn/labstreaminglayer) entwickelt von der MoBI-Gruppe 39. Der dritte Schritt ist das Streaming der LSL-Datenstrukturan eine Python-, MATLAB- oder andere Programmiersprachenschnittstelle, um die Signale zu integrieren und die physiologischen Merkmale (relevant für unseren experimentellen Aufbau) in Echtzeit empirisch zu parametrisieren. Der vierte Schritt besteht darin, die ausgewählten Features, die aus dem kontinuierlichen Strom des untersuchten Körpersignals extrahiert werden, neu zu parametrisieren und es mit einer sensorischen Modalität der Wahl (z. B. visuell, auditiv, kinesthetisch usw.) zu erweitern, um es in Form von Klängen oder Visuals wiederzugeben, um die sensorische Modalität, die im Nervensystem der Person problematisch ist, zu erweitern, zu ersetzen oder zu verbessern. Schließlich besteht der 5. Schritt darin, die stochastischen Signaturen der vom System erzeugten Signale in Echtzeit neu zu bewerten, um auszuwählen, welche sensorische Modalität die stochastischen Verschiebungen der körperlichen Schwankungen zu einem Regime hoher Sicherheit (Lärmminimierung) bei der Vorhersage der sensorischen Folgen der bevorstehenden Aktion bringt. Diese Schleife wird während der gesamten Dauer des Experiments kontinuierlich mit dem Fokus auf das ausgewählte Signal gespielt, während die volle Leistung für nachfolgende Analysen gespeichert wird (wie in den Schaltplänen von Abbildung 3 dargestellt und siehe40,41,42,43,44,45,46,47 für ein Beispiel für eine posteriori Analysen).

Abbildung 3:Die Architektur des multimodalen, peripheriegesteuerten Nahschleifen-Schnittstellenkonzepts. Verschiedene Körpersignale werden gesammelt -kinematische Daten, Herz- und Gehirnaktivität (Schritt 1). LSL wird verwendet, um die Daten, die von verschiedenen Geräten kommen, synchron mit zu registrieren und zu streamen, an die Schnittstelle (Schritt 2). Python/MATLAB/C-Code wird verwendet, um die Schwankungen in den Signalen kontinuierlich zu parametrieren, indem ein standardisierter Datentyp und eine gemeinsame Skala verwendet werden, die die Auswahl der Quelle der sensorischen Führung ermöglicht, die am besten geeignet ist, die Unsicherheit des Systems zu dämpfen (Schritt 3). Diese Echtzeit-Verbesserung der Signalübertragung durch ausgewählte Kanäle ermöglicht dann eine erneute Parametrierung des wieder eintretenden Sensorsignals, um sich in den kontinuierlichen Motorstrom zu integrieren und den verlorenen oder beschädigten Eingangsstrom zu verbessern (sensorischer Ersetzungsschritt 4). Kontinuierliche Neubewertung schließt die Schleife (Schritt 5) und wir speichern alle Daten für weitere zukünftige Analysen. Bitte klicken Sie hier, um eine größere Version dieser Abbildung anzuzeigen.

Die folgenden Abschnitte stellen das allgemeine Protokoll zum Erstellen einer Close-Loop-Schnittstelle (wie in Abbildung 3beschrieben) dar und beschreiben repräsentative Ergebnisse zweier experimenteller Schnittstellen (aufwendig dargestellt in Supplementary Material), die eine physikalische dyadische Interaktion zwischen zwei Tänzern (reales Close-Loop-System) und eine virtuelle dyadische Interaktion zwischen einer Person und einem Avatar (künstliches Nahschleifensystem) beinhalten.

Protocol

Representative Results

Discussion

Dieses Papier stellt das Konzept der Proxy-Steuerung über close-loop co-adaptive, interaktive, multi-modale Schnittstellen vor, die das periphere Signal der Person im Kontext des dyadischen Austauschs nutzen, parametrisieren und neu parametrisieren. Wir zielten darauf ab, stochastische Verschiebungen in den Schwankungen des Biorhythmus der Person zu charakterisieren und die Veränderung zu parametriert. Darüber hinaus zielten wir darauf ab, die stochastischen Signaturen ihres Biorhythmus systematisch auf gezielte Pegelvon Lärm-Signal-Regime in nahezu Echtzeit zu lenken.

Wir präsentierten ein generisches Protokoll zum Aufbau einer Close-Loop-Schnittstelle, die 5 Kernelemente erfüllte: 1) die Sammlung mehrerer Körperdaten aus dem CNS, PNS und ANS mit verschiedenen Instrumenten und Technologien; 2) die synchronisierte Aufzeichnung und das Streaming der Daten; 3) die Echtzeitanalyse der ausgewählten Signale; 4) die Schaffung einer sensorischen Augmentation (Audio, visuell, etc.) mit physiologischen Merkmalen für die Körpersignale extrahiert; und 5) die kontinuierliche Verfolgung des menschlichen Systems und die parallele sensorische Augmentation schließt die Schleife der Interaktion zwischen Mensch und System.

Das generische Protokoll wurde auf zwei Beispielschnittstellen angewendet. Der erste untersucht den dyadischen Austausch zwischen zwei menschlichen Agenten und den zweiten zwischen einem Menschen und einem Avataragenten. Die beiden Arten von Dyaden wurden verwendet, um den Beweis des Konzepts zu liefern, dass das periphere Signal systematisch in Echtzeit geändert werden kann und dass diese stochastischen Veränderungen präzise verfolgt werden können. Eine Dyade bestand aus zwei Teilnehmern, die physisch interagierten, während der andere einen Teilnehmer beteiligte, der mit einem virtuellen Agenten in Form eines 3D-gerenderten Avatars interagierte, der mit den Bewegungen der Person und mit veränderten Varianten dieser Echtzeitbewegungen ausgestattet war. Solche Veränderungen wurden durch interaktive Manipulationen ausgelöst, die durch auditive und/oder visuelle sensorische Eingaben in einer Einstellung von Augmented Sensationen angetrieben wurden. Sowohl in der echten Dyade als auch in der künstlichen Dyade haben wir die Machbarkeit der Fernverschiebung der peripheren Signale, einschließlich des körperiellen Biorhythmus und der autonomen Signale aus dem Herzschlag, demonstriert.

Wir haben neue experimentelle Protokolle vorgestellt, um solche Verschiebungen in efferent motorischer Variabilität zu untersuchen, da die kinesthetischen Signalströme in nahezu Echtzeit manipuliert und neu parametrisiert werden. Diese Wiedereintrittsinformationen (kinesthetic reafference48) erwiesen sich als wertvoll, um die Systemleistung in Echtzeit zu verändern. Sie enthalten Informationen über die sensorischen Folgen der Aktion, die wir mit den hier vorgestellten Methoden genau verfolgen können.

Wir zeigten auch Datentypen und statistische Methoden, die zur Standardisierung unserer Analysen geeignet sind. Wir stellten mehrere Visualisierungswerkzeuge zur Verfügung, um die Echtzeit-Veränderungen physiologischer Aktivitäten zu demonstrieren, die sich natürlich in verschiedenen Kontexten entwickeln, mit empirisch geführten statistischen Schlussfolgerungen, die sich für die Interpretation der selbstgenerierten und selbstgesteuerten Signale des Nervensystems eignen. Wichtig ist, dass die Vom Proxy-Controller heraufbeschworenen Änderungen reibungslos und dennoch quantifizierbar waren, was die Vorstellung unterstützt, dass periphere Aktivitäten in mehr als einer Weise nützlich sind. Während wir diese Methoden mit kommerziell erhältlichen drahtlosen tragbaren Sensoren implementieren können, können wir systematisch Leistungsänderungen induzieren, die in den biophysikalischen Rhythmen gekappt werden können, ohne das System zu belasten. Es ist wichtig, unsere Methoden in die klinische Arena zu übersetzen und sie als Teststand zu verwenden, um neue Interventionsmodelle zu entwickeln (z.B. bei der Verwendung von Augmented Reality bei Autismus 49). In solchen Modellen werden wir in der Lage sein, die sensorischen Folgen der naturalistischen Handlungen der Person zu verfolgen und zu quantifizieren, da die sensorischen Eingänge präzise manipuliert werden und der Ausgang parametriert und nahezu in Echtzeit neu parametriert wird.

Wir bieten dieses Protokoll als allgemeines Modell an, um verschiedene biorhythmische Aktivitäten zu nutzen, die selbst vom menschlichen Nervensystem erzeugt und nicht-invasiv mit drahtlosen Wearables genutzt werden. Obwohl wir eine Reihe von Biosensoren verwendet haben, um EEG, EKG und Kinematik in diesem Papier zu registrieren, sind die Methoden zur Aufzeichnung, Synchronisierung und Analyse der Signale allgemein. Die Schnittstelle kann somit andere Technologien integrieren. Darüber hinaus können die Protokolle so geändert werden, dass sie andere naturalistische Aktionen und Kontexte enthalten, die sich auf den medizinischen Bereich erstrecken. Da wir auf natürliches Verhalten ausgerichtet sind, kann das Setup, das wir entwickelt haben, in spielerischen Umgebungen (z.B. unter Einbeziehung von Kindern und Eltern) verwendet werden.

Mehrere Störungen des Nervensystems könnten von solchen spielerischen Ansätzen zum Kontrollproblem profitieren. In beiden Arten von dyadischen Interaktionen, die wir hier gezeigt haben, konnten die Teilnehmer darauf abzielen, die Musik bewusst zu steuern, während der Proxy-Controller den peripheren Ausgang nutzt, um seine Signaturen unbewusst zu manipulieren und systematisch zu verschieben. Da Wissenschaftler jahrelang empirisch die Gamma-Parameterebene und den entsprechenden Gamma-Momentraum über verschiedene Altersgruppen (Neonate bis 78 Jahre)19,50,51,52,53 und Bedingungen (Autismus, Parkinson-Krankheit, Schlaganfall, Komazustand und Taubstummkeit), für verschiedene Kontrollebenen (freiwillig, automatisch, spontan, unfreiwillig und autonom)25,47,54, haben sie empirisch gemessene Kriterien, die angeben, wo auf den Gamma-Räumen die stochastischen Signaturen für eine gute Prädiktionskontrolle sein sollten. Frühere Forschungen haben auch gezeigt, dass wir wissen, wo die Parameter in Gegenwart von spontanen zufälligen Lärm aus den selbst erzeugten Rhythmen der menschlichen Nervensysteme7,19,55,56kommen. Innerhalb eines Optimierungsschemas zur Minimierung biorhythmischer Motorgeräusche können wir so darauf abzielen, die Signale so anzutreiben, dass die Zielbereiche der Gamma-Räume erreicht werden, in denen die Form- und Dispersionssignaturen der PDFs-Familie jeder Person ein hohes Signal-Rausch-Verhältnis und Vorhersagewerte begünstigen. In diesem Sinne verlieren wir keine Bruttodaten, sondern nutzen sie effektiv, um das System in einer bestimmten Situation auf wünschenswerte Lärmpegel zu treiben.

Dyadische Wechselwirkungen sind in klinischen oder Trainingsumgebungen allgegenwärtig. Sie können zwischen dem Ausbilder und dem Auszubildenden auftreten; den Arzt und den Patienten; den klinischen Therapeuten und den Patienten; und sie können auch in Forschungsumgebungen auftreten, die translationale Wissenschaft einbeziehen und den Forscher und den Teilnehmer einbeziehen. Einer der Vorteile der vorliegenden Protokolle ist, dass sie zwar für Dyaden entwickelt sind, aber auch personalisiert sind. Als solche ist es möglich, die koadaptiven Interaktionen an die besten Fähigkeiten und Veranlagungen der Person anzupassen, entsprechend ihren Bewegungsbereichen, ihren Bereichen der sensorischen Verarbeitungszeiten und unter Berücksichtigung der Bereiche in der Amplitude der Signale über die funktionelle Hierarchie des Nervensystems der Person. Wenn die stochastische Flugbahn entsteht und sich mit der Zeit entwickelt, ist es auch möglich, die Zufallsraten der Signaturen zu ermitteln und diese Zeitreihen zu nutzen, um mehrere bevorstehende Ereignisse zusammen mit möglichen sensorischen Folgen vorherzusagen.

Schließlich könnten Close-Loop-Schnittstellen sogar in der Kunstwelt eingesetzt werden. Sie könnten darstellenden Künstlern neue Wege bieten, um rechnergesteuerte Formen moderner Tänze, Technologietänze und neue Formen der Visualisierung und Sonifizierung des körperlichen Ausdrucks zu generieren. In solchen Kontexten kann der Körper des Tänzers in ein sensorisch getriebenes Instrument verwandelt werden, um durch Sonifizierung und Visualisierung der selbst erzeugten biorhythmischen Aktivitäten flexibel verschiedene sensorische Modalitäten zu erforschen, wie frühere Arbeiten in diesem Bereich40,41,43,46zeigen. Eine solche Performance könnte die Rolle eines Tänzers auf der Bühne verstärken und dem Publikum subtile Körpersignale jenseits der sichtbaren Bewegung erleben.

Mehrere Aspekte dieser Technologie erfordern Weiterentwicklung und Tests, um deren Einsatz in Echtzeiteinstellungen zu optimieren. Das synchrone Streaming erfordert Hochgeschwindigkeits-CPU/GPU-Leistung und Speicherkapazität, um die Vorstellung, Zeit zu gewinnen und einen Schritt voraus zu sein, bei der Vorhersage der sensorischen Folgen der laufenden Motorbefehle wirklich auszunutzen. Die Abtastraten der Geräte sollten vergleichbar sein, um die Signale wirklich ausrichten, eine ordnungsgemäße sensorische Fusion durchführen und die Übertragung von Informationen über die verschiedenen Kanäle des Nervensystems untersuchen zu können. Dies sind einige der Einschränkungen, die in dieser neuen Schnittstelle vorhanden sind.

Alles in allem bietet diese Arbeit ein neues Konzept, um die Kontrolle unseres Körpersystems zu verbessern und gleichzeitig unterschwellige Mittel einzusetzen, die dennoch systematisch eisstandardisierte Ergebnismessungen stochastischer Veränderungen ermöglichen.

Disclosures

The authors have nothing to disclose.

Acknowledgements

Wir danken den Studenten, die sich freiwillig für diese Forschung zur Verfügung stehen; Kan Anant und die PhaseSpace Inc. für die Bereitstellung von Bildern und Videos, die notwendig sind, um die Einrichtung zu beschreiben; und Neuroelektronik, um uns zu ermöglichen, Material aus dem Kanal www.youtube.com/c/neuroelectrics/ und deren Handbüchern zu verwenden. Abschließend danken wir Prof. Thomas Papathomas vom Rutgers Center for Cognitive Science für die professionelle Unterstützung während der Einreichungsphase dieses Manuskripts, Nancy Lurie Marks Family Foundation Career Development Award an EBT und den Gerondelis Foundation Award an VK.

Beiträge

Konzeptualisierung, VK und EBT; Methodik, EBT; Software, VK, EBT, SK.; Validierung, VK und SK; formale Analyse, VK; Untersuchung, VK, EBT, SK; Ressourcen, EBT; Datenkuration, VK; Schreiben – Original-Entwurfsvorbereitung, EBT; Schreiben – Überprüfung und Bearbeitung, VK, SK.; Visualisierung, VK und EBT.; Aufsicht, EBT.; Projektverwaltung, EBT.; EBT Alle Autoren haben die veröffentlichte Fassung des Manuskripts gelesen und zugestimmt.

Materials

| Enobio 32 | Enobio | Hardware for EEG data collection | |

| Enobio ECG Extention | Enobio | Hardware for ECG data collection | |

| LabStreamingLayer (LSL) | Synchronization and streaming of data | ||

| Matlab | Mathwork | Analysis and processing of data | |

| Max | Cycling'74 | Sonification of bodily information | |

| NIC.2 | Enobio | Software for EEG and ECG data collection | |

| PhaseSpace Impulse | PhaseSpace | Hardware for collection of the kinematic data (position, speed, acceleration) | |

| Python3 | Python | Analysis and processing of data | |

| Recap | PhaseSpace | Software for collection of the kinematic data (position, speed, acceleration) |

References

- Kawato, M., Wolpert, D. Internal models for motor control. Novartis Foundation Symposium. 218, 291-304 (1998).

- Wolpert, D. M., Kawato, M. Multiple paired forward and inverse models for motor control. Neural Networks. 11 (7-8), 1317-1329 (1998).

- Wolpert, D. M., Miall, R. C., Kawato, M. Internal models in the cerebellum. Trends in Cognitive Sciences. 2 (9), 338-347 (1998).

- Todorov, E., Jordan, M. I. Optimal feedback control as a theory of motor coordination. Nature Neuroscience. 5 (11), 1226-1235 (2002).

- Todorov, E. Optimality principles in sensorimotor control. Nature Neuroscience. 7 (9), 907-915 (2004).

- Torres, E. B. . Theoretical Framework for the Study of Sensori-motor Integration. , (2001).

- Harris, C. M., Wolpert, D. M. Signal-dependent noise determines motor planning. Nature. 394 (20), 780-784 (1998).

- Torres, E. B., Zipser, D. Reaching to Grasp with a Multi-jointed Arm (I): A Computational Model. Journal of Neurophysiology. 88, 1-13 (2002).

- Carmena, J. M., et al. Learning to control a brain-machine interface for reaching and grasping by primates. PLoS Biology. 1 (2), 42 (2003).

- Hwang, E. J., Andersen, R. A. Cognitively driven brain machine control using neural signals in the parietal reach region. 2010 Annual International Conference of the IEEE Engineering in Medicine and Biology. 2010, 3329-3332 (2010).

- Andersen, R. A., Kellis, S., Klaes, C., Aflalo, T. Toward more versatile and intuitive cortical brain-machine interfaces. Current Biology. 24 (18), 885-897 (2014).

- Contreras-Vidal, J. L., et al. Powered exoskeletons for bipedal locomotion after spinal cord injury. Journal of Neural Engineering. 13 (3), 031001 (2016).

- Choi, K., Torres, E. B. Intentional signal in prefrontal cortex generalizes across different sensory modalities. Journal of Neurophysiology. 112 (1), 61-80 (2014).

- Hwang, E. J., Andersen, R. A. Cognitively driven brain machine control using neural signals in the parietal reach region. 2010 Annual International Conference of the IEEE Engineering in Medicine and Biology. 2010, 3329-3332 (2010).

- Andersen, R. A., Kellis, S., Klaes, C., Aflalo, T. Toward more versatile and intuitive cortical brain-machine interfaces. Current Biology. 24 (18), 885-897 (2014).

- Contreras-Vidal, J. L., et al. Powered exoskeletons for bipedal locomotion after spinal cord injury. Journal of Neural Engineering. 13 (3), 031001 (2016).

- Choi, K., Torres, E. B. Intentional signal in prefrontal cortex generalizes across different sensory modalities. Journal of Neurophysiology. 112 (1), 61-80 (2014).

- Yanovich, P., Isenhower, R. W., Sage, J., Torres, E. B. Spatial-orientation priming impedes rather than facilitates the spontaneous control of hand-retraction speeds in patients with Parkinson’s disease. PLoS One. 8 (7), 66757 (2013).

- Torres, E. B., Cole, J., Poizner, H. Motor output variability, deafferentation, and putative deficits in kinesthetic reafference in Parkinson’s disease. Frontiers in Human Neuroscience. 8, 823 (2014).

- Torres, E. B., et al. Toward Precision Psychiatry: Statistical Platform for the Personalized Characterization of Natural Behaviors. Frontiers in Human Neuroscience. 7, 8 (2016).

- Torres, E. B., Cole, J., Poizner, H. Motor output variability, deafferentation, and putative deficits in kinesthetic reafference in Parkinson’s disease. Frontiers in Human Neuroscience. 8, 823 (2014).

- Torres, E. B., et al. Autism: the micro-movement perspective. Frontiers in Integrative Neuroscience. 7, 32 (2013).

- Ryu, J., Vero, J., Torres, E. B. . MOCO ’17: Proceedings of the 4th International Conference on Movement Computing. , 1-8 (2017).

- Brincker, M., Torres, E. B. Noise from the periphery in autism. Frontiers in Integrative Neuroscience. 7, 34 (2013).

- Torres, E. B. Two classes of movements in motor control. Experimental Brain Research. 215 (3-4), 269-283 (2011).

- Torres, E. B. Signatures of movement variability anticipate hand speed according to levels of intent. Behavioral and Brain Functions. 9, 10 (2013).

- Gramann, K., et al. Cognition in action: imaging brain/body dynamics in mobile humans. Reviews in the Neurosciences. 22 (6), 593-608 (2011).

- Makeig, S., Gramann, K., Jung, T. P., Sejnowski, T. J., Poizner, H. Linking brain, mind and behavior. International Journal of Psychophysiology. 73 (2), 95-100 (2009).

- Ojeda, A., Bigdely-Shamlo, N., Makeig, S. MoBILAB: an open source toolbox for analysis and visualization of mobile brain/body imaging data. Frontiers in Human Neuroscience. 8, 121 (2014).

- Casadio, M., et al. . IEEE International Conference on Rehabilitation Robotics. , (2019).

- Pierella, C., Sciacchitano, A., Farshchiansadegh, A., Casadio, M., Mussaivaldi, S. A. . 7th IEEE International Conference on Biomedical Robotics and Biomechatronics. , (2018).

- Torres, E. B. Two classes of movements in motor control. Experimental Brain Research. 215 (3-4), 269-283 (2011).

- Purves, D. . Neuroscience. Sixth edition. , (2018).

- Torres, E. B. Signatures of movement variability anticipate hand speed according to levels of intent. Behavioral and Brain Functions. 9, 10 (2013).

- Torres, E. B. The rates of change of the stochastic trajectories of acceleration variability are a good predictor of normal aging and of the stage of Parkinson’s disease. Frontiers in Integrative Neuroscience. 7, 50 (2013).

- Torres, E. B., Vero, J., Rai, R. Statistical Platform for Individualized Behavioral Analyses Using Biophysical Micro-Movement Spikes. Sensors (Basel). 18 (4), (2018).

- Torres, E. B. . Progress in Motor Control. , 229-254 (2016).

- Torres, E. B., Yanovich, P., Metaxas, D. N. Give spontaneity and self-discovery a chance in ASD: spontaneous peripheral limb variability as a proxy to evoke centrally driven intentional acts. Frontiers in Integrative Neuroscience. 7, 46 (2013).

- Gramann, K., Jung, T. P., Ferris, D. P., Lin, C. T., Makeig, S. Toward a new cognitive neuroscience: modeling natural brain dynamics. Frontiers in Human Neuroscience. 8, 444 (2014).

- Kalampratsidou, V., Torres, E. B. Bodily Signals Entrainment in the Presence of Music. Proceedings of the 6th International Conference on Movement and Computing. , (2019).

- Kalampratsidou, V., Torres, E. B. Sonification of heart rate variability can entrain bodies in motion. Proceedings of the 7th International Conference on Movement and Computing. , (2020).

- Kalampratsidou, V. . Co-adaptive multimodal interface guided by real-time multisensory stochastic feedback. , (2018).

- Kalampratsidou, V., Kemper, S., Torres, E. B. Real time streaming and closed loop co-adaptive interface to steer multi-layered nervous systems performance. 48th Annual Meeting of Society for Neuroscience. , (2018).

- Kalampratsidou, V., Torres, E. B. Body-brain-avatar interface: a tool to study sensory-motor integration and neuroplasticity. Fourth International Symposium on Movement and Computing, MOCO. 17, (2017).

- Kalampratsidou, V., Torres, E. B. Peripheral Network Connectivity Analyses for the Real-Time Tracking of Coupled Bodies in Motion. Sensors (Basel). 18 (9), (2018).

- Kalampratsidou, V., Zavorskas, M., Albano, J., Kemper, S., Torres, E. B. Dance from the heart: A dance performance of sounds led by the dancer’s heart. Sixth International Symposium on Movement and Computing. , (2019).

- Kalampratsidou, V., Torres, E. B. Outcome measures of deliberate and spontaneous motions. Proceedings of the 3rd International Symposium on Movement and Computing. , 9 (2016).

- Von Holst, E., Mittelstaedt, H., Dodwell, P. C. . Perceptual Processing: Stimulus equivalence and pattern recognition. , 41-72 (1950).

- Torres, E. B., Yanovich, P., Metaxas, D. N. Give spontaneity and self-discovery a chance in ASD: spontaneous peripheral limb variability as a proxy to evoke centrally driven intentional acts. Frontiers in Integrative Neuroscience. 7, 46 (2013).

- Torres, E. B. . Objective Biometric Methods for the Diagnosis and Treatment of Nervous System Disorders. , (2018).

- Torres, E. B., et al. Toward Precision Psychiatry: Statistical Platform for the Personalized Characterization of Natural Behaviors. Frontiers in Neurology. 7, 8 (2016).

- Wu, D., et al. How doing a dynamical analysis of gait movement may provide information about Autism. APS March Meeting Abstracts. , (2017).

- Torres, E. B., et al. Characterization of the statistical signatures of micro-movements underlying natural gait patterns in children with Phelan McDermid syndrome: towards precision-phenotyping of behavior in ASD. Frontiers in Integrative Neuroscience. 10, 22 (2016).

- Kalampratsidou, V. Peripheral Network Connectivity Analyses for the Real-Time Tracking of Coupled Bodies in Motion. Sensors. , (2018).

- Brincker, M., Torres, E. B. Noise from the periphery in autism. Frontiers in Integrative Neuroscience. 7, 34 (2013).

- Torres, E. B., Denisova, K. Motor noise is rich signal in autism research and pharmacological treatments. Scientific Reports. 6, 37422 (2016).